Bienvenue invité ( Connexion | Inscription )

|

24 Mar 2023, 12:42 24 Mar 2023, 12:42

Message

#61

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

Le seul bémol que je verrais à cette evolution est que les SSD "est périssable" bien plus rapidement que un HDD... (sauf choc mécanique). Non, vraiment non. La durée de vie a énormément augmenté sur les SSD, ce fut une nouvelle technologie et il y a eu d'immenses progrès faits, pour la fiabiliser tout en augmentant les capacités, les performances et en abaissant les coûts! Aujourd'hui encore, certains ne savent pas faire un bon firmware, et il y a donc certains stockages Flash "SSD" bien moins bons que d'autres, mais en général l'endurance réelle augmente, et est pour moi largement au-dessus de celle des disques durs utilisés au quotidien. Plus la charge de travail en lecture est importante, plus ils creusent l'écart, encore plus si ce sont des accès pseudo-aléatoires. Dans un datacenter par exemple, on s'attend à une durée de vie de 3 ans avec moins de 10% de taux de panne au total, pour chacun, mais sur ces 3 ans ils réaliseront 10 fois plus de travail qu'un disque dur, voire bien plus encore sur une DB. C'est pour ça que j'avais remplacé un array de disques 2.5" par des Intel X25-E sur un serveur, pour me débarrasser au passage du NAS associé (à disques durs lui aussi), en ayant des performances 10X supérieures en IO, et c'était en 2011! On a eu besoin de le resynchroniser avec un autre serveur situé 5000 km plus loin, à plusieurs reprises à cause d'un gougnaffié salopant notre travail, une très grosse DB, et ça se faisait à une vitesse incroyable, limitée seulement par les ports Ethernet 1Gb/s du serveur! |

|

|

|

24 Mar 2023, 15:37 24 Mar 2023, 15:37

Message

#62

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 2 153 Inscrit : 26 Apr 2004 Membre no 18 117 |

Le seul bémol que je verrais à cette evolution est que les SSD "est périssable" bien plus rapidement que un HDD... (sauf choc mécanique). Non, vraiment non. La durée de vie a énormément augmenté sur les SSD, ce fut une nouvelle technologie et il y a eu d'immenses progrès faits, pour la fiabiliser tout en augmentant les capacités, les performances et en abaissant les coûts! Aujourd'hui encore, certains ne savent pas faire un bon firmware, et il y a donc certains stockages Flash "SSD" bien moins bons que d'autres, mais en général l'endurance réelle augmente, et est pour moi largement au-dessus de celle des disques durs utilisés au quotidien. Plus la charge de travail en lecture est importante, plus ils creusent l'écart, encore plus si ce sont des accès pseudo-aléatoires. Dans un datacenter par exemple, on s'attend à une durée de vie de 3 ans avec moins de 10% de taux de panne au total, pour chacun, mais sur ces 3 ans ils réaliseront 10 fois plus de travail qu'un disque dur, voire bien plus encore sur une DB. C'est pour ça que j'avais remplacé un array de disques 2.5" par des Intel X25-E sur un serveur, pour me débarrasser au passage du NAS associé (à disques durs lui aussi), en ayant des performances 10X supérieures en IO, et c'était en 2011! On a eu besoin de le resynchroniser avec un autre serveur situé 5000 km plus loin, à plusieurs reprises à cause d'un gougnaffié salopant notre travail, une très grosse DB, et ça se faisait à une vitesse incroyable, limitée seulement par les ports Ethernet 1Gb/s du serveur! Au fait en raid 5 , les ssd cela doit dépotés , non ? Je me demande ce que cela donne en raid 50 , vue que j'ai des ssd de 250 go ... |

|

|

|

24 Mar 2023, 15:47 24 Mar 2023, 15:47

Message

#63

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

... Au fait en raid 5 , les ssd cela doit dépotés , non ? Je me demande ce que cela donne en raid 50 , vue que j'ai des ssd de 250 go ... C'était en RAID-0, avec un disque dur pour l'écriture des logs de la DB (MySQL), pour maximiser les performances en garantissant la restaurabilité en cas de panne d'un SSD ou de plusieurs, la latence des écritures du log ainsi que le débit des écritures du log (non-garantis par ces SSD, mais garantis par le disque dur pro en écriture séquentielle). Et ça dépotait en écritures aléatoires, et évidemment en lecture aussi. J'avais remplacé un NAS à $15000 USD par $3000 USD de SSD, en allant bien bien plus vite. En étant moins sûr en revanche. Aujourd'hui, cette charge de travail serait absorbé les doigts dans le nez de tout stockage Flash "SSD", sans besoin de RAID-0 ni de sa baie, même un SSD grand-public économique! Alors qu'en terme de disques durs, le même nombre serait grosso-merdo nécessaires, pour aller énormément moins vite. PS: j'ai utilisé beaucoup de contrôleur RAID "matériels" (c'est du soft sur un SoC déporté) depuis les années 90, et ceux créés pour les disques durs étaient inadéquats pour des SSD, créant un goulot d'étranglement, sans parler de leur communication trop lente avec la CPU. Ça a maintenant changé! Ce message a été modifié par iAPX - 24 Mar 2023, 16:12. |

|

|

|

24 Mar 2023, 20:02 24 Mar 2023, 20:02

Message

#64

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Concernant les SSD, qualqu'un a t'il eu des mauvaises surprises après un loment sans les alimenter et si oui au bout de combien de temps ? En ce moment y a un cas qui fait beaucoup de bruit : beaucoup de Wii U laissées un peu trop longtemps au fond d'un tiroir sont désormais inutilisables, leur firmware étant devenu illisible. -------------------- |

|

|

|

25 Mar 2023, 07:24 25 Mar 2023, 07:24

Message

#65

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 443 Inscrit : 3 Feb 2004 Membre no 14 248 |

Salut à toutes et à tous,

Ben moi dans ma tour j'ai 120To de stockage. 15 HDD de 8to chacun. Et montés en RAID0 par paires sauf un. Il m'arrive assez souvent de vouloir copier des fichiers assez volumineux totalisant 200Go. Les SSD sont-ils adaptés à ce petit jeu ? Ben franchement, sur certains, tant que le cache est dispoinible, ça va. Mais quand le cache est rempli, c'est juste la catastrophe : le débit chute à moins de 20mo/s... Au final, le temps gagné sur ces opérations par rapport à un disque à plateaux en RAID0 est éngligeable. Je devrais parler au passé, parce que c'était il y a 3 ou 4 ans. Ce problème est-il enfin réglé sur les disques à puces actuels ? Merci de me tenir informé. Je passerais peut-être à plus de SSD si c'est le cas. |

|

|

|

25 Mar 2023, 11:09 25 Mar 2023, 11:09

Message

#66

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 337 Inscrit : 19 Jun 2020 Membre no 211 922 |

Mais quand le cache est rempli, c'est juste la catastrophe : le débit chute à moins de 20mo/s... Ce problème est-il enfin réglé sur les disques à puces actuels ? C'est le cas avec les SSD grand public (comprendre grosse capacité et petit prix) qui utilisent de la flash très dense, mais lente en écriture, telle que la QLC. Je ne pense pas que cela se "résolve" dans l'avenir, car tant qu'il y aura moyen de réduire le prix sur cette catégorie de produits, tous les moyens seront bons. La solution pour toi est d'acheter des SSD plus haut de gamme ne souffrant pas de cette "optimisation", mais ce sera plus cher Accessoirement ce problème commence aussi à se poser sur les HDD, où les modèles à haute densité utilisent la techno SMR, souffrant des mêmes problèmes que les SSD, et d'ailleurs ayant aussi besoin de Trim pour maintenir leur performance. |

|

|

|

25 Mar 2023, 15:11 25 Mar 2023, 15:11

Message

#67

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

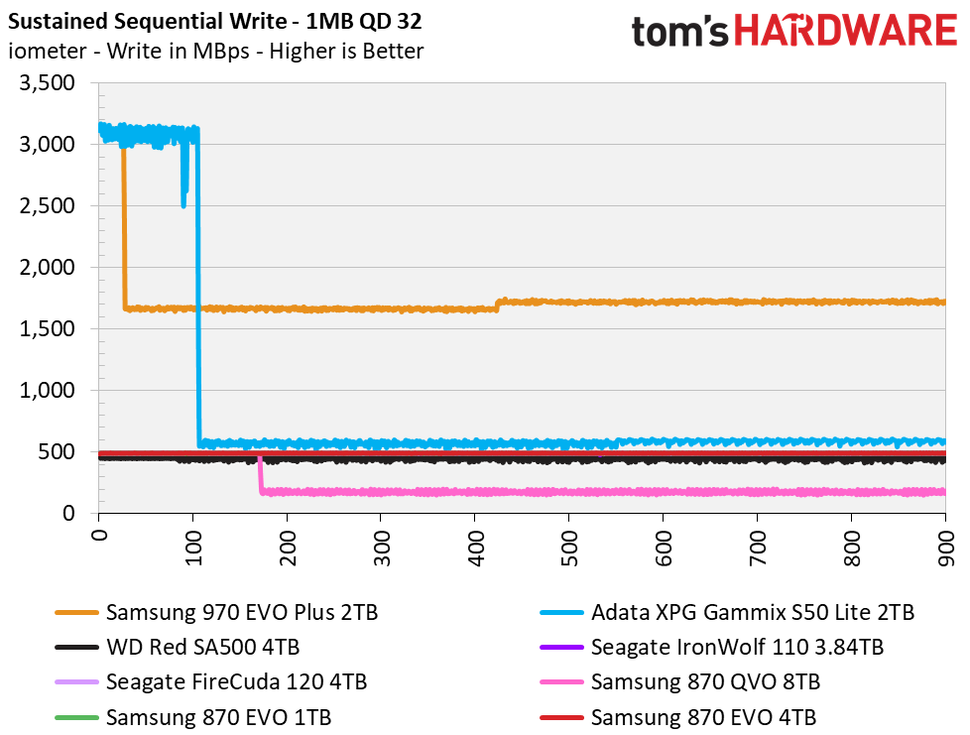

Mais quand le cache est rempli, c'est juste la catastrophe : le débit chute à moins de 20mo/s... Ce problème est-il enfin réglé sur les disques à puces actuels ? C'est le cas avec les SSD grand public (comprendre grosse capacité et petit prix) qui utilisent de la flash très dense, mais lente en écriture, telle que la QLC. Je ne pense pas que cela se "résolve" dans l'avenir, car tant qu'il y aura moyen de réduire le prix sur cette catégorie de produits, tous les moyens seront bons. On est quand même plutôt sur 150 Mo/s (et donc 300 Mo/s en RAID0) plutôt que 20 aujourd'hui une fois le cache rempli, et il y a pas mal de modèles "grand public" (pas les moins cher bien sûr) qui tiennent les 500 Mo/s, voire bien plus (plus de 1.5 Go/s pour le Samsung 970 EVO). Accessoirement ce problème commence aussi à se poser sur les HDD, où les modèles à haute densité utilisent la techno SMR, souffrant des mêmes problèmes que les SSD, et d'ailleurs ayant aussi besoin de Trim pour maintenir leur performance. Non, sur les disques SMR, le problème est pas le même, c'est plutôt l'inverse : sur les SSD QLC ce sont les performances en écriture séquentielle qui chutent, alors que sur les disques durs SMR ce sont les performances en écriture aléatoire qui chutent, parce que le disque doit obligatoirement écrire par blocs de quelques Mo, en relisant au préalable les données existantes s'il ne doit pas modifier tout le bloc. -------------------- |

|

|

|

25 Mar 2023, 22:38 25 Mar 2023, 22:38

Message

#68

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 337 Inscrit : 19 Jun 2020 Membre no 211 922 |

On est quand même plutôt sur 150 Mo/s (et donc 300 Mo/s en RAID0) plutôt que 20 aujourd'hui une fois le cache rempli, et il y a pas mal de modèles "grand public" (pas les moins cher bien sûr) qui tiennent les 500 Mo/s, voir bien plus (plus de 1.5 Go/s pour le Samsung 970 EVO). Perso j'ai vu des SSD récents qui tombent à 80 Mo/s une fois le cache rempli, comme vu aussi ici : https://www.journaldulapin.com/2019/01/31/ssd-trim-cache/ Non, sur les disques SMR, le problème est pas le même, c'est plutôt l'inverse : sur les SSD QLC ce sont les performances en écriture séquentielle qui chutent, alors que sur les disques durs SMR ce sont les performances en écriture aléatoire qui chutent, parce que le disque doit obligatoirement écrire par blocs de quelques Mo, en relisant au préalable les données existantes s'il ne doit pas modifier tout le bloc. Mouais, je ne vois pas trop en quoi une écriture séquentielle pourrait perturber un SSD, tu as une explication ou des références ? Et les HDD SMR ne restent performants en séquentiel qu'à condition d'écrire en fin de zone, ce qu'aucun OS ne sait encore gérer à ma connaissance. |

|

|

|

25 Mar 2023, 23:28 25 Mar 2023, 23:28

Message

#69

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

... Et les HDD SMR ne restent performants en séquentiel qu'à condition d'écrire en fin de zone, ce qu'aucun OS ne sait encore gérer à ma connaissance. Les OS ne gèrent pas cela, sauf les plus primitifs: ce sont les filesystems et leurs drivers qui gèrent cela, et BTRFS semble (par hasard et non par design) bien supporter les disques durs SMR. Évidemment sur des charges avec peu ou pas d'écritures aléatoires (un MySQL ou MariaDB ça va pas le faire Ce message a été modifié par iAPX - 25 Mar 2023, 23:31. |

|

|

|

26 Mar 2023, 21:18 26 Mar 2023, 21:18

Message

#70

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Mouais, je ne vois pas trop en quoi une écriture séquentielle pourrait perturber un SSD, tu as une explication ou des références ? Les SSD QLC ont souvent un mode de fonctionnement particulier, qui consiste à utiliser une partie de la mémoire (plusieurs dizaines de Go) comme de la SLC pour les écritures puis de "migrer" en QLC en tâche de fond. Ceci fait que les performances sont surtout dégradées en écritures séquentielles, parce que pour en arriver à remplir le cache SLC de plusieurs dizaines de Go avant que le contrôleur ait le temps de réorganiser les données, c'est généralement que tu fais du séquentiel, pas de l'aléatoire.Et les HDD SMR ne restent performants en séquentiel qu'à condition d'écrire en fin de zone Les zones ne font que quelques Mo à quelques dizaines de Mo (une piste fait de l'ordre de 1-2 Mo et il y a généralement pas plus de quelques dizaines de pistes dans une zone). Donc quand tu réécris des gros volumes en séquentiel, en pratique tu réécris des zones complètes, et les performances ne s'écroulent pas.Voilà par exemple un test sur un Seagate Archive HDD 8 To (l'un des tous premiers disques SMR à être arrivé sur le marché, qui ne supporte pas le TRIM), qui a déjà pas mal de vécu (et qui a déjà été rempli intégralement) :  CrystalDiskMark_20230326205711.png ( 21.59 Ko )

Nombre de téléchargements : 9

CrystalDiskMark_20230326205711.png ( 21.59 Ko )

Nombre de téléchargements : 9On voit bien qu'en écriture séquentielle, les débits sont similaires à ceux atteints en lecture séquentielle. Il n'y a donc pas d'impact significatif à la baisse sur ce disque (test sur 60 secondes, donc à 160 Mo/s on a normalement largement saturé le cache, et on mesure bien le débit en écriture physique sur le disque). En aléatoire par contre on ne voit pas l'impact, parce que le test est trop court (pas possible de tester sur plus de 60 secondes), le résultat est faussé par le cache. ce qu'aucun OS ne sait encore gérer à ma connaissance. Linux sait faire. C'est le seul OS actuellement à supporter les disques SMR "Host Managed", avec BTRFS et F2FS.Perso j'ai vu des SSD récents qui tombent à 80 Mo/s une fois le cache rempli, comme vu aussi ici : https://www.journaldulapin.com/2019/01/31/ssd-trim-cache/ Le Crucial P1, c'est pas franchement ce qu'on peut qualifier de SSD "récent", c'est un modèle qui approche des 5 ans...Après, je dis pas qu'il n'existe pas aujourd'hui des modèles récents qui ne tombent pas aussi bas sur de longues phases d'écriture. Mais c'est pas franchement la norme. Voir par exemple ce comparatif de Tom's Hardware, où un seul modèle est tombé sous les 500 Mo/s sur un test d'écriture de 15 minutes :  C'est le 870 QVO, qui est l'un des modèles les moins chers du marché... Ce message a été modifié par SartMatt - 26 Mar 2023, 21:37. -------------------- |

|

|

|

26 Mar 2023, 22:24 26 Mar 2023, 22:24

Message

#71

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 992 Inscrit : 18 Jan 2015 Lieu : Montréal, Québec Membre no 193 846 |

Rassurez moi c'est une blague cette histoire de ssd perdant les données si non branché. C'est fou. J’espère aussi… J’ai deux SSD dans des boîtiers USB3 et USB-C externes qui ne sont utilisés qu’une ou deux fois par mois! "Sauf que les HDD qui ne tournent pas pendant longtemps peuvent avoir les graisses qui se figent" Tres étonné aussi : une des techniques de sauvetage d'un DD mécanique en panne consiste à le mettre au congélateur (-30°) 5 à 6 heures, avec ses câbles si possibles, et de tenter un démarrage /récupération quand il est archi-froid. Je n'ai jamais tenté la chose, mais je l'ai lue sur pas mal des sites de sauvetage de données. C'est une légende .... Un secteur HS ne peut être récupérer par le froid et en plus même sous plastique l'électronique s'abime Oui, ce n’est pas très bon avec la décongélation qui fait de la condensation… Mon beau-père a tout tenté pour sauver le DD de ma nièce qui contenait « toutes » ses photos, sans aucune sauvegarde! Je lui mentionné le truc mais j’ai vérifié avant et découvert que ce n’était qu’un mythe… -------------------- Nouveau Hackintosh dédié MAO • Gigabyte Designare i9 9900K 3,6GHz - RX560 - 96 Go DDR4 - OS X 10.14.6/Win 10 - OpenCore 0.8.8 Mod No ACPI

MacMini 2018 i7 8700B 3,2 GHz - eGPU RX5500XT - 64 Go DDR4 - MacOS 13.7.3/MacOS 15.3.1/Windows 11 Ancien Hackintosh dédié MAO • Dell Optiplex 9020 i7 4770 3,4GHz - GT710 - 16 Go DDR3 - OS X 10.14.6 - OpenCore 0.8.8 |

|

|

|

26 Mar 2023, 22:36 26 Mar 2023, 22:36

Message

#72

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

"Sauf que les HDD qui ne tournent pas pendant longtemps peuvent avoir les graisses qui se figent" Tres étonné aussi : une des techniques de sauvetage d'un DD mécanique en panne consiste à le mettre au congélateur (-30°) 5 à 6 heures, avec ses câbles si possibles, et de tenter un démarrage /récupération quand il est archi-froid. Je n'ai jamais tenté la chose, mais je l'ai lue sur pas mal des sites de sauvetage de données. C'est une légende .... Un secteur HS ne peut être récupérer par le froid et en plus même sous plastique l'électronique s'abime Oui, ce n’est pas très bon avec la décongélation qui fait de la condensation… Mon beau-père a tout tenté pour sauver le DD de ma nièce qui contenait « toutes » ses photos, sans aucune sauvegarde! Je lui mentionné le truc mais j’ai vérifié avant et découvert que ce n’était qu’un mythe… Figer le lubrifiant par le froid n'est pas vraiment gagnant |

|

|

|

26 Mar 2023, 23:24 26 Mar 2023, 23:24

Message

#73

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 337 Inscrit : 19 Jun 2020 Membre no 211 922 |

... Merci pour tes (longues) explications, même si je n'en partage pas tous les détails Je ne partage pas ton analyse sur les SSD qui ne souffriraient pas de la saturation du cache SLC en écriture aléatoire, c'est juste que c'est moins souvent mesuré. Pour le HDD SMR, il n'y a pas besoin de Trim si l'on écrase séquentiellement une ou plusieurs zone, c'est implicite et le cache n'est pas mis en oeuvre. Mais si le disque est fragmenté je crains que l'écriture séquentielle ne sature le cache tout comme des écritures aléatoires. BTRFS sais gérer le zoning, ça reste assez expérimental et très peu outillé au niveau de l'OS, mais ne pinaillons pas. Le 870 QVO est un bon exemple de SSD "grand public" s'il en est :-) Bref, certes l'implémentation physique entre les SSD QLC et les HDD SMR apporte forcément des différences de fonctionnement, j'attirais surtout l'attention sur les points communs contre-intuitifs et peu connus. |

|

|

|

26 Mar 2023, 23:34 26 Mar 2023, 23:34

Message

#74

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Rassurez moi c'est une blague cette histoire de ssd perdant les données si non branché. C'est fou. J’espère aussi… J’ai deux SSD dans des boîtiers USB3 et USB-C externes qui ne sont utilisés qu’une ou deux fois par mois! Les mémoire flash, ce sont en quelques sorte de minuscules condensateurs qui stockent des charges électriques. La quantité de charge électrique dans une cellule détermine la valeur des bits de cette cellule. Par exemple, sur une TLC, qui peut stocker 3 bits, donc 8 valeurs différentes, une charge comprise entre 0 et 1/8 du maximum représentera 000, une charge entre 1/8 et 2/8 sera un 001, de 2/8 à 3/8 010, etc... jusqu'à une charge comprise entre 7/8 et 8/8 qui représentera 111. Mais comme tout condensateur ou batterie, la cellule de mémoire flash perd petit à petit ses charges. Ainsi, un 111 va petit à petit devenir un 110, puis un 101, etc... et le contrôleur va alors invalider les données car elles ne correspondent plus aux sommes de contrôle. Mais pas de panique : le temps nécessaire pour que les données se perdent se compte en général plutôt en années qu'en semaines. Les normes prévoient qu'une cellule en fin de vie (donc qui a déjà subit plusieurs centaines de cycles d'effacement) doit conserver les données 1 an à 30°. Une cellule neuve, c'est au moins dix ans. Et en usage grand public, même après plusieurs années, les cellules seront plus proches de neuves que en fin de vie, surtout pour des volumes externes que tu n'utilises qu'une fois de temps en temps. Et puis surtout, un rappel sur ce point n'étant jamais de trop : on ne garde jamais ses données en un seul exemplaire. Toujours au moins 3, et en essayant autant que possible de varier les technologies de stockage (idéalement aussi les lieux) et à minima les marques/modèles des supports de stockage pour limiter le risque de se retrouver avec tous les exemplaires en carafe en même temps. Et bien sûr on ne laisse jamais les sauvegardes dormir indéfiniment, on vérifie de temps en temps qu'elles sont toujours ok (via des fichiers de somme de contrôle par exemple, quand le format de fichier des sauvegarde ne gère pas lui même ce contrôle d'intégrité), car forcément si on attend d'avoir besoin de la sauvegarde pour se rendre compte qu'elle a subit les outrages du temps, c'est trop tard... -------------------- |

|

|

|

27 Mar 2023, 00:42 27 Mar 2023, 00:42

Message

#75

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Je ne partage pas ton analyse sur les SSD qui ne souffriraient pas de la saturation du cache SLC en écriture aléatoire, c'est juste que c'est moins souvent mesuré. Oui, ça peut arriver, c'est juste plus rare et ça sera également plus difficile de saturer le cache, car les écritures aléatoires dans ce cache sont bien plus lentes que les écritures séquentielles, donc il faudra beaucoup plus de temps pour le remplir, tandis qu'à l'inverse les sorties du cache peuvent se faire de façon moins aléatoire, voire quasi séquentielle, si le contrôleur optimise bien, donc se feront presque aussi vite que les écritures séquentielles (potentiellement donc même plus vite que l'écriture aléatoire dans le cache). Mais si le disque est fragmenté je crains que l'écriture séquentielle ne sature le cache tout comme des écritures aléatoires. Oui c'est sûr qu'en SMR avoir un système de fichier fragmenté, ça peut être catastrophique pour les performances. Mais quand je parle d'écriture séquentielle, je pense à "écriture sur une longue série d'adresses consécutives", pas "écriture d'un gros fichier", donc ça implique effectivement un système de fichier pas trop fragmenté (auquel cas, du point de vue du disque, l'écriture de gros fichiers peut effectivement devenir quelque chose ressemblant à de l'aléatoire...).Le 870 QVO est un bon exemple de SSD "grand public" s'il en est :-) Yep, excellent pour du stockage, avec un rapport capacité/prix quasi imbattable (il approche de la barre des 50€/To en version 8 To). Et comme en plus Samsung a fait le 870 EVO en TLC et le QVO en QLC avec le même contrôleur, c'est aussi un excellent exemple "éducatif" pour montrer l'impact de la QLC sur les performances :-) Et dans la gamme NVME, même chose entre les EVO et les PRO pour voir l'impact de la TLC par rapport à la MLC. Manque juste des modèles SLC pour compléter les comparaisons... mais les MLC d'aujourd'hui sont tellement rapides que les SSD SLC ne se justifient plus beaucoup. -------------------- |

|

|

|

27 Mar 2023, 00:49 27 Mar 2023, 00:49

Message

#76

|

|

Macbidouilleur d'Or !      Groupe : Modérateurs Messages : 20 009 Inscrit : 22 Jul 2004 Lieu : Louvain-la-Neuve (Gaule Gelbique) Membre no 21 291 |

Merci SartMatt. Ça faisait longtemps que je ne t'avais lu (je passe peu dans cette section des forums…) mais c'est toujours un plaisir.

A te lire, me vient une idée (sans doute naïve…) pour faire durer des SSD : Puisque, le temps passant, ils deviennent moins « précis » dans les données qu'ils peuvent différencier, on devrait pouvoir les recycler en leur demandant de stocker moins de niveaux distincts par cellule. Par exemple, demander au contrôleur qu'il travaille avec les cellules en SLC ou MLC au lieu de TLC. Ce qu'on perdrait en capacité, on devrait le regagner en fiabilité, non ? -------------------- ¶ MacBook Pro 14’’ 2021, M1 Pro, 16 Go/1 To – macOS 12.6 “Monterey” ¶ MacBook Pro 15’’ mi-2010 Core i5 2,53 GHz, 8 Go/SSD Samsung 860EVO 1 To – Mac OSX 10.6.8 ¶ Power Macintosh G3 beige de bureau, rev.1 @ 233MHz, 288 Mo/4Go – MacOS 9.1 + carte PCI IDE/ATA Tempo 66 Acard 6260 avec HD interne Maxtor 80 Go + graveur interne CDRW/DVD LG GCC-4520B + tablette A4 Wacom UD-0608-A + LaCie ElectronBlueIV 19" + HP ScanJet 6100C ¶ B-Box 3 + HP LaserJet 4000 N

¶ La recherche dans MacBidouille vous paraît obscure ? J'ai rédigé une proposition de FAQ. Le moteur logiciel a un peu changé depuis mais ça peut aider quand même. … Les corsaires mettent en berne… |

|

|

|

27 Mar 2023, 01:37 27 Mar 2023, 01:37

Message

#77

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

C'est pas con, surtout qu'un stockage Flash "SSD" QLC ou MLC sait souvent utiliser un cache SLC, donc totalement fonctionner dans ce mode.

Le problème d'ailleurs pour l'usure, c'est justement le cache SLC qui a un impact énorme en amplification d'écriture, donc en usure. Dans le cas d'un stockage à 8 niveaux (3 bits), comme dans l'exemple que citait @SartMatt, le cache occupe 3X plus d'espace puisque SLC (1 seul bit au lieu de 3), puis la réécriture des données ajoute une quatrième usure. Ça va plus vite, mais ça use 4 fois plus vite le stockage Flash "SSD". Idéalement, c'est le cache SLC en écriture qui devrait être abandonné pour augmenter la durée de vie d'un stockage Flash "SSD", au détriment de la vitesse d'écriture... Ce message a été modifié par iAPX - 27 Mar 2023, 01:56. |

|

|

|

27 Mar 2023, 01:58 27 Mar 2023, 01:58

Message

#78

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 992 Inscrit : 18 Jan 2015 Lieu : Montréal, Québec Membre no 193 846 |

Et puis surtout, un rappel sur ce point n'étant jamais de trop : on ne garde jamais ses données en un seul exemplaire. Toujours au moins 3, et en essayant autant que possible de varier les technologies de stockage (idéalement aussi les lieux) et à minima les marques/modèles des supports de stockage pour limiter le risque de se retrouver avec tous les exemplaires en carafe en même temps. Et bien sûr on ne laisse jamais les sauvegardes dormir indéfiniment, on vérifie de temps en temps qu'elles sont toujours ok (via des fichiers de somme de contrôle par exemple, quand le format de fichier des sauvegarde ne gère pas lui même ce contrôle d'intégrité), car forcément si on attend d'avoir besoin de la sauvegarde pour se rendre compte qu'elle a subit les outrages du temps, c'est trop tard... Fiou! Je suis un peu plus rassuré. Ce sont des données que je transfère d'un ordi à un autre et j'ai plusieurs copies. -------------------- Nouveau Hackintosh dédié MAO • Gigabyte Designare i9 9900K 3,6GHz - RX560 - 96 Go DDR4 - OS X 10.14.6/Win 10 - OpenCore 0.8.8 Mod No ACPI

MacMini 2018 i7 8700B 3,2 GHz - eGPU RX5500XT - 64 Go DDR4 - MacOS 13.7.3/MacOS 15.3.1/Windows 11 Ancien Hackintosh dédié MAO • Dell Optiplex 9020 i7 4770 3,4GHz - GT710 - 16 Go DDR3 - OS X 10.14.6 - OpenCore 0.8.8 |

|

|

|

27 Mar 2023, 10:21 27 Mar 2023, 10:21

Message

#79

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 184 Inscrit : 22 Oct 2001 Lieu : Paris Membre no 1 101 |

Puisque le sujet dérive sur la conservation des données, j'ai récemment décidé de ressortir toutes mes disquettes Atari ST du début des années 90. A l'époque de ma bascule sur Mac, je n'avais pas tout transféré (ou une partie sur le SyQuest dont je parle au début de nos échanges

Sans conservation particulière, j'ai pu relire toutes les disquettes, une trentaine. Seules 3 ont des problèmes sur certains secteurs. Pour les relire, j'ai du par contre reprendre un vieux serveur du boulot qui avait encore un lecteur de disquette, y installer une vieille version de Windows, des drivers spécifiques, et un soft spécifique (https://github.com/ChrisBertrandDotNet/ST-Recover). Ça fait tout drôle de revenir sur Atari, de retrouver la programmation de l'époque. Et l'interface a moins vieilli que je n'imaginais (mais là on dérive du sujet). Ce message a été modifié par smy - 27 Mar 2023, 10:23. -------------------- smy.fr • smyapps.com • @SebMougey • @[email protected]

Mes applications iPhone : Détecteur de loups-garous, fantômes, vampires, et autres créatures étranges |

|

|

|

27 Mar 2023, 12:45 27 Mar 2023, 12:45

Message

#80

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

Ah la récupération de données sur des disquettes, surtout Atari ST!

On a eu une fois l'occasion de s'y essayer, au milieu des années 90, pour Laurent Chalumeau un auteur des guignols (et de plein d'autres choses passionnantes), et on a tout essayé, y-compris des lecteurs PC de l'époque, comprenant l'importance des textes qui y étaient stockés, mais malheureusement rien n'y a fait, son travail éminemment qualitatif était perdu! Relisez et appliquez le conseil de @SartMatt: "on ne garde jamais ses données en un seul exemplaire. Toujours au moins 3, et en essayant autant que possible de varier les technologies de stockage (idéalement aussi les lieux)..." |

|

|

|

28 Mar 2023, 11:56 28 Mar 2023, 11:56

Message

#81

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 530 Inscrit : 18 Jun 2014 Membre no 190 920 |

Ce n'est pas une blague, c'est une caractéristique connue depuis toujours des mémoires flash. Merci de tes explications. Maintenant, la question que je me pose est la suivante : Si on stocke longtemps (plusieurs mois, voire années) des mémoires flash (cartes SD, clés USB, disques externes SSD), et en admettant qu'au moment où on les réalimente, les données sont valides… Est-ce que le simple fait de brancher à nouveau sur une source d'alimentation électrique ces appareils suffit à les régénérer d'un seul coup ? Pour repartir sans danger sur un nouveau cycle de plusieurs mois sans alimentation ? -------------------- iMac 27" late 2013 - Mavericks, iMac 27" mid 2010 - Mavericks, iPad mini 1 - iOS 8. Et diverses vieilleries.

Mon site web : ANTIOPA NATURE |

|

|

|

28 Mar 2023, 12:19 28 Mar 2023, 12:19

Message

#82

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

Ce n'est pas une blague, c'est une caractéristique connue depuis toujours des mémoires flash. Merci de tes explications. Maintenant, la question que je me pose est la suivante : Si on stocke longtemps (plusieurs mois, voire années) des mémoires flash (cartes SD, clés USB, disques externes SSD), et en admettant qu'au moment où on les réalimente, les données sont valides… Est-ce que le simple fait de brancher à nouveau sur une source d'alimentation électrique ces appareils suffit à les régénérer d'un seul coup ? Pour repartir sans danger sur un nouveau cycle de plusieurs mois sans alimentation ? Il y a deux points: le comportement dans ce cas n'est ni documenté, ni testable lors de la sortie de ces stockages Flash "SSD", et très probablement variable d'un microcontrôleur à l'autre, voire d'une version de firmware à l'autre! La meilleure réponse est "on ne sait pas", mais on espère qu'avec une journée alimenté et actif (donc communicant avec un host) la régénération soit faite. Un facteur est que le temps de régénération est lié à la quantité de données stockées, la vitesse d'écriture en continu et la charge de travail demandée à ce moment au stockage. À même niveau de performance et sans travail demandé, un stockage Flash "SSD" prendra 10 fois plus de temps pour régénérer 1 To que 100 Go. Il faut noter que si un disque dur branché et actif (tournant) s'use un peu même sans accès, un stockage Flash "SSD" branché et actif ne s'use pas hors accès en écritures et sa propre régénération salvatrice ou sa réorganisation (libération de pages et effacement de celles-ci pour permettre de futures écritures). Donc sans laisser un stockage Flash "SSD" tout le temps branché et actif (communiquant avec le host), j'irais sur une journée par mois, ou une grosse nuit par mois, voire une fds si il stocke beaucoup de données. Mais là c'est au doigt mouillé! PS: il est intéressant de noter que l'Apple ][ a été un des premiers micro-ordinateurs à recevoir un type de stockage "solide" en 1982, via la mémoire à bulle de Intel (128Ko persistants), techniquement un "SSD". Ce message a été modifié par iAPX - 28 Mar 2023, 14:02. |

|

|

|

28 Mar 2023, 15:35 28 Mar 2023, 15:35

Message

#83

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Est-ce que le simple fait de brancher à nouveau sur une source d'alimentation électrique ces appareils suffit à les régénérer d'un seul coup ? Comme le dit iAPX, c'est rarement documenté, donc on ne peut que faire des suppositions hélas...Ce qui est à peu près sûr par contre, c'est que autant un effacement physique peut se faire quasi instantanément, en envoyant la commande d'effacement à toute la mémoire en même temps, autant je doute que ça soit le cas pour le rafraichissement, à ma connaissance le rafraichissement n'est pas géré en interne par les mémoires flash elle même, s'il y a un rafraichissement, il est géré en externe par le contrôleur. Mais même ça, c'est pas gagné. On peut trouver des infos venant de quelqu'un de chez Kingston qui préconise carrément de recopier les données pour les rafraichir... Après, en pratique, sur un SSD "actif", ça va en fait bien se rafraichir "tout seul" à cause du garbage collector et du wear levelling : les cellules dans lesquelles les données qui ne sont jamais modifiées vont petit à petit avoir un niveau d'usure sensiblement inférieur aux autres cellules, et le contrôleur va donc finir par déplacer leurs données sur des cellules plus usées pour équilibrer l'usure... Mais ça ne garanti toujours pas... On peut aussi supposer que lors d'une lecture, les cellules dont la charge est proche de la limite inférieur d'un niveau de charge sont marquées pour être rafraichies. Et donc une relecture complète de temps en temps pourrait déclencher un rafraichissement de ce qui en a besoin. Mais là encore, ce n'est que supposition... Clairement, le seul moyen d'être sûr, c'est la préconisation Kingston : on réécrit tout une fois de temps en temps. D'un point de vue usure, ce n'est de toute façon pas un problème : les données pour laquelle la question de la réécriture se pose sont de toute façon des données qui ne bougent pas, donc qui engendrent peu d'usure, et donc refaire une passe de temps en temps n'est vraiment pas dramatique (pour un SSD qui support 300 cycles, qui est plutôt la limite basse aujourd'hui, faire une réécriture tous les ans, ça va lui bouffer 1% de sa durée de vie tous les 3 ans...). -------------------- |

|

|

|

28 Mar 2023, 15:45 28 Mar 2023, 15:45

Message

#84

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 526 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

Est-ce que le simple fait de brancher à nouveau sur une source d'alimentation électrique ces appareils suffit à les régénérer d'un seul coup ? Comme le dit iAPX, c'est rarement documenté, donc on ne peut que faire des suppositions hélas...Ce qui est à peu près sûr par contre, c'est que autant un effacement physique peut se faire quasi instantanément, en envoyant la commande d'effacement à toute la mémoire en même temps, autant je doute que ça soit le cas pour le rafraichissement, à ma connaissance le rafraichissement n'est pas géré en interne par les mémoires flash elle même, s'il y a un rafraichissement, il est géré en externe par le contrôleur. Mais même ça, c'est pas gagné. On peut trouver des infos venant de quelqu'un de chez Kingston qui préconise carrément de recopier les données pour les rafraichir... Après, en pratique, sur un SSD "actif", ça va en fait bien se rafraichir "tout seul" à cause du garbage collector et du wear levelling : les cellules dans lesquelles les données qui ne sont jamais modifiées vont petit à petit avoir un niveau d'usure sensiblement inférieur aux autres cellules, et le contrôleur va donc finir par déplacer leurs données sur des cellules plus usées pour équilibrer l'usure... Mais ça ne garanti toujours pas... On peut aussi supposer que lors d'une lecture, les cellules dont la charge est proche de la limite inférieur d'un niveau de charge sont marquées pour être rafraichies. Et donc une relecture complète de temps en temps pourrait déclencher un rafraichissement de ce qui en a besoin. Mais là encore, ce n'est que supposition... Clairement, le seul moyen d'être sûr, c'est la préconisation Kingston : on réécrit tout une fois de temps en temps. D'un point de vue usure, ce n'est de toute façon pas un problème : les données pour laquelle la question de la réécriture se pose sont de toute façon des données qui ne bougent pas, donc qui engendrent peu d'usure, et donc refaire une passe de temps en temps n'est vraiment pas dramatique (pour un SSD qui support 300 cycles, qui est plutôt la limite basse aujourd'hui, faire une réécriture tous les ans, ça va lui bouffer 1% de sa durée de vie tous les 3 ans...). Tu es certain qu'en APFS les données dupliquées le soient réellement ? -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

28 Mar 2023, 15:54 28 Mar 2023, 15:54

Message

#85

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Tu es certain qu'en APFS les données dupliquées le soient réellement ? Oui, avec la déduplication y a des chances qu'il ne recopie pas. Mais quand je parle de recopie, je pense à l'échelle du disque complet plus qu'à l'échelle du fichier, donc copie sur un autre puis recopie dans l'autre sens (perso je fait ça en hardware avec une dock deux baies SATA qui gère la recopie de façon autonome). -------------------- |

|

|

|

28 Mar 2023, 16:07 28 Mar 2023, 16:07

Message

#86

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

Tu es certain qu'en APFS les données dupliquées le soient réellement ? Oui, avec la déduplication y a des chances qu'il ne recopie pas. Mais quand je parle de recopie, je pense à l'échelle du disque complet plus qu'à l'échelle du fichier, donc copie sur un autre puis recopie dans l'autre sens (perso je fait ça en hardware avec une dock deux baies SATA qui gère la recopie de façon autonome). En même temps (je fais mon Manu!), mais ça n'est pas documenté, il y a de fortes chances que les "bons" firmware s'occupent de rafraîchir de manière transparente des données lues qui commencent à être limite, là aussi c'est une pure spéculation. De toute façon, sauf à charger le stockage sous forme de device de type block et de lire son entièreté en ignorant les erreurs, au travers d'un driver de filesystem il n'y a aucun moyen de s'en assurer. Ça complique méchamment, et la réécriture complète après réinitialisation du stockage Flash "SSD", recréation d'un file system et copie complète est probablement la seule manière de s'assurer que les données sont "fraîches" et lisibles même si stocké quelques mois... |

|

|

|

28 Mar 2023, 16:21 28 Mar 2023, 16:21

Message

#87

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 140 Inscrit : 16 Feb 2005 Lieu : 94 Membre no 33 210 |

En même temps (je fais mon Manu!), mais ça n'est pas documenté, il y a de fortes chances que les "bons" firmware s'occupent de rafraîchir de manière transparente des données lues qui commencent à être limite, là aussi c'est une pure spéculation. Les firmware des SSD s'occupent de rafraichir les charges dans les pages de flash... si ils sont alimentés ! Un SSD stocké et non alimenté ne peut pas faire cela et c'est tout le problème pour le stockage à long terme. Ce problème de charge est variable en fonction du type de flash... SLC, MLC, TLC, QLC... c'est à dire 1 à 4 bits par cellule chargée. La SLC restera la plus stable dans le temps, mais elle est désormais rarisimme et très chère. J'ai encore des SSD en MCL qui sont increvables (petite capacité bien sûr et ils coutaient à l'époque un bras). Un filesystem moderne peut aussi s'assurer régulièrement que les données sont bien correctes en faisant un "scrub", c'est à dire une lecture complète avec contrôle de ses propres checksums. C'est ce que fait ZFS à qui je confie mes données depuis plusieurs années. Si une lecture est incorrecte, la redondance (indispensable) est utilisée pour regénérer une copie suffisante. Au pire on a la liste des fichiers impactés, qu'on peut reprendre d'une sauvegarde. Sur un HDD, si des secteurs sont illisibles, cela provoquera une réallocation au moment où l'on va ré-écrire dessus (et uniquement à ce moment là). Ce message a été modifié par cquest - 28 Mar 2023, 16:22. -------------------- MacBook Pro M1 14" 2021, MacPro 2009 4x2.93, MacBook 2010 Pro Unibody 15"... et plus d'une trentaine de Mac depuis mon Mac 512 ;-)

mais aussi... Apple IIe, IIe Platinum, IIc, IIgs, IIe dans Macintosh LC 475, Newton Mes serveurs Minitel restaurés: COMPUTEL 01 8421 8116 (Apple II), et JCA 01 8421 8115 (Quadra 650) |

|

|

|

28 Mar 2023, 23:54 28 Mar 2023, 23:54

Message

#88

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 530 Inscrit : 18 Jun 2014 Membre no 190 920 |

Ouais, bon. Merci ! C'est super inquiétant tout ça.

Donc pour résumer : on oublie les SSD dans des disques externes pour faire des sauvegardes de longue durée. Je parle même pas d'archivage. Ça m'arrive de ne pas les brancher pendant 2 ans. J'ai aussi un pote qui a une 50aine de cartes SD : il se disait que mieux valait en racheter une neuve à chaque fois qu'elles étaient pleines. Hi hi hi... Et puis ça m'embête un peu : je comptais mettre un iMac 2010 avec 3 SSD en interne dans ma résidence secondaire (je n'y vais qu'un mois par an). Ça peut le faire... 11 mois. Faudra que ça tienne. Ou pas... On verra. En attendant je crois que je vais bichonner mes HDD en boitier USB3. -------------------- iMac 27" late 2013 - Mavericks, iMac 27" mid 2010 - Mavericks, iPad mini 1 - iOS 8. Et diverses vieilleries.

Mon site web : ANTIOPA NATURE |

|

|

|

29 Mar 2023, 15:21 29 Mar 2023, 15:21

Message

#89

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 1 854 Inscrit : 11 Sep 2002 Lieu : Pas loin de Grenoble (Là bas, sous la Montagne) Membre no 3 458 |

Ces news m'ayant fait un peu peur, j'ai exhumé d'un carton du grenier un assistant personnel HP pas touché ni rechargé depuis plus de 10 ans (completement has been, ne me demandez pas pourquoi je le garde... Un musée ?).

Il contient une carte SD de 4 go, avec des photos (depuis longtemps récupérées). L'assistant n'a plus de batterie depuis le rangement, elle était démontée. Et la carte SD est parfaitement fonctionnelle ! Pourtant une "noname" à 4 sous, pas franchement le haut de gamme. Ça (me) rassure un peu. -------------------- MacBook Pro 15.4/Core i7 2,6 Ghz/16 Go sous 10.14.6, (UN Hackintosh) i7 4790K 4,0 Ghz/32 Go RAM CM Gigabyte Z87X-UD5H CG NVIDIA GeForce GTX 770, avec 10.14.6 Clover "Made in Macbidouille". Un Mac Studio M4 en (difficile) rodage. Et un PC Win 11 + quelques antiquités (Mac Mini 2012, G5 biprocesseur 2005, G4 Graphite)

|

|

|

|

29 Mar 2023, 15:55 29 Mar 2023, 15:55

Message

#90

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 019 Inscrit : 23 Nov 2002 Membre no 4 808 |

donc, si j'ai bien compris, aucun support de sauvegarde ou d'archivage n'est fiable.

Pour ma part, je tendrais a penser que á part son coût, je n'ai strictement rien à foutre de la nature de ce support de sauvegarde ou d'archivage ; à l'unique condition d'en avoir plusieurs sur différents support et surtout de les controler régulièrement. A ce que j'ai lu un contrôle annuel devrais suffire. Reste la question d'importance comment fait-on pour vérifier leur intégrité? Ce message a été modifié par ades - 30 Mar 2023, 09:02. -------------------- |

|

|

|

|

6 utilisateur(s) sur ce sujet (6 invité(s) et 0 utilisateur(s) anonyme(s))

0 membre(s) :

| Nous sommes le : 30th July 2025 - 13:02 |