Bienvenue invité ( Connexion | Inscription )

|

14 Mar 2015, 07:16 14 Mar 2015, 07:16

Message

#1

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 336 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

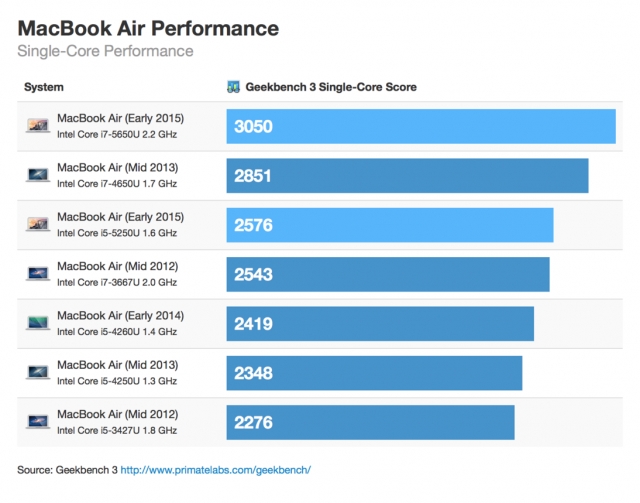

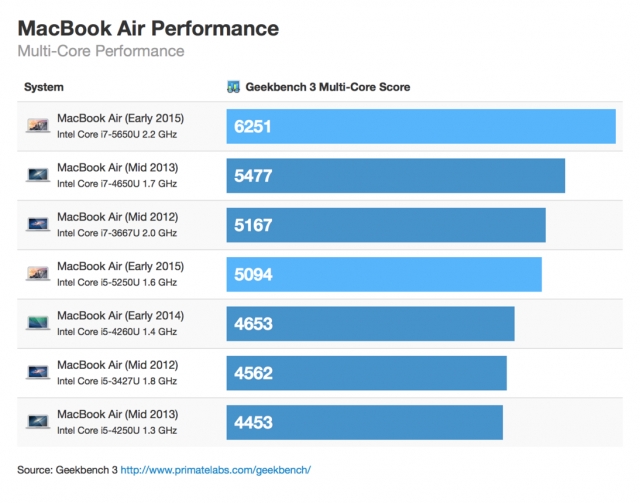

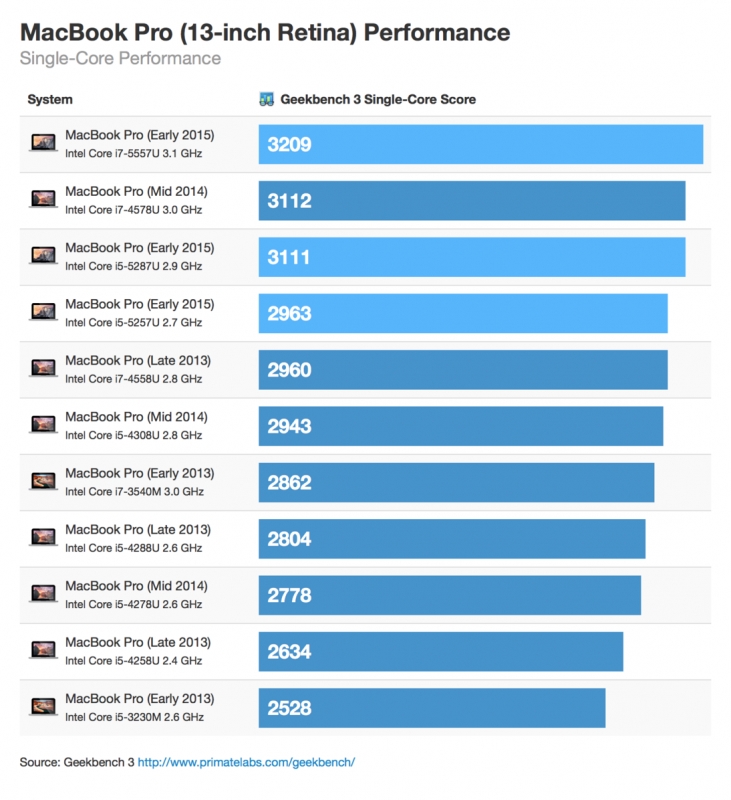

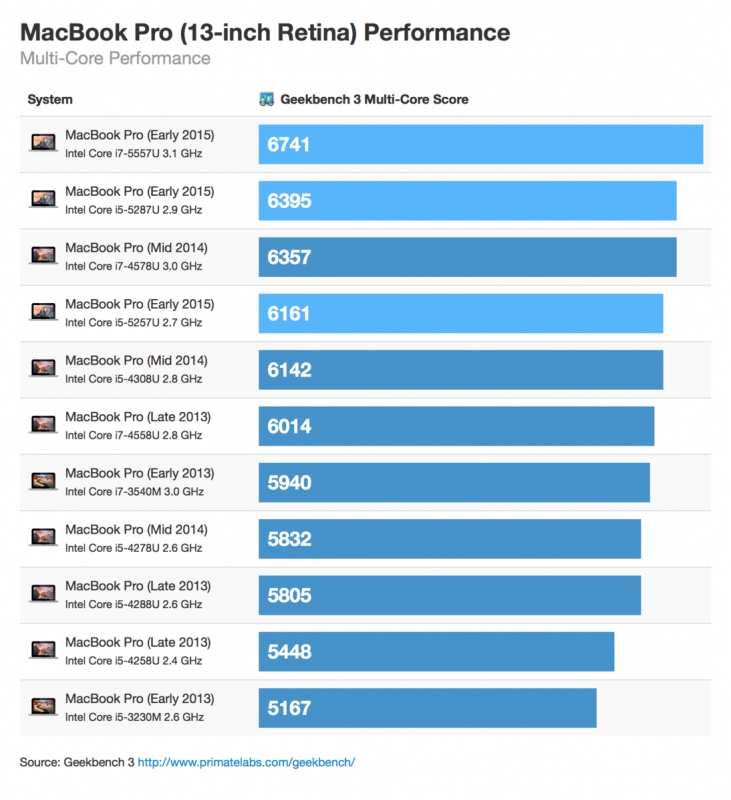

Primate Labs, éditeur de GeekBench, a réalisé une compilation des résultats obtenus par les nouveaux MacBook Air et MacBook Pro.

Si les performances du Core i5 sont en légère hausse, sur le MacBook Air environ 7%, celles du Core i7 sont en réelle augmentation, 14% par rapport au modèle précédent. Si vous en avez les moyens ce dernier est certainement le meilleur compromis et le meilleur rapport puissance-prix.   Au niveau du MacBook Pro les gains de performances apportés par la nouvelle version sont plus faibles, et ce seront certainement le nouveau trackpad haptique et l'autonomie en hausse qui seront les meilleurs arguments pour inciter à adopter cette gamme. Lien vers le billet original -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

14 Mar 2015, 09:57 14 Mar 2015, 09:57

Message

#2

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 305 Inscrit : 22 Aug 2001 Lieu : Paris Membre no 668 |

Ca reste des sauts de puces (hahaha) depuis un long moment maintenant, au niveau CPU brut.

Mon MBA2012 - core i7 - fait un peu moins de 3k/6k sur Geekbench (tiens ça voudrait dire qu'il était un poil meilleur que le 2013? peut être le CPU est un peu plus élevé.) ici on fait un peu plus… à la louche 10% de perf en 3 ans. Le MBP 13 Retina 2015, idem, en CPU il fait un bon 15% de plus qu'un MacBook Air d'il y a 3 ans. Ce n'est pas époustouflant. Après, oui, ce n'est pas toujours représentatif de l'expérience ressentie, et puis le GPU, le SSD PCI-Express, l'autonomie... heureusement, les machines ont globalement progressé. Autant entre 2010 et 2012, on a eu des vrais gains de CPU sur les ultra portables, autant depuis… c'est bien calme. Ce message a été modifié par GregWar - 14 Mar 2015, 09:58. -------------------- MBP13 Early 2015 - Core i7.

|

|

|

|

14 Mar 2015, 10:43 14 Mar 2015, 10:43

Message

#3

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 950 Inscrit : 30 Jul 2008 Lieu : Rennes Membre no 118 804 |

Pourquoi n'y a-t-il pas sur les graphes le MBA 2014 core i7? Est-ce une simple absence ou c'est qu'il est moins bon que ceux présentés ?

-------------------- Bicou | Gadgets: MacBook Air (2014) 256GB/8GB/i7 — Nexus 6P — Nexus 7 (2012) — EOS 70D — Raspi rev B

|

|

|

|

14 Mar 2015, 11:08 14 Mar 2015, 11:08

Message

#4

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 323 Inscrit : 12 Aug 2007 Membre no 92 465 |

Par contre les MBP 15" n'ont eu aucune mise à jour, si ? Je me rend compte que le mien, qui a 3 ans, est presque aussi performant. C'est Intel qui ne sort plus rien d'intéressant ces temps-ci ou Apple qui n'intègre pas les nouveaux CPU ?

-------------------- Comprendre l'audio sur Mac

|

|

|

|

14 Mar 2015, 11:44 14 Mar 2015, 11:44

Message

#5

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 343 Inscrit : 16 Nov 2008 Membre no 125 710 |

|

|

|

|

14 Mar 2015, 13:36 14 Mar 2015, 13:36

Message

#6

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Ca reste des sauts de puces (hahaha) depuis un long moment maintenant, au niveau CPU brut. Mon MBA2012 - core i7 - fait un peu moins de 3k/6k sur Geekbench (tiens ça voudrait dire qu'il était un poil meilleur que le 2013? peut être le CPU est un peu plus élevé.) ici on fait un peu plus… à la louche 10% de perf en 3 ans. Le MBP 13 Retina 2015, idem, en CPU il fait un bon 15% de plus qu'un MacBook Air d'il y a 3 ans. Ce n'est pas époustouflant. Après, oui, ce n'est pas toujours représentatif de l'expérience ressentie, et puis le GPU, le SSD PCI-Express, l'autonomie... heureusement, les machines ont globalement progressé. Autant entre 2010 et 2012, on a eu des vrais gains de CPU sur les ultra portables, autant depuis… c'est bien calme. Certes la progression est tres faible, mais elle correspond a ce qui ete attendu de la presence d'un CPU ayant une frequence superieure. Au moins on va pas cracher sur ces quelques megahertz de plus, c'est toujours mieux que les régressions qu'on a eu avec les MacMini et iMac d'entree de gamme. On note aussi que l'unite graphique semble etre sensiblement plus performante sur le Macbook Pro 13". Certes ce n'est pas un GPU distinct, mais au moins ca devient intéressant. Et puis il y a surtout le passage en Thunderbolt 2 - bon ok ca va pas durer longtemps, le thunderbolt 3 arrive cet automne avec Skylake... Et la on va pas se plaindre non plus d'avoir des ports a foisons De toute facon Apple ne peut pas malgre ses competences faire progresser la puissance de calcul plus que le processeur d'Intel ne le permet. La question qui reste c'est maintenant de savoir si les générations précédentes de processeurs a la même fréquence auraient données des résultats similaires, moins bons, ou meilleurs? Et la reponse n'est pas évidente. Maintenant il ne reste plus qu'a esperer que les mise a jours de l'automne en version Skylake auront une meilleure performance a frequence egale. Reste qu'entre l'augmentation de prix et le peu apporté par cette generation, il est, comme le disait Lionel il y a quelques jours, tres intéressant de prendre une machine sur le refurb. Allez cet automne Apple nous sort des MBA 12" et 15" Retina, avec 2 Thunderbolt 3, 2 USB C, une carte SD, et un port MagSafe, en 8Go/512Go en base, et au meme prix Ce message a été modifié par r@net54 - 14 Mar 2015, 13:50. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

14 Mar 2015, 13:37 14 Mar 2015, 13:37

Message

#7

|

|

|

Nouveau Membre Groupe : Membres Messages : 3 Inscrit : 14 Mar 2015 Membre no 194 571 |

Bonjour, j'aimerais comprendre si quelqu'un peut éclairer ma lanterne. J'ai actuellement un macbook air 2013 i7 (et 8 go de ram, que je branche sur un écran externe). On m'a toujours dis que le macbook air n'était pas fait pour travailler assez lourdement (je suis dans le webdesign, je fais pas mal de graphisme, un peu de montage video etc..). Je commence à sentir les limites de la bête et je comptais me tourner vers un macbook pro retina car pareil tout le monde me dit qu'il faut un macbook pro pour travailler dans de bonnes conditions.

Mais je ne comprends pas car au niveau des résultats obtenu sur ce genre de test comme geekbench et autre, les différences entre macbook air et macbook pro sont tout de meme minimes j'ai l'impression. Mais par contre j'imagine que le turbo doit se déclencher moins souvent sur un macbook pro vu la fréquence processeur, mais je ne vois pas en quoi je gagnerais du confort de travail avec un macbook pro retina. |

|

|

|

14 Mar 2015, 14:04 14 Mar 2015, 14:04

Message

#8

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 129 Inscrit : 6 Jul 2013 Membre no 185 566 |

@bicougnot :

Lors de la maj des MacBook Air de 2014, seul les processeurs i5 ont été mis à jour, ce qui fait que le MacBook Air i7 de 2014 est exactement le même que le i7 de 2013, les procs i7 n'ayant pas changé ni gagné en fréquence, à la différence des i5. C'est un détail qui avait été mentionné sur les sites traitants de l'actu apple, c'est passé assez inaperçu mais il vaut mieux le savoir. @wiish : Beaucoup de gens pensent à tord que le MBPR enterre le MBA, or comme tu peux le voir les différences niveau processeur ne sont pas si criantes. La vraie différence dans ton domaine se situera plus sur le chipset graphique un peu plus puissant sur le MBPR, mais il a aussi à gérer un ecran retina, donc consomme plus de ressource. Les seuls vrais avantages des MBPR sont son ecran retira, et une possibilité de configuration plus musclée en ssd et en ram à l'achat. Après c'est une gueguerre entre les possesseurs de MBPR et MBA, qui tu vois, eux ont besoin d'une vraie machine puissante, parce que tu comprends c'est des professionnels et ne veulent pas faire mumuse avec leur machine mais travailler avec. Comme tu peux le voir, ils ont surtout payé 30 à 50% plus cher qu'un MBA pour moins de 10% de puissance en plus, et un ecran retina (qui est exceptionnel, ce point là je l'accorde sans broncher!Ca fait la différence et justifie un certain prix supplémentaire). Après si on parle des configs avec GPU dédié les prix s'envolent et n'ont donc plus rien a voir avec le MBA. Bref le MBA est selon moi une machine exceptionnelle et très polyvalente, n'en déplaise à certains pour qui le mot "PRO" sur une machine fait toute la différence. Pour en revenir à ton problème de performances, essayes d'ouvrir moins de processus en même temps quand tu travailles sur un gros projet(Safari spotted ^^), après sur les plus petits projets conserve tes habitudes, mais n'oublies pas que les ressources d'une machine ne sont jamais illimité, quand bien même elle est dite "Pro". Cordialement. |

|

|

|

14 Mar 2015, 14:12 14 Mar 2015, 14:12

Message

#9

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 139 Inscrit : 17 Sep 2010 Membre no 159 100 |

A l'utilisation on ne sentira aucunement ce gain de performances, par contre on en bavera au quotidien en raison de l'absence du port USB3 pourtant indispensable en complément de l'USB-C.

Que faudra-t-il pour faire réagir le consommateur ? Un boycott de ce genre de produit serait, à terme, salutaire pour tout le monde ! |

|

|

|

14 Mar 2015, 14:45 14 Mar 2015, 14:45

Message

#10

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Bonjour, j'aimerais comprendre si quelqu'un peut éclairer ma lanterne. J'ai actuellement un macbook air 2013 i7 (et 8 go de ram, que je branche sur un écran externe). On m'a toujours dis que le macbook air n'était pas fait pour travailler assez lourdement (je suis dans le webdesign, je fais pas mal de graphisme, un peu de montage video etc..). Je commence à sentir les limites de la bête et je comptais me tourner vers un macbook pro retina car pareil tout le monde me dit qu'il faut un macbook pro pour travailler dans de bonnes conditions. Mais je ne comprends pas car au niveau des résultats obtenu sur ce genre de test comme geekbench et autre, les différences entre macbook air et macbook pro sont tout de meme minimes j'ai l'impression. Mais par contre j'imagine que le turbo doit se déclencher moins souvent sur un macbook pro vu la fréquence processeur, mais je ne vois pas en quoi je gagnerais du confort de travail avec un macbook pro retina. Difference entre un MBA et un MacBoo Pro: le processeur est un 4 core qui tient une frequence plus elevee plus longtemps de maniere plus stable et surtout il y a un vrai GPU dedans - bon évidement il faut passer d'un MBA Core i5 a un MBPro 15" Core i5/i7, sinon effectivement pas d'interet, a part les ports en plus, de passer a un MBPro 13". La notion de machine pro/ pas po: c'est du marketing! Ce qui va faire qu'une machine est pro, c'est l'utilisation que tu en fais et ton besoin d'avoir un contrat de maintenance: bref ca a rien a voir avec la machine elle meme. Sinon des machines dites pro dans le secteurs entreprise, ce sont des machines certifiees pour des soft particuliers ou de conditions d'exploitaiton specifiques: y a rien de tout ca chez Apple. Surtout ce qu'il faut comprendre c'est que les logiciels de bench permettent de comparer des composants entre eux et sur des générations successives voires les mêmes: en aucun cas un bench ne représente la realite d'utilisation. On sait par exemple que certains modes des processeurs sont optimises pour des bench specifiques histoire de faire monter artificiellement les performances (genre maxi turbo boost pendant un temps ridicule qui font passer un petit processeur de portable pour un gros machin de station de travail) Un exemple de bench pertinent pour la puissance brute de calcul mais qui veut rien dire en utilisation réelle ( a part pour ceux qui font du calcul intensif): un petit soft qui calcul PI! Ce qu'il montre c'est que la progression de puissance monocore des x86 s'est arretee il y a environ 5 ans. Ca veut pas dire que les x86 actuels ne sont pas plus performants que ceux d'il y a 5 ans car Intel a compensé la stagnation du core en puissance de calcul brute par un ensemble de coprocesseurs qui déchargent le Core de plus en plus de taches et les font bien mieux et bien plus vite: ex le GPU, l'unite qui s'occupe de la cryptographie, l'unite vectorielle (architecture SIMD opposée a l'architecture des Core), les divers DSP, la gestion de l'alimentation,... Bref aujourd'hui un CPU c'est un SoC (un ordinateur sur une puce) et les Core sont justes des unites parmi les autres, et ce sont celles qui progressent le moins. Apres, tout dépend de ton utilisation. Si tu utilises photoshop avec des filtres qui sont optimises pour les GPU NVidia, ben t'as intérêt a opter pour un MacBook Pro avec un GPU Nvidia, tu vas gagner du temps. Si tu utilises des fonctions basiques de photoshop pas en haute definition, ou que tu fait de la mise en page, de la redaction,... un MBA suffit largement mais avec 8go de RAM. Faut aussi comprendre que t'as plus interet a avoir beaucoup de RAM et un gros SSD plutot qu'un CPU de derniere generation avec 16 core qui vont passer leur temps a rien faire... Et en fait c'est a toi de tester une machine par rapport a ton utilisation et tes besoins. Bref, il peut etre bien plus intéressant de prendre une machine de génération précédente (en refurb) avec un bon GPU, beaucoup de RAM un un gros SSD, vu la stagnation des CPU actuels... Ce message a été modifié par r@net54 - 15 Mar 2015, 12:52. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

14 Mar 2015, 14:57 14 Mar 2015, 14:57

Message

#11

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 129 Inscrit : 6 Jul 2013 Membre no 185 566 |

@r@net:

Merci je partage entièrement ton point de vue sur les bench, la ram et le ssd plutôt que la fréquence processeur. Tu as également raison de préciser qu'il faudrait pouvoir utiliser les machines pour se faire une idée. Je rajouterais seulement un petit bémol dans ta description et ce sans aucune attaque. Tu sembles sous-entendre que les processeurs quad-core sont "de base" sur le pro, alors que pour avoir un quad-core il faut lâcher 1999€ et on a toujours pas de GPU dédié, tout ce qui est avant dans la gamme est bien en dual-core. Ce que je disais dans mon message précédent, c'est que dans cette gamme de prix (quad-core et GPU dédié), le air est hors-course. Cordialement. *edit : en fait tu sous-entends rien du tout, c'est juste moi qui ai mal lu, tu précises bien le haut de gamme pour le quad-core. Mes excuses. Ce message a été modifié par Mayeric - 14 Mar 2015, 14:59. |

|

|

|

14 Mar 2015, 14:59 14 Mar 2015, 14:59

Message

#12

|

|

|

Nouveau Membre Groupe : Membres Messages : 3 Inscrit : 14 Mar 2015 Membre no 194 571 |

@Mayeric : Merci pour ta réponse ! Tu confirmes ce que je pensais ! Niveau processus lancés, j'ai souvent besoin de pas mal de trucs en même temps : sublime text (ça consomme pas grand chose), Codekit + google chrome + safari + spotify + sketch + pixelmator... Je fais l'effort de fermer quand pas besoin mais je switch entre toutes ces apps pendant que je travail (Dropbox qui tourne en fond qui mine de rien bouffe pas mal aussi !)

J'avais pris un macbook air 11 pouces et en déplacement l'écran est vraiment petit. J'éspérais de meilleurs performances pour les nouveaux macbook pro retina. Du coup je suis sceptique, je vais devoir revendre le miens et si j'arrive à en tirer 1000 € ça sera déjà bien (acheté 1349 € tout de meme) et claquer 1449 pour la macbook pro retina pour un écran plus grand et meilleur définition mais un saut de puce niveau performance ;( |

|

|

|

14 Mar 2015, 15:07 14 Mar 2015, 15:07

Message

#13

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 2 352 Inscrit : 29 Aug 2005 Membre no 44 705 |

A l'utilisation on ne sentira aucunement ce gain de performances, par contre on en bavera au quotidien en raison de l'absence du port USB3 pourtant indispensable en complément de l'USB-C. Que faudra-t-il pour faire réagir le consommateur ? Un boycott de ce genre de produit serait, à terme, salutaire pour tout le monde ! Il est question des MBA et MBR ici, pas du MacBook. Les MBA n'ont eu qu'un port USB sur les deux premières versions je crois (mais en plus d'un chargeur). -------------------- AppCleaner Désinstaller proprement Mac in chemistry Mac et sciences

AppShoper Toutes les promos iOS D-O-F Blog français sur FCPX |

|

|

|

14 Mar 2015, 19:02 14 Mar 2015, 19:02

Message

#14

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 63 Inscrit : 17 Oct 2006 Lieu : Bruxelles Membre no 70 631 |

@Bug

Nope -> il y avait le connecteur du chargeur et sur le côté escamotable du macbook air 1er du nom, on avait accès à l'USB, le jack et une sortie displayport. Ceci dit, à l'époque, j'ai eu un adaptateur usb défaillant qui m'a cramé le port usb du Air : résultat, toute la partie de la carte mère avec la connectique comme l'usb, l'audio et le wifi ont cramés. Je me retrouvais avec un mac fonctionnel mais incapable de se connecter à quelque chose. Impossible donc d'en faire quoi que ce soit. Résultat -> remplacement complet de la carte mère, 640 euros à l'époque. :-) Je suis tombé sur cette vidéo d'un ingé de chez apple qui explique la démarche de conception du dernier macbook. https://www.youtube.com/watch?v=KHZ8ek-6ccc (;-p) Ca m'a fait sourire et ça résume bien les soucis/questions que de tels compromis engendrent. |

|

|

|

14 Mar 2015, 19:40 14 Mar 2015, 19:40

Message

#15

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 511 Inscrit : 5 Jan 2002 Lieu : Nantes (aux confins du Retz) Membre no 1 754 |

Faut aussi comprendre que t'as plus interet a avoir beaucoup de RAM et un gros SSD plutot qu'un CPU de derniere generation avec 16 core qui vont passer leur temps a rien faire... Bref, il peut etre bien plus intéressant de prendre une machine de génération précédente (en refurb) avec un bon GPU, beaucoup de RAM un un gros SSD, vu la stagnation des CPU actuels... Tout à fait d'accord. C'est pour cela que mon MBP de 2011 est encore très véloce malgré sa CG AMD. Tu sembles sous-entendre que les processeurs quad-core sont "de base" sur le pro, alors que pour avoir un quad-core il faut lâcher 1999€ et on a toujours pas de GPU dédié, tout ce qui est avant dans la gamme est bien en dual-core. 2249€ depuis quelques jours Le Refurb va devenir incontournable -------------------- En service :

MacBook Pro 16" 2021 • M1 Pro • 1To • 32 Go • Refurb MacBook Pro 15" mi 2014 • i7 2,5Ghz • SSD 512Go • 16Go RAM • Mojave • Refurb En sommeil : iBook G3 Late 2001 • 600Mhz • Tiger |

|

|

|

14 Mar 2015, 22:41 14 Mar 2015, 22:41

Message

#16

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 187 Inscrit : 15 Nov 2005 Membre no 49 996 |

Certes la progression est tres faible, mais elle correspond a ce qui ete attendu de la presence d'un CPU ayant une frequence superieure. Toi faudrait vraiment qu'on te mette sur dynamo... Tu tournes tellement vite sur toi même qu'on aurait une source d'énergie inépuisable Il y a quelques jours, tu étais au bord de l'orgasme quand les premiers résultats geekbenchs semblaient plutôt montrer une stagnation des performances... Tu trouvais ces résultats parfaitement normaux ("Mais ce qui est deja certain, c'est que Broadwell n'apporte rien en puissance.", en réponse à mes doutes sur la validité de ces résultats...), et maintenant tu nous dis que des résultats supérieurs étaient attendus ? Et tu remarqueras que les gains relevés ici, ne correspondent pas seulement à l'augmentation de fréquence et prouvent (100 MHz sur un CPU à 2.6 GHz, ça fait même pas 4%), s'ils se confirment (ça reste du Geekbench, donc à confirmer avec quelque chose de plus fiable...), que l'architecture Broadwell est effectivement plus rapide à fréquence égale que Haswell (Intel promet 5.5% de gain d'IPC, c'est de l'ordre de ce qu'on retrouve ici), puisqu'on voit que les modèles Broadwell égalent, voir dépassent les performances de modèles Haswell avec 100 MHz de plus... Donc comme en plus Apple a mis des Broadwell 100 MHz plus rapides pour le même prix (en dollars, les prix en euros ont évolué à la hausse à cause du taux de change, pas à cause de l'évolution de la configuration), on a une partie du gain qui vient du gain de fréquence, une partie qui vient du gain de l'architecture, et sans doute également une partie qui vient du gain de consommation : une consommation plus faible à fréquence égale permet de pousser le turbo plus haut en fréquence dans des tâches pour lesquelles ils ne pouvait pas atteindre son maximum à cause de la limite de consommation... c'est sans doute ce qui explique que les résultats multi-core soient plus favorables au Broadwell que les single-core, le turbo en multi-core étant plus souvent limité par la consommation qu'en mono. Mais bon, j'attendrais quand même des benchs plus sérieux que Geekbench pour avoir un avis définitif sur la question, même si ces nouveaux résultats Geekbench sont déjà bien plus en accord avec ce qu'on a pu voir jusqu'à présent dans les divers tests de PC... Au passage, ces résultats montrent une nouvelle fois ce que je me tue à répéter depuis des années : Geekbench, c'est sympa pour avoir un résultat approximatif rapidement, mais c'est justement trop rapide pour être fiable... Il y a 3 jours, sur la base de résultats Geekbench on nous disait que les nouveaux MB(A|P) avaient les mêmes performances que les anciens malgré 100 MHz de plus, maintenant avec le même bench on nous dit que finalement ils sont 7 à 14% plus rapides, ce qui dépasse le gain apporté par les 100 MHz de plus... Suffit de regarder la base de résultats Geekbench pour comprendre le problème, puisque pour le MBPR en Core i5-4278U 2.6 GHz on trouve des scores single/multi qui s'étalent de 2339/4612 à 3203/6852 Histoire d'avoir quelque chose de plus fiable, il serait intéressant de faire un script qui prenne pour une machine donnée tous les résultats de la base Geekbench, enlève les 10-20% inférieurs et supérieurs et fasse la moyenne de 60-80% restants. Ça gommerait sans doute le gros des imprécisions de Geekbench. Avis aux amateurs s'il y en a un que ça motive de faire ça La question qui reste c'est maintenant de savoir si les générations précédentes de processeurs a la même fréquence auraient données des résultats similaires, moins bons, ou meilleurs? Et la reponse n'est pas évidente. Bah au regard de ces benchs, non, la question ne se pose plus, puisque le nouveau à 2.9 GHz égale l'ancien à 3 GHz et le nouveau 2.7 dépasse l'ancien 2.8... Augmenter la fréquence de 100 MHz par rapport à la génération précédente, mais en restant sur du Haswell n'aurait donc pas apporté autant de gain de performances...Par ailleurs, ce gain de 100 MHz en passant à Broadwell se fait sans surcoût, comme je te l'ai déjà expliqué l'autre jour. Par exemple, un i5-5287U à 2.9 GHz, c'est le même prix qu'un i5-4308U à 2.8 GHz (315$), qu'il dépasse largement, et est 26% moins cher que le i5-4578U à 3 GHz qu'il dépasse légèrement... Le rapport performances/prix est donc nettement en faveur du Broadwell. Comme il a aussi jusqu'à preuve du contraire l'avantage sur le rapport performances/consommation et qu'il ne nécessite aucune évolution significative de la carte mère par rapport à Haswell, rester sur Haswell serait totalement injustifié : on aurait eu des machines moins performantes et moins autonomes à prix égal, ou aussi performantes et moins autonomies pour plus cher (parce que faut pas rêver, le surcoût sur le CPU, il aurait pas été pris sur la marge d'Apple hein). Intel a compensé la stagnation du core en puissance de calcul brute par un ensemble de coprocesseurs qui déchargent le Core de plus en plus de taches et les font bien mieux et bien plus vite: ex le GPU, l'unite qui s'occupe de la cryptographie, l'unite vectorielle, les divers DSP, la gestion de l'alimentation Décidément, on a beau te le répéter, tu continues à débiter les mêmes âneries...Non, l'unité vectorielle n'est PAS un coprocesseur. C'est justement l'un des intérêts du x86, c'est qu'il permet très facilement d'intégrer de nouvelles instructions directement dans le processeur, évitant ainsi de passer par un coprocesseur, avec tous les inconvénients que ça implique : un coprocesseur a son propre flux d'instructions, donc ça duplique en partie les circuits de décodage d'instructions, il doit communiquer avec le CPU via le goulet d'étranglement du bus système, ce qui limite les performances, il n'a pas d'accès direct à la mémoire et au cache (sauf éventuellement son propre cache s'il en a un...), et encore moins aux registres. C'était d'ailleurs l'un des griefs d'Intel envers ARM à l'époque des Xscale : alors que sur un Pentium l'unité MMX a pu être directement intégrée dans le cœur d'exécution, elle devait être un coprocesseur sur le Xscale, ce qui réduisait son bénéfice. Donc la cryptographie et l'unité vectorielle (enfin les unités vectorielles), ça fait partie intégrante du cœur d'exécution sur un x86. Le GPU, ça reste bien entendu indépendant. Mais en dehors de la 3D et d'OpenCL, tous les gains de performances qu'on observe sur les générations successives de processeurs Intel sont obtenus SANS recours au GPU. Et c'est le cas de ces résultats geekbench, qui sont bien des résultats CPU, pas GPU. C'est à ma connaissance la seule unité de traitement qui soit externe au CPU sur les Core i (c'est quoi les "divers DSP" dont tu parles ?). -------------------- |

|

|

|

14 Mar 2015, 23:03 14 Mar 2015, 23:03

Message

#17

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 149 Inscrit : 20 Nov 2010 Lieu : l'ouest... Membre no 161 510 |

Attendons les tests des parties graphiques de ces nouveaux processeurs (je n'ai pas encore vu) pour avoir une idée définitive de l'évolution...

|

|

|

|

14 Mar 2015, 23:11 14 Mar 2015, 23:11

Message

#18

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 187 Inscrit : 15 Nov 2005 Membre no 49 996 |

Attendons les tests des parties graphiques de ces nouveaux processeurs (je n'ai pas encore vu) pour avoir une idée définitive de l'évolution... 20% d'unités de calcul en plus, 8.3% de fréquence max en moins.On peut donc attendre des gains de l'ordre de 10-15%. -------------------- |

|

|

|

15 Mar 2015, 09:08 15 Mar 2015, 09:08

Message

#19

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 305 Inscrit : 22 Aug 2001 Lieu : Paris Membre no 668 |

De toute facon Apple ne peut pas malgre ses competences faire progresser la puissance de calcul plus que le processeur d'Intel ne le permet. La question qui reste c'est maintenant de savoir si les générations précédentes de processeurs a la même fréquence auraient données des résultats similaires, moins bons, ou meilleurs? Et la reponse n'est pas évidente. Maintenant il ne reste plus qu'a esperer que les mise a jours de l'automne en version Skylake auront une meilleure performance a frequence egale. Absolument… c'est un reproche à l'industrie au général, pas à Apple en particulier. Enfin reproche… même pas, juste un peu de frustration. D'habitude je change tous les ans, parce que le gain est tel, que je gagne plusieurs minutes de travail par jour… mais la non… perdre 1/2j pour faire les transferts, et mettre 1500€ pour avoir en gros la même chose question compilation… bah je fais durer. 3 ans, c'est un record pour moi. Si je devais changer, oui, la machine était sympa en 2012, elle l'est encore plus aujourd'hui. L'autonomie est vraiment bonne maintenant, et le gap avec ma machine de 2012 semble significatif. Skylake ne m'impressionne pas non plus énormément. Sur du calcul de masse, peut-être, mais la encore, ça ressemble aux arguments en carton de la fin de vie du G5. Ca dépote, mais sur des utilisations tellement ciblées. Je ne suis plus très renseigné, mais j'ai l'impression qu'on va stagner encore un peu en 2015. -------------------- MBP13 Early 2015 - Core i7.

|

|

|

|

15 Mar 2015, 09:36 15 Mar 2015, 09:36

Message

#20

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 305 Inscrit : 22 Aug 2001 Lieu : Paris Membre no 668 |

Bonjour, j'aimerais comprendre si quelqu'un peut éclairer ma lanterne. J'ai actuellement un macbook air 2013 i7 (et 8 go de ram, que je branche sur un écran externe). On m'a toujours dis que le macbook air n'était pas fait pour travailler assez lourdement (je suis dans le webdesign, je fais pas mal de graphisme, un peu de montage video etc..). Je commence à sentir les limites de la bête et je comptais me tourner vers un macbook pro retina car pareil tout le monde me dit qu'il faut un macbook pro pour travailler dans de bonnes conditions. Mais je ne comprends pas car au niveau des résultats obtenu sur ce genre de test comme geekbench et autre, les différences entre macbook air et macbook pro sont tout de meme minimes j'ai l'impression. Mais par contre j'imagine que le turbo doit se déclencher moins souvent sur un macbook pro vu la fréquence processeur, mais je ne vois pas en quoi je gagnerais du confort de travail avec un macbook pro retina. Ecoute, ça va encore faire des longs débats, mais dire que le MB Air n'est pas **pro** c'est être victime du marketing. La version courte, pour te donner un ordre de gardeur, c'est que le cpu du MBA est plus rapide qu'un MacPro (une tour) d'il y a 5 ans, sur la plupart des usages (meme en multi-cpu tu viens chatouiller un Nehalem d'entrée de gamme). Tu ajoutes le SSD dans la balance, et tu as à mon avis, une machine plus productive. Et il me semble qu'en 2010, on bossait déjà dans de bonnes conditions sur un Mac Pro. Maintenant, si tu veux vraiment avoir une différence, en encodage vidéo, ou pour les rendus, va sur une solution quadcore, la oui, tu vas t'envoler (enfin question CPU, parce que toi avec 1.5kg de plus dans ton sac à dos, tu vas bien tenir au sol). Pour les plugins un peu poussés d'étalonnage, de traitement poussé du son, aussi, le quad core va t'aider. Sur photoshop, question rapidité, ce sera la même chose, grosso modo, entre les MBA et le 13Retina. Le vrai GPU du 15' peut t'aider dans le travail, par ex, c'est vrai que quand j'ouvre un énorme PDF venu d'autocad (full vecto - genre 30Mo la page & millions d'arcs), dans aperçu sur mon MBA, c'est long par rapport à l'iMac-Core-i5-mais-vrai-gpu de mon client. A mon (pas si) humble (j'avoue) avis, la seule bonne raison de passer au MBP13, c'est son écran. Mais bon, vu que tu utilises un écran externe... Nous on fait du code principalement, mon associé à un Pro Rétina de l'année dernière et moi un MBA de 2012. Le temps total de déploiement de notre serveur (compilation, package, release, lancement): 52 vs 57 secondes. Je pense que le delta vient du SSD en PCI express, plus que du CPU. Au final, mon avis est que si tu veux aller plus vite, ne change pas pour un pro 13', tu vas être décu. Si tu peux te contenter d'un trans-portortable, va sur le 15' en quad-core, la oui, tu vas sentir un vrai mieux. -------------------- MBP13 Early 2015 - Core i7.

|

|

|

|

15 Mar 2015, 09:51 15 Mar 2015, 09:51

Message

#21

|

|

|

Macbidouilleur d'argent !    Groupe : Membres Messages : 726 Inscrit : 30 Dec 2003 Membre no 12 896 |

Personnellement, je viens de vendre mon MBA 4/128 de 2012 pour un MBPr 8/256 de 2015.

Je trouve que le bon de performances entre les deux est très sensible. Sans parler de l'écran retina qui a été un gros argument pour changer. Le nouveau Trackpad est sympa. Je n'utilisais que le toucher pour cliquer mais là c'est très agreable et mieux que l'ancien vrai clic. Pour l'autonomie je n'ai pas encore assez de recul mais si c'est vraiment équivalent a mon iPad Air ce sera top. -------------------- MacBook Pro 16" M1 Pro + Studio Display 27" / iPad Pro 11" 2020 WiFi 128 Go + Pencil 2 / iPhone 14 Pro

Quelques actions AAPL ... "La simplicité est la sophistication ultime" (L. da Vinci) |

|

|

|

15 Mar 2015, 12:21 15 Mar 2015, 12:21

Message

#22

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Certes la progression est tres faible, mais elle correspond a ce qui ete attendu de la presence d'un CPU ayant une frequence superieure. Toi faudrait vraiment qu'on te mette sur dynamo... Tu tournes tellement vite sur toi même qu'on aurait une source d'énergie inépuisable Bravo pour l'attaque personnelle: tu n’arrivais déjà plus qu'a surnager mais la tu coules dans la vulgarité et tes propos n'ont plus la moindre crédibilité ou un quelconque intérêt. C'est pathétique et ça en dis long sur ton comportement et sur ce qu'il te reste. Je sais pas quel est ton problème exactement, a part que tu détestes Apple, mais on dirait que ton jugement n'est plus qu’émotionnel et réactionnel et tu ne supporte plus de ne pas avoir raison, d’être contredis, que ce soit par quelqu'un et plus encore par la réalité. Même lorsque l'on ne s'adresse pas a toi, tu attaques les gens, tu les apostrophes vulgairement, et tu ne développe pas d'argumentaire construit... Tu n'as plus d'opinion mais tu défends un dogme...! Mais regarde autour de toi: ici personne ne t'agresse, les gens ne font que parler de technologies. On se fout de qui tu es, d’où tu viens, de ce que tu peux représenter, de ton métier, de ta formation ou pas. Tu n'existes pas! La seule chose ici c'est que l'on écrit, on échange des opinions, on constate des faits. Le fait dont il est question ici c'est qu'Intel est pris une fois de plus en défaut sur sa propagande face a la réalité. On constate tous que le x86 n'est plus capable de monter en puissance, que la débauche technologique et financière d'Intel aboutie a un surplace incontestable. Broadwell est un échec a divers niveaux pour Intel, qui a pourtant fait des investissements de manière colossale. Le passage de 22nm a 14nm n'apporte vraiment pas grand chose, et surtout en regard des investissements qui ont été nécessaires pour sa mise en place. Intel se retrouve aujourd'hui en concurrence directe et frontale avec Samsung: TSMC et GF ne sont pas loin... Tous constatent que la conjecture de Moore a atteint son terme. Lionel a commencé cette serie d'articles des la sortie des premiers exemplaires avec ce que nous disons tous, ici: broadwell n'apporte rien qui ne justifie l'achat d'une nouvelle machine. On le voit tous, on est tous d'accord. Apres ca veut pas dire que les machines sont a jeter, mais le bon conseil c'est d'attendre la prochaine génération ou d'acheter une machine a un meilleur prix sur le refurb, c'est tout. Broadwell aurait du signer un mise a jour majeure des Mac et des PC, voire révolutionner le marche mobile: c'est un échec assourdissant. Broadwell est si en retard qu'il n'y a que les petits portables qui peuvent etre equipés, il risque de ne jamais y avoir de broadwell en dehors, Intel passant directement a Skylake. Et les performances de broadwell signent une stagnation incontestable. On constate tous que le passage a Broadwell des plus petits Mac est anecdotique: pour qu'Apple mentionne cette mise a jour il a fallut parler d'autres technologies. Les Mac concernés sont un peu plus rapides grâce a des fréquences un peu plus élevées, ben oui c'est logique fréquence plus élevée = vitesse supérieure. Apple aurait mis des Haswell avec le meme gain de frequence, on aurait eu le meme gain de vitesse... Apple n'aurait juste pas pu monter autant le prix de ses machines. Mais en fait on s'en fout. D'ailleurs les quelques lecteurs de ce forum, majoritairement j'ai l'impression, se contrefichent totalement de que ce tu peux raconter et n'ont aucun intérêts dans tes propos. Pas plus que dans les miens. La seule chose qui leur importe c'est pour une partie de savoir s'ils ont un intérêt a acheter cette génération 2015. Et ce que tout le monde leur dis, c'est que non, ces machines ne sont pas meilleures que celles d'il y a 2ou 3 ans pour l'utilisation qu'ils en ont. C'est tout. Et ça s’arrête la. Que je donne quelques infos, fasse des remarques, conteste la propagande d'Intel pour la remettre face a la réalité, ce qui va intéresser un peu quelques uns c'est le débat technique et les connaissances que ca peut véhiculer. En dehors d'un argumentaire technique que n'importe qui pourrait tenir, tes propos a ce niveau n'ont pas la moindre importance. Ce message a été modifié par r@net54 - 15 Mar 2015, 12:56. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

15 Mar 2015, 12:44 15 Mar 2015, 12:44

Message

#23

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 12 571 Inscrit : 25 Nov 2001 Membre no 1 397 |

Le fait dont il est question ici c'est qu'Intel est pris une fois de plus en défaut sur sa propagande face a la réalité. On constate tous que le x86 n'est plus capable de monter en puissance, que la débauche technologique et financière d'Intel aboutie a un surplace incontestable. Broadwell est un échec a divers niveaux pour Intel, qui a pourtant investit de manière colossale. Le passage de 22nm a 14nm n'apporte vraiment pas grand chose, et surtout en regard des investissement qui ont été nécessaire pour sa mise en place. Intel se retrouve aujourd'hui en concurrence direct et frontal avec Samsung: TSMC et GF ne sont pas loin... Tous constatent que la conjecture de Moore a atteint son terme. Ce constat est faussé et la loi de Moore n'a aucun sens. Le x86 ne monte plus en puissance parce que aujourd'hui le marché est différent et Intel doit s'adapter. Ce sont les puces économes qui se vendent de nos jours. ARM doit monter en puissance en restant dans le même ordre de consommation. Intel doit faire l'inverse, baisser la consommation sans perdre en puissance. La loi de Moore avait pour but de servir de base pour le marché. Ce message a été modifié par zero - 15 Mar 2015, 12:56. |

|

|

|

15 Mar 2015, 13:12 15 Mar 2015, 13:12

Message

#24

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 187 Inscrit : 15 Nov 2005 Membre no 49 996 |

Mais regarde autour de toi: ici personne ne t'agresse Il est mignon... L'autre jour, quand je contestais la validité des premiers résultats Geekbench des nouveaux MBP/MBA, tu m'as traité de "dévot du x86", et maintenant, alors que les faits me donnent finalement raison et que je pointe du doigt ton magistral retournement de veste sur le sujet (puisque tu considères maintenant que les gains de performances étaient attendus, trois jours après m'avoir insulté parce que je contestais la validité d'un test qui ne montrait pas de gain... et que même les auteurs du bench disaient de prendre avec des pincettes), tu fais ta vierge effarouchée et m'accuse de faire une attaque personnelle alors que personne ne m'avait agressé ? Trop gros, ça passera pas...Ce nième retournement de veste de ta part, au fur et à mesure que les faits prouvent que tu avais tort, montre à quel point tes propos ne sont pas crédibles, ce qui explique aussi pourquoi à chaque fois qu'on te demande tes sources tu es incapables d'en fournir... d’être contredis, que ce soit par quelqu'un et plus encore par la réalité. Même lorsque l'on ne s'adresse pas a toi, tu attaques les gens, tu les apostrophes vulgairement, et tu ne développe pas d'argumentaire construit... Contredis par la réalité ? Contrairement à toi, je donne régulièrement des sources qui prouvent mes propos... Toi, même quand on te les demande, on n'en obtiens rarement, pour ne pas dire jamais...Quand à l'absence d'argumentaire construit comment dire... Peut-être que si tu t'arrêtais pas à la première ligne de mes posts, tu le verrais l'argumentaire... Le fait dont il est question ici c'est qu'Intel est pris une fois de plus en défaut sur sa propagande face a la réalité. La "propagande" d'Intel, elle affirme que l'IPC progresse de 5.5% entre Haswell et Broadwell*. En quoi les résultats donnés ici montrent que cette "propagande" est fausse ? C'est tout le contraire, ces résultats tendent justement plutôt à le confirmer, puisqu'on voit qu'un Broadwell 2.9 GHz atteint les mêmes performances, voir un peu plus, qu'un Haswell 3 GHz... Tu vois, c'est ça la réalité : Broadwell démontre des performances supérieures à Haswell avec une fréquence de base inférieure de 100 MHz, une fréquence turbo inférieure de 200 MHz (3.3 GHz contre 3.5) et 1 Mo de cache en moins (3 contre 4). Mais bon, puisque tu prétends que l'architecture n'apporte rien, on va te croire sur parole On constate tous que le x86 n'est plus capable de monter en puissance C'est vrai que jusqu'à 14% de gains d'une génération à l'autre pour le même prix (i7-5650U vs i7-4650U, tous deux à 426$), c'est pas énorme. Mais de là à prétendre qu'il n'y a pas de gain broadwell n'apporte rien qui ne justifie l'achat d'une nouvelle machine. On le voit tous, on est tous d'accord. Oui, si on a une machine qui n'a que deux ou trois ans. Rien de nouveau à ce niveau, c'est normal, ça fait bien longtemps que ça n'a aucun intérêt de renouveler aussi rapidement. La dernière fois que ça valait le coup de remplacer une machine de l'année passée, c'est quand les premiers processeurs à 4 cœurs sont arrivés, avec du coup un doublement des performances brutes par rapport à l'année d'avant.Mais les gains apportés par Broadwell en termes de performances et d'autonomie pour un même coût sont bien là, et ils sont absolument pas négligeables. Broadwell aurait du signer un mise a jour majeure des Mac et des PC Non, ça n'a jamais été le but de Broadwell, qui n'est qu'un die shrink d'Haswell... En dehors des gains de consommation, qui ont permis une mise à jour majeure des tablettes, dont on sait que c'était LE but d'Intel avec Broadwell, il n'y avait pas grand chose de plus qu'un léger gain de performances et d'autonomie à attendre de Broadwell... C'est ce qu'on a obtenu.voire révolutionner le marche mobile: c'est un échec assourdissant Tu as vu les performances qu'on arrive maintenant à sortir d'une tablette de 8mm d'épaisseur grâce à Broadwell ? On arrive enfin à des tablettes qui peuvent devenir l'ordinateur principal, sans sacrifier sur la mobilité (finesse et autonomie)... C'est sans conteste le plus grand bon en avant fait par les tablettes en 5 ans.Les Mac concernés sont un peu plus rapides grâce a des fréquences un peu plus élevées, ben oui c'est logique fréquence plus élevée = vitesse supérieure. Non... Prenons par exemple le 4578U et le 5557U. On passe de 3.0 GHz à 3.1 GHz, c'est un gain de fréquence de 3.3%, tandis qu'en turbo on passe de 3.5 GHz à 3.4 GHz, soit une baisse de 2.9%. S'il n'y avait pas eu d'amélioration de l’architecture, en appliquant les mêmes fréquences à un Haswell on n'aurait pas pu avoir un gain de performances supérieur à 3.3% dans le cas où le processeur est à sa fréquence de base, tandis qu'on aurait eu une baisse pouvant approcher de 2.9% à fond de turbo. Hé oui, le gain de performances en augmentant la fréquence est AU MIEUX égal au gain de fréquence, JAMAIS supérieur, presque toujours inférieur (parce que c'est pas toujours la fréquence CPU qui limite les performances).Apple aurait mis des Haswell avec le meme gain de frequence, on aurait eu le meme gain de vitesse... Et là, qu'est ce qu'on voit ? Des gains qui atteignent 3.1% en mono-coeur et 6% en multi-cœur. Tu m'expliques comment un gain de 3.3% en fréquence et une baisse du turbo de 2.9% aurait pu apporter 6% de gain en restant sur Haswell ? La seule explication, c'est que ça vient de l'amélioration de l'architecture (IPC en hausse de 5.5% selon Intel*) et de la baisse de consommation qui permet de maintenir le turbo à sa fréquence maximale dans des situations où ce n'était pas possible avec Haswell (d'où l'écart plus grand quand les deux cœurs sont sollicités, puisque c'est justement dans ce cas que le turbo est le plus limité par le TDP). Impossible d'avoir de tels gains avec Haswell en augmentant simplement la fréquence de 3.3%. En single core, les gains viennent même probablement quasiment exclusivement de l'amélioration de l'architecture, puisque la fréquence turbo maximale a baissée et qu'en single core le processeur peut généralement rester à fond de turbo, même à pleine charge. Tu vois, moi j'argumente... Je pense qu'avec le même gain de fréquence, on aurait pas eu le même gain de vitesse, mais je me contente pas de l'affirmer comme en fait établi en n'apportant ni argument, ni source pour étayer cette affirmation, j'explique pourquoi je le pense... Maintenant, si tu as des arguments pour étayer ton affirmation, je suis tout ouïe. Je serais très curieux de savoir comment selon toi une hausse de fréquence de base de 3.1% et une baisse de fréquence turbo de 2.9% pourrait apporter un gain de performances 6%. Et encore une fois, comme je te l'ai déjà expliqué, passer à des Haswell de fréquence supérieure aurait impliqué une augmentation du prix du CPU et une hausse de la consommation, donc une baisse de l'autonomie à capacité de batterie égale. En passant à Broadwell, non seulement les performances à fréquence égale sont supérieure, mais en plus l'augmentation de la fréquence est gratuite (sur les Macbook Pro, les Broadwell à une fréquence x sont au même prix que les Haswell à x - 100 MHz au catalogue Intel, sur le MBA le 5650U à 2.2-3.1 GHz est au même prix que le 4650U à 1.7-3.3 GHz) et la consommation est en baisse... Absolument RIEN n'aurait donc justifié de rester sur Haswell. * source : le sixième slide Intel sur cet article d'AnandTech : http://www.anandtech.com/show/9070/intel-x...-for-enterprise Ça concerne les Xeon, mais le cœur d'exécution des Xeon et des Core i est le même. -------------------- |

|

|

|

15 Mar 2015, 14:15 15 Mar 2015, 14:15

Message

#25

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 511 Inscrit : 5 Jan 2002 Lieu : Nantes (aux confins du Retz) Membre no 1 754 |

La seule chose qui leur importe c'est pour une partie de savoir s'ils ont un intérêt a acheter cette génération 2015. Et ce que tout le monde leur dis, c'est que non, ces machines ne sont pas meilleures que celles d'il y a 2ou 3 ans pour l'utilisation qu'ils en ont. On aurait même pu rajouter 1 ou 2 ans de plus si il n'y avait pas eu le passage à l'USB3. Je suis d'accord avec toi pour dire que l'utilisateur lamba n'a que peu d'intérêt à changer de machine actuellement. Alors après on peut parler chiffres, 3%, 6% de gain qui n'intéresseront que les geek. Mais ces minuscules pourcentages se traduisent par des milliers d'euros dans la vraie vie ! Et c'est de ça qu'on parle -------------------- En service :

MacBook Pro 16" 2021 • M1 Pro • 1To • 32 Go • Refurb MacBook Pro 15" mi 2014 • i7 2,5Ghz • SSD 512Go • 16Go RAM • Mojave • Refurb En sommeil : iBook G3 Late 2001 • 600Mhz • Tiger |

|

|

|

15 Mar 2015, 15:10 15 Mar 2015, 15:10

Message

#26

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Le fait dont il est question ici c'est qu'Intel est pris une fois de plus en défaut sur sa propagande face a la réalité. On constate tous que le x86 n'est plus capable de monter en puissance, que la débauche technologique et financière d'Intel aboutie a un surplace incontestable. Broadwell est un échec a divers niveaux pour Intel, qui a pourtant investit de manière colossale. Le passage de 22nm a 14nm n'apporte vraiment pas grand chose, et surtout en regard des investissement qui ont été nécessaire pour sa mise en place. Intel se retrouve aujourd'hui en concurrence directe et frontale avec Samsung: TSMC et GF ne sont pas loin... Tous constatent que la conjecture de Moore a atteint son terme. Ce constat est faussé et la loi de Moore n'a aucun sens. Le x86 ne monte plus en puissance parce que aujourd'hui le marché est différent et Intel doit s'adapter. Ce sont les puces économes qui se vendent de nos jour. ARM doit monter en puissance en restant dans le même ordre de consommation. Intel doit faire l'inverse, baisser la consommation sans perdre en puissance. La loi de Moore avait pour but de servir de base pour le marché. Ben la conjecture de Moore a servi de base pour de développement des x86 depuis 1975. En 1965 Moore, cofondateur d'Intel constate que la complexité des semiconducteur double a cout constant tous les ans. En 1975, trois an après l'apparition du microprocesseur, rendu possible par le transistor, Moore predit que le nombre de transistors dans le microprocesseur double tous les 18 mois, et de fait que la puissance du processeur liée au nombre de transistors subissait la même croissance. Donc en miniaturisant les transistors, on augmente la puissance en gardant le même cout. Le corolaire c'est que l'on peut augmenter la vitesse de traitement en augmentant la fréquence, et puisque la densité augmente, la fréquence peut augmenter dans le même ordre, se disait on alors... C'est effectivement la feuille de route d'une stratégie industrielle et commerciale qui s'est installée dans un monopole partagé entre Intel et Microsoft: Wintel. Moore avait prédit que la miniaturisation des transistors tomberait sur un "mur" physique aux environs de 2015. Sauf que le mur a ete atteint en 2004 en ce qui concerne la montee en frequence. Et la grosse epine dans ce dogme omniprésent a ete le développement du mobile, totalement rate par le x86(efficacite energetique), et surtout l’avènement du GPGPU(puissance de calcul), qu'Intel a aussi totalement raté avec Larrabee. Maintenant, si tu parles des évolutions technologiques en profondeur, il est vrai que le x86 rénové par AMD avec le passage a l'architecture 64bits et le passage a un moteur RISC, tout comme la parallélisation du traitement (pipeline/reordonnancement) ont changé la donne et ont modéré le principe de la conjecture de Moore pour la maintenir jusqu'a 2014. Ensuite la conjecture de Moore ne vaut que dans le monde x86. Dans le monde RISC les principes fondateurs sont différentes depuis le debut. On voit dans le monde ARM une croissance de la puissance qui s'opere avec au pire un maintien de la consommation et au mieux une diminution de cete comssomation. Et d'apres ARM la marge de progression pour les deux axes est encore conséquente comme le démontre le cortex A72 (-75%). Tu constates que le x86 ne monte plus réellement en puissance, on est tous d'accord. La ou les avis divergent c'est sur les causes. Je fais partie de ceux qui pensent que le x86 ne peut plus monter en puissance a cause des principes de fondement de son architecture, même si celle-ce a ete bien revue, notamment par AMD et aussi avec l'adoption du Finfet en 2011 par Intel. Le Finfet c'est un travail d'architecture sur le transistor pour augmenter son efficacité énergétique (plus de 35% de vitesse pour 2 fois moins d’énergie: certains estiment que c'est la plus importante évolution dans les processeurs depuis 40ans) On constate aussi que le besoin de puissance est toujours présent, même s'il n'est plus focalisé sur le CPU, mais va sur le GPU, le vectoriel, le traitement des ES, le traitement de signal,... tout ca realisé par des unités spécialisées utilisant des architectures différentes de celles du CPU: les coprocesseurs, qu'ils soient integres au SoC ou repartis sur la CM. Par contre l’efficacité énergétique est devenue une priorite. Pourquoi? On donne souvent comme argument que c'est face a la crise énergétique dans laquelle on s'engage. D'autres rapportent que c'est a cause de la miniaturisation des appareils. C'est deux arguments sont recevables, mais ne justifient pour autant pas l’arrêt de la croissance de la puissance... sauf sur les systèmes qui sont originellement et fondamentalement mauvais sur l’efficacité énergétique. Ils n'ont comme alternatives que de figer leur puissance en essayant d'etre énergétiquement plus rentable: en multipliant les core et en gerant plus finement l'alimentation en fonction des besoins reels, il y a une diminution de la consommation non negligeable pour le meme traitement: en gros si au lieu d'eclairer toute la ville en permanence on éclaire que les zone ou il y a des gens, on gagne en consommation... Bien sur l'autre solution c'est d'installer des ampoules LED qui elles sont tres efficaces énergétiquement... Je vais d'ailleurs prendre l'exemple de l'ampoule a incandescence: 95% de la production de ce type d'ampoule c'est de ... la chaleur! Donc plus on veut de puissance d’éclairage plus l'ampoule va dégager de chaleur et le filament va perdre de la matière. C'est typiquement mauvais en efficacité énergétique. Et on arrive a un parallèle assez intéressant: plus on veut de lumière plus il faut que la piece soit grande pour absorber la chaleur produite, et forcement si on a une pièce plus grande, il faut plus de lumière pour l’éclairer, et ainsi de suite. La solution c'est de ventiler, sauf que la aussi il y a des limites... Fondamentalement le x86 est par principe mauvais en efficacité énergétique, du fait qu'il s'appuie sur la conjecture de Moore, ce qui pourrait revenir -en reprenant l'exemple de l'ampoule a incandescence- a dire que pour augmenter la production lumineuse on augmente la puissance électrique, le filament doublant sa résistance a l’évaporation tous les 18 mois... L'exemple de ca c'est typiquement le P4. Intel n'avait pas de difficultés pour faire progresser sa puissance, il suffisait d'augmenter la densité de transistor et monter la fréquence. L'equation etait d'ailleurs encore simple pour le marketing: augmentation de fréquence = croissance de puissance. Sauf que ce principe a atteint un mur physique: celui de la gestion de la production thermique. Si les processeurs sont limités a 4Ghz c'est pas un chiffre qui est tombé comme ca de manière arbitraire: les causes sont des lois physiques. A partir de ce constat il a fallut changer de stratégie et commencer a s'adapter a la notion d’efficacité énergétique. En plus de cela les physiciens commencent a définir que seuls les systèmes physiques qui disposent d'une bonne efficacité énergétique intrinsèques peuvent durer et se développer. Intel étant soumis maintenant a une vraie concurrence, il faut qu'il fasse évoluer son système vers l’efficacité énergétique: très gros défi vu les bases de départ, mais c'est une question de survie. Ce message a été modifié par r@net54 - 15 Mar 2015, 15:21. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

15 Mar 2015, 15:56 15 Mar 2015, 15:56

Message

#27

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 187 Inscrit : 15 Nov 2005 Membre no 49 996 |

et surtout l’avènement du GPGPU(puissance de calcul), qu'Intel a aussi totalement raté avec Larrabee. Larrabee à la base, c'était un projet qui visait à faire un GPU à base de x86 (il y avait des pilotes DirectX et OpenGL...). C'est suite à l'échec de ce projet qu'Intel a décidé, plutôt que de tout jeter, de le réorienter vers un concurrent du GPGPU : c'est ainsi qu'est né le Xeon Phi, qui reprend les principes de Larrabee et qui sert à la même chose que le GPGPU. La seule chose qui a été abandonnée par rapport à Larrabee, c'est en fait la possibilité d'utiliser la puce comme un GPU... On ne peut donc pas considérer Larrabee comme un ratage total sur le GPGPU, alors qu'aujourd'hui une carte d'accélération basée directement sur les travaux du projet Larrabee permet justement à Intel de contrer efficacement le GPGPU dans le HPC. À tel point que c'est grâce à ce descendant de Larrabee que, pour la première fois de l'histoire du Top 500, une machine dont toute la puissance de calcul provenait de puces Intel est arrivée en tête du classement en juin 2013, et n'a plus quitté cette place depuis (et ça aussi, je crois que c'est une première, une machine qui reste en première position sur 4 classements de suite SANS modification de sa configuration matérielle (IBM avait eu 6 ou 7 premières place de suite avec BlueGene, mais c'était en ajoutant régulièrement des processeurs, la machine était passée de 65 000 cœurs à plus de 200 000)...Maintenant, si tu parles des évolutions technologiques en profondeur, il est vrai que le x86 rénové par AMD avec le passage a l'architecture 64bits et le passage a un moteur RISC, tout comme la parallélisation du traitement (pipeline/reordonnancement) Sauf que comme on te l'a déjà expliqué, le décodage des instructions x86 en micro-ops avant leur injection dans le pipeline est arrivé bien avant le 64 bits (2002), aussi bien chez Intel (Pentium Pro, 1995) que chez AMD (K5, 1996).Et clairement, aujourd'hui ces micro-ops ne peuvent pas être considérées comme du RISC, c'est plutôt du VLIW, depuis qu'Intel a introduit la fusion de micro-ops (avec le Pentium M, repris plus tard par AMD de façon très limitée dans le K8, puis plus complète dans le K9). De même pour le pipeline et l'exécution out-of-order, ce n'est pas AMD qui a introduit ça dans le x86. Le 8086, c'est-à-dire le tout premier CPU x86, il avait déjà un pipeline (en fait, j'aimerais bien un exemple de processeur sans pipeline... je ne pense pas que ça existe), et le premier x86 conçu par AMD était l'Am386 (avant, AMD utilisait directement les micro-architecture Intel sous licence), des années plus tard. Pour l'out-of-order, le premier x86 à le faire était le Pentium Pro, en 1995, suivi par l'AMD K5 en 1996 (qui est du coup le premier x86 grand-public à le faire, mais pas le premier x86... chez Intel c'est arrivé chez le grand public avec le Pentium II, basé sur le Pentium Pro, en 1997). Quand à la parallélisation en interne, avec les pipelines superscalaires, c'est aussi Intel qui l'a introduit sur le x86, avec le Pentium, en 1993, AMD a attendu 96 avec le K5. Et c'est d'ailleurs pareil sur les CPU ARM les plus performants, qui ont aussi adopté le décodage en micro-ops suivi d'une fusion de micro-ops et atteignent un niveau de complexité qui n'a plus rien à voir avec ce que prône le RISC (un cœur Apple Cyclone, c'est aujourd'hui plus complexe qu'un cœur Intel Atom : l'analyse de la surface des cœurs démontre clairement que le cœur Cyclone utilise plus de transistors que le cœur Atom, et ce malgré une quantité de cache moindre...). C'est deux arguments sont recevables, mais ne justifient pour autant pas l’arrêt de la croissance de la puissance... La croissance de la puissance n'a pas été arrêtée, sur les marchés où il y a encore une forte demande pour de la puissance supplémentaire : serveurs et datacenter.Sur le marché du PC, la demande pour plus de puissance c'est clairement tassée, depuis un moment. Parce qu'on a aujourd'hui des CPU qui répondent aux besoins de 99% des gens sans ralentissements. Je me souviens que quand j'ai commencé à m'intéresser à l'informatique, je changeais régulièrement de CPU, en prenant toujours le plus haut de gamme. Je ne changeais pas parce qu'il y avait plus puissant que ce que j'avais, mais parce que j'avais "besoin" de plus puissant, ce que je ressentais régulièrement à l'usage. Maintenant, je change pour réduire la consommation, et je ne prends même plus les puces les plus haut de gamme, car je sais que je n'ai absolument pas besoin du supplément de puissance qu'elles apportent... Tu me proposerais aujourd'hui un processeur deux fois plus rapide que le mien pour la même efficacité énergétique, ça ne m'intéresserait pas de le changer (de fait, ça existe du x86 deux fois plus performant que le mien, et non, ça ne m'intéresse pas de changer... je changerais peut-être dans deux ou trois ans...). Parce que je ne vois pas dans quel usage ça m'apporterait quelque chose. Même mon portable, beaucoup moins puissant que mon PC de bureau, me suffit en fait dans l'écrasante majorité des cas ! Et ce tassement de la demande de puissance ne concerne d'ailleurs pas que les CPU des PC, c'est aussi le cas sur les GPU (aujourd'hui avec un GPU milieu de gamme de 2-3 ans, tu fais tourner tous les jeux avec une bonne qualité, il y a dix ans c'était vraiment pas le cas), sur les mobiles... Fondamentalement le x86 est par principe mauvais en efficacité énergétique Sauf que aujourd'hui des solutions x86 sont régulièrement plus efficaces énergétiquement que des solutions à base d'ARM. Il n'y a que sur les CPU les moins performants qu'ARM arrive à surpasser l'efficacité énergétique du x86...Tiens par exemple, puisque l'autre jour tu vantais les mérites du X-Gene sur les serveurs, qui menacerait selon toi Intel, voici ce que ça donne niveau efficacité énergétique : http://www.anandtech.com/show/8357/explori...er-platforms/17 Le X-Gene offre les performances d'un Atom C pour deux fois et demi sa consommation, tandis que le Xeon E3-1230L a une efficacité énergétique près de 3 fois supérieure à celle du X-Gene... Tu parles d'une menace ^^ De même, si tu regardes ce qu'un Core M est capable de sortir comme performances avec une enveloppe thermique de 5W et si tu compares ça à ce que sort un SoC ARM haut de gamme, avec là aussi une enveloppe thermique qui approche aujourd'hui les 5W, voir la dépasse, ça ne fait aucun doute que l'efficacité énergétique est supérieure sur le Core M. Tiens, quelques chiffres de consommation à la prise mesurés à l'instant avec des appareils Android exécutant BOINC à 100% de charge CPU, écran éteint et batterie chargée, tous branchés au chargeur du Nexus 6 (sauf la TF701T qui a besoin de son chargeur propriétaire) : - 9.3W la tablette TF701T en Tegra 4 - 10.3W pour le Nexus 6 en Snapdragon 800 (et ça tombe à 8.3 quand il se met à faire du throttling parce que la température dépasse largement les limites du raisonnable et qu'on se retrouve avec un cœur à l'arrêt et un au 2/5 de sa fréquence) - 5.1W avec la Nexus 7 2013 en Snapdragon S4 Pro - 1.7W pour le Moto G 2013 en Snapdragon 400 Bien sûr on peut sans doute enlever 10-30% à cause du rendement du transfo, mais ça reste quand même des consommations élevées, on est loin des SoC ARM haut de gamme 2-3W d'il y a quelques années, des niveaux de consommation qu'on ne trouve plus que sur l'entrée de gamme aujourd'hui... -------------------- |

|

|

|

15 Mar 2015, 16:26 15 Mar 2015, 16:26

Message

#28

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Mais regarde autour de toi: ici personne ne t'agresse Il est mignon... L'autre jour, quand je contestais la validité des premiers résultats Geekbench des nouveaux MBP/MBA, tu m'as traité de "dévot du x86", et maintenant, alors que les faits me donnent finalement raison et que je pointe du doigt ton magistral retournement de veste sur le sujet (puisque tu considères maintenant que les gains de performances étaient attendus, trois jours après m'avoir insulté parce que je contestais la validité d'un test qui ne montrait pas de gain...Malgré ton cynisme, tes sarcasmes et tes véhémences gratuites, je ne t'ai jamais insulté. Pas plus qu je ne me permet d'avoir des comportements comme les tiens qui vont a la limite de l'agression dans des interpellations de plus en plus vulgaires face a des gens qui ne t'ont même pas désignés dans leurs propos. Je sais pas ce que je t'ai fais -ni ce que t'ont fait les autres- mais tu as l'air d'etre bloqué sur une idee fixe. Si je critique un produit d'Intel on dirait que c'est un outrage que je te fais personnellement, et si je constate un bénéfice, c'est soit que je suis une girouette, soit tu l’éludes soigneusement... Tu es dans un trip flippant tu sais, faut pas focaliser sur les gens comme ca. Y a pas de complot contre toi et ici c'est pas ton site non plus. Je te le redis, ici personne ne t'agresse, personne ne sait même qui tu es et n'a envie de le savoir. Tu n'es personne, tu n'as pas d’intérêt, pas plus que n'importe quel autre membres qui veut donner un avis. Seuls les débats techniques comptent ici, alors s'il te plait, reste poli et civilisé et ne prends pas ce lieux de partage et de connaissance pour ce qu'il n'est pas et surtout vient pas amener ici tes problèmes d'ego, de boulot ou personnels. Apres si tu as le sentiment que tu es investi d'une mission ou un truc du genre, c'est pas sur un site techno qu'il faut venir et chercher des noises aux uns et aux autres histoire de marquer ton territoire. Sur ce, bonne fin d'aprem et va profiter de l'air frais. Ce message a été modifié par r@net54 - 15 Mar 2015, 16:27. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

15 Mar 2015, 16:49 15 Mar 2015, 16:49

Message

#29

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 187 Inscrit : 15 Nov 2005 Membre no 49 996 |

Malgré ton cynisme, tes sarcasmes et tes véhémences gratuites, je ne t'ai jamais insulté. Si tu considères que "dévot" ou "apôtre" n'est pas insultant, permet moi de considérer que "girouette" ne l'est pas.Et si tu cessais une bonne fois pour toute de lancer des affirmations gratuites, sans la moindre source pour les prouver, même quand on t'en réclame quinze fois, je serais sûrement moins sarcastique. Désolé, mais quand je me fait chier à faire des explications argumentées et sourcées, je n'apprécie pas qu'on me contredise sans aucune argumentation ni source. Qu'on m'explique et qu'on me prouve que j'ai tort, je n'ai rien contre, bien au contraire, c'est justement pour ça que je participe à des forums. Mais qu'on prétende que j'ai tort sans jamais être en mesure de prouver ses propos, et alors que j'ai pour ma part apporté arguments et sources, je ne l'accepte pas. Et forcément à la longue, à force de répéter quinze fois la même chose, je finis par perdre patience et devenir sacrastique... Surtout que tu ne te gênes pas pour manipuler toi aussi le sarcasme hein... Je constate d'ailleurs ici encore que plutôt que de me répondre sur le fond, avec des arguments, tu ne parles plus que de la forme... Faute d'arguments de fond ? Et c'est comme ça à chaque fois avec toi, dès qu'on te demande d'argumenter sur le fond, c'est silence radio, ou bien répétition des mêmes affirmations comme si elles étaient elles mêmes un argument (voir retournement de veste si vraiment ta position n'est plus tenable...) Si je critique un produit d'Intel on dirait que c'est un outrage que je te fais personnellement, et si je constate un bénéfice, c'est soit que je suis une girouette Tu peux critiquer tous les produits Intel que tu veux, tout comme ceux de n'importe quelle autre société, sans que ça me dérange. Tant que la critique est étayée par des arguments vérifiables dans les faits.De même, tu peux critiquer un produit Intel et constater un bénéfice sur un autre sans être une girouette. Par contre affirmer un jour qu'il est CERTAIN que Broadwell n'apporte pas de gain de performance pour dire 3 jours plus tard que le gain de performances observé est attendu, ça oui, c'est être une girouette. Alors forcément, quand en plus la première fois tu m'as insulté parce que j'ai osé dire que l'absence de gain n'était pas normale et qu'il faudrait attendre d'autres tests, j'ai du mal à accepter que tu dises ensuite que le gain était attendu, c'est-à-dire exactement les propos pour lesquels tu m'avais insulté... Je sais pas ce que je t'ai fais -ni ce que t'ont fait les autres- mais tu as l'air d'etre bloqué sur une idee fixe. Ce que tu m'as fait ? Simplement un refus trop fréquent d'argumenter sur le fond, un refus d'apporter une source à tes propos, un refus de prendre en compte les démonstrations faites par d'autres (que ça soit moi où n'importe qui d'autres) qui montrent les faiblesses de tes positions face aux faits, un refus obstiné à ne pas voir la réalité en face quand on t'apporte pourtant sur un plateau toutes les preuves nécessaires.Tu n'es personne, tu n'as pas d’intérêt [...] surtout vient pas amener ici tes problèmes d'ego, de boulot ou personnels Et ça dit rester poli et civilisé, sans faire d'attaques personnelles Alors, pourquoi toujours pas de réponses à mes questions sur le fond ? Comment selon toi une hausse de fréquence de base de 3% et une baisse de fréquence turbo de 3% aurait apporté 6% de gain de performance ? Seuls les débats techniques comptent ici, alors s'il te plait, reste poli et civilisé Alors toi aussi, reste poli et civilisé. Et si tu aimes les débats techniques, prouve le : un débat sans argumentation étayée, ça n'est pas un débat ! Car ce qui est important dans le débat, c'est justement les arguments, pas les idées. Ce sont les arguments qui donnent toute leur valeur aux idées.Pour citer un exemple récent, dire que comparer la puissance brute du CPU d'un SoC avec celle d'un CPU hors SoC c'est aussi incohérent et approximatif que comparer un CPU à un DSP, mais sans apporter le moindre argument expliquant pourquoi, ça n'a aucune valeur (et en prime, c'est insultant pour celui qui a fait l'effort de construire cette comparaison avec des arguments techniques sur la question). Je n'accepte pas qu'on dise que mes propos sont incohérents sans m'expliquer en quoi ils le sont. Et quand je t'ai demandé pourquoi, hop, silence radio, y a plus personne... De même, dans ce fil de discussion, tu as affirmé que les mêmes gains auraient été possibles en appliquant les mêmes fréquences à des Haswell ou des Broadwell. Je t'ai apporté des arguments techniques expliquant pourquoi de mon point de vue on n'aurait pas pu avoir les mêmes gains, et pourquoi, quand bien même ce serait vrai, ça n'aurait pas d'intérêt (plus cher, plus énergivore). Je t'ai demandé d'apporter des arguments étayant ta thèse, pour les confronter aux miens. Peine perdue, pas de réponse... Alors arrête de chercher à faire croire que tu veux du débat technique : prouve le en participant au débat technique. Avec des arguments. -------------------- |

|

|

|

15 Mar 2015, 19:41 15 Mar 2015, 19:41

Message

#30

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 5 851 Inscrit : 8 Dec 2004 Lieu : Dans un coin perdu du 41 Membre no 28 453 |

Comme s'il allait s'abaisser à ça...

-------------------- Macbook 2006 C2D 2 GHz, 3 Go, Snow Leopard

Macbook Pro 15" 2010 i5 2,4 GHz, 4 Go, Mavericks (pour ma chérie) Nexus 4 sous Lollipop Samsung Galaxy S2 sous Gingerbread (pour ma chérie) Deux chats Le blog de ma chérie |

|

|

|

|

1 utilisateur(s) sur ce sujet (1 invité(s) et 0 utilisateur(s) anonyme(s))

0 membre(s) :

| Nous sommes le : 20th April 2024 - 06:51 |