Bienvenue invité ( Connexion | Inscription )

13 Nov 2014, 00:01 13 Nov 2014, 00:01

Message

#1

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 531 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

Anandtech a obtenu de nouvelles informations sur la partie graphique de la puce A8X dont est équipé l'iPad Air 2. Elle est encore bien plus aboutie que ne le laissaient penser les premières estimations.

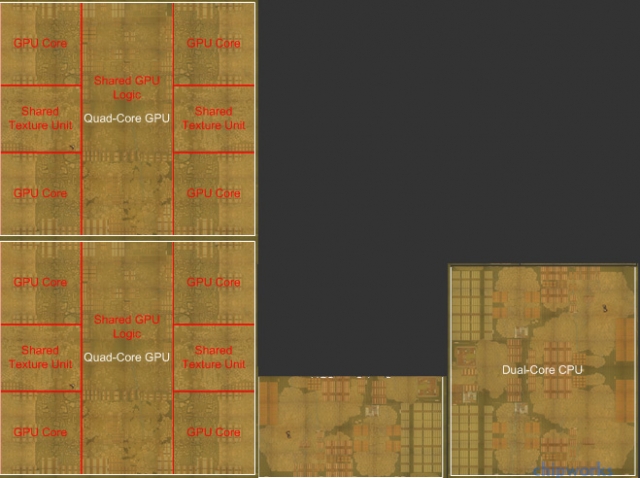

Dans les faits, ses performances sont deux fois supérieures à celles de l'A8. Pour arriver à ça, Apple n'a pas lésiné sur le nombre de transistors et a installé pas moins de 8 cœurs graphiques séparés en deux unités de quatre partageant mémoire vidéo et unités de calcul annexes. Voici une représentation (ce n'est pas une image réelle) de cet ensemble.  Si l'on rajoute à ça les 2 Go de RAM sur un bus 128 bits (contre 64 bits pour les autres appareils iOS), on comprend mieux les résultats bluffants obtenus par l'A8X par rapport à tout ce qui existe ou presque. On peut aussi se rendre compte du potentiel de ces puces Ax chez Apple et les raisons pour lesquelles la société songe à en doter des ordinateurs dans le futur. Lien vers le billet original -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

Les messages de ce sujet

Lionel Apple a tout particulièrement soigné la partie graphique de l'A8X 13 Nov 2014, 00:01

Lionel Apple a tout particulièrement soigné la partie graphique de l'A8X 13 Nov 2014, 00:01

r@net54 Ce qui est le plus impressionnant c'est qu... 13 Nov 2014, 00:36

r@net54 Ce qui est le plus impressionnant c'est qu... 13 Nov 2014, 00:36

iAPX Bah j'avais déja écrit que c'étais bien... 13 Nov 2014, 02:44

iAPX Bah j'avais déja écrit que c'étais bien... 13 Nov 2014, 02:44

AlbertRaccoon Citation (iAPX @ 13 Nov 2014, 02:44) mais... 13 Nov 2014, 07:54

AlbertRaccoon Citation (iAPX @ 13 Nov 2014, 02:44) mais... 13 Nov 2014, 07:54

yponomeute Citation (AlbertRaccoon @ 13 Nov 2014, 07... 13 Nov 2014, 12:58

yponomeute Citation (AlbertRaccoon @ 13 Nov 2014, 07... 13 Nov 2014, 12:58

xpech Citation (iAPX @ 13 Nov 2014, 02:44) Bah ... 13 Nov 2014, 09:14

xpech Citation (iAPX @ 13 Nov 2014, 02:44) Bah ... 13 Nov 2014, 09:14

morane_j Citation (iAPX @ 13 Nov 2014, 02:44) Bah ... 13 Nov 2014, 09:47

morane_j Citation (iAPX @ 13 Nov 2014, 02:44) Bah ... 13 Nov 2014, 09:47

jcollot Citation (morane_j @ 13 Nov 2014, 10:47) ... 13 Nov 2014, 13:58

jcollot Citation (morane_j @ 13 Nov 2014, 10:47) ... 13 Nov 2014, 13:58

morane_j Citation (jcollot @ 13 Nov 2014, 13:58) C... 13 Nov 2014, 14:25

morane_j Citation (jcollot @ 13 Nov 2014, 13:58) C... 13 Nov 2014, 14:25

superayate Citation (iAPX @ 13 Nov 2014, 03:44) Bah ... 13 Nov 2014, 10:13

superayate Citation (iAPX @ 13 Nov 2014, 03:44) Bah ... 13 Nov 2014, 10:13

Lionel Passer du X86 à l'ARM est avant tout une déc... 13 Nov 2014, 07:15

Lionel Passer du X86 à l'ARM est avant tout une déc... 13 Nov 2014, 07:15

jeannot Citation (Lionel @ 13 Nov 2014, 08:15) Pa... 13 Nov 2014, 08:13

jeannot Citation (Lionel @ 13 Nov 2014, 08:15) Pa... 13 Nov 2014, 08:13

Mac Moins Je me permets de reposer une vieille question rest... 13 Nov 2014, 08:42

Mac Moins Je me permets de reposer une vieille question rest... 13 Nov 2014, 08:42

JoKerforever Citation (Mac Moins @ 13 Nov 2014, 09:42)... 13 Nov 2014, 09:01

JoKerforever Citation (Mac Moins @ 13 Nov 2014, 09:42)... 13 Nov 2014, 09:01

AlbertRaccoon Citation (JoKerforever @ 13 Nov 2014, 09... 13 Nov 2014, 09:05

AlbertRaccoon Citation (JoKerforever @ 13 Nov 2014, 09... 13 Nov 2014, 09:05

JoKerforever Citation (AlbertRaccoon @ 13 Nov 2014, 10... 13 Nov 2014, 09:24

JoKerforever Citation (AlbertRaccoon @ 13 Nov 2014, 10... 13 Nov 2014, 09:24

SartMatt Citation (jeannot @ 13 Nov 2014, 08:13) Q... 13 Nov 2014, 09:50

SartMatt Citation (jeannot @ 13 Nov 2014, 08:13) Q... 13 Nov 2014, 09:50

JoKerforever Citation (SartMatt @ 13 Nov 2014, 10:50) ... 13 Nov 2014, 10:11

JoKerforever Citation (SartMatt @ 13 Nov 2014, 10:50) ... 13 Nov 2014, 10:11

nicogala Citation (SartMatt @ 13 Nov 2014, 09:50) ... 13 Nov 2014, 12:30

nicogala Citation (SartMatt @ 13 Nov 2014, 09:50) ... 13 Nov 2014, 12:30

iaka Citation (JoKerforever @ 13 Nov 2014, 10... 13 Nov 2014, 09:15

iaka Citation (JoKerforever @ 13 Nov 2014, 10... 13 Nov 2014, 09:15

AlbertRaccoon Citation (iaka @ 13 Nov 2014, 09:15) Pour... 13 Nov 2014, 09:25

AlbertRaccoon Citation (iaka @ 13 Nov 2014, 09:15) Pour... 13 Nov 2014, 09:25

JoKerforever Citation (AlbertRaccoon @ 13 Nov 2014, 10... 13 Nov 2014, 09:53

JoKerforever Citation (AlbertRaccoon @ 13 Nov 2014, 10... 13 Nov 2014, 09:53

xpech Citation (JoKerforever @ 13 Nov 2014, 09... 13 Nov 2014, 09:24

xpech Citation (JoKerforever @ 13 Nov 2014, 09... 13 Nov 2014, 09:24

Mac Moins Citation (JoKerforever @ 13 Nov 2014, 10... 14 Nov 2014, 11:37

Mac Moins Citation (JoKerforever @ 13 Nov 2014, 10... 14 Nov 2014, 11:37

Ambroise Citation (jeannot @ 13 Nov 2014, 08:13) C... 13 Nov 2014, 19:18

Ambroise Citation (jeannot @ 13 Nov 2014, 08:13) C... 13 Nov 2014, 19:18

x arena C'est a se demander si les iMac 5K ne tournera... 13 Nov 2014, 08:06

x arena C'est a se demander si les iMac 5K ne tournera... 13 Nov 2014, 08:06

GStepper Comme d'autres le rappellent ici, la comparais... 13 Nov 2014, 10:01

GStepper Comme d'autres le rappellent ici, la comparais... 13 Nov 2014, 10:01

El Bacho Citation (GStepper @ 13 Nov 2014, 10:01) ... 13 Nov 2014, 14:40

El Bacho Citation (GStepper @ 13 Nov 2014, 10:01) ... 13 Nov 2014, 14:40

Le vendangeur Masqué Citation (Lionel @ 13 Nov 2014, 08:15) Pa... 13 Nov 2014, 11:31

Le vendangeur Masqué Citation (Lionel @ 13 Nov 2014, 08:15) Pa... 13 Nov 2014, 11:31

JoKerforever Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 13:07

JoKerforever Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 13:07

SartMatt Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 13:58

SartMatt Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 13:58

JoKerforever Citation (SartMatt @ 13 Nov 2014, 14:58) ... 13 Nov 2014, 15:08

JoKerforever Citation (SartMatt @ 13 Nov 2014, 14:58) ... 13 Nov 2014, 15:08

SartMatt Citation (JoKerforever @ 13 Nov 2014, 15... 13 Nov 2014, 15:42

SartMatt Citation (JoKerforever @ 13 Nov 2014, 15... 13 Nov 2014, 15:42

Lionel Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 15:24

Lionel Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 15:24

scoch Citation (Lionel @ 13 Nov 2014, 15:24) Ci... 13 Nov 2014, 18:27

scoch Citation (Lionel @ 13 Nov 2014, 15:24) Ci... 13 Nov 2014, 18:27

macinoe Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 16:14

macinoe Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 16:14

r@net54 Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 19:02

r@net54 Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 19:02

SartMatt Citation (r@net54 @ 13 Nov 2014, 19:02) I... 13 Nov 2014, 19:26

SartMatt Citation (r@net54 @ 13 Nov 2014, 19:02) I... 13 Nov 2014, 19:26

r@net54 Citation (SartMatt @ 13 Nov 2014, 20:26) ... 14 Nov 2014, 16:50

r@net54 Citation (SartMatt @ 13 Nov 2014, 20:26) ... 14 Nov 2014, 16:50

AlbertRaccoon Citation (r@net54 @ 14 Nov 2014, 16:50) S... 14 Nov 2014, 17:16

AlbertRaccoon Citation (r@net54 @ 14 Nov 2014, 16:50) S... 14 Nov 2014, 17:16

SartMatt Citation (r@net54 @ 14 Nov 2014, 16:50) C... 14 Nov 2014, 17:47

SartMatt Citation (r@net54 @ 14 Nov 2014, 16:50) C... 14 Nov 2014, 17:47

scoch Citation (r@net54 @ 13 Nov 2014, 19:02) Q... 14 Nov 2014, 19:33

scoch Citation (r@net54 @ 13 Nov 2014, 19:02) Q... 14 Nov 2014, 19:33

superayate C'est du standard, Apple n'a fait "qu... 13 Nov 2014, 15:15

superayate C'est du standard, Apple n'a fait "qu... 13 Nov 2014, 15:15

El Bacho Ça arrangeait Adobe et Microsoft que Mac OS X tou... 13 Nov 2014, 15:33

El Bacho Ça arrangeait Adobe et Microsoft que Mac OS X tou... 13 Nov 2014, 15:33

superayate Le floorplan de l'A8X est assez surprenant par... 13 Nov 2014, 15:57

superayate Le floorplan de l'A8X est assez surprenant par... 13 Nov 2014, 15:57  |

1 utilisateur(s) sur ce sujet (1 invité(s) et 0 utilisateur(s) anonyme(s))

0 membre(s) :

| Nous sommes le : 17th September 2025 - 07:43 |