Version imprimable du sujet

Cliquez ici pour voir ce sujet dans son format original

Forums MacBidouille _ Macbidouille Articles & News : Vos Réactions _ Des benchs du Galaxy S6

Écrit par : Lionel 2 Mar 2015, 23:57

http://www.tomshardware.fr/articles/galaxy-s6-tests,1-55637.html a publié des benchs du Galaxy S6 Edge.

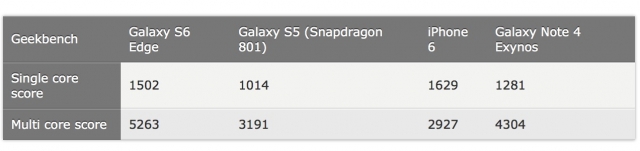

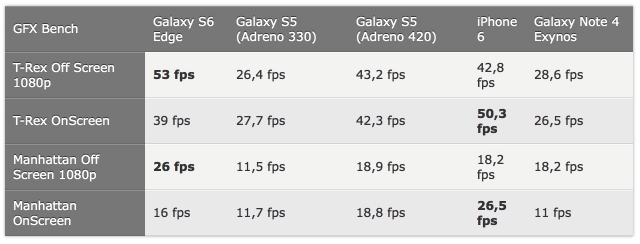

Comme vous pouvez le voir si les coeurs d'Apple sont meilleurs, le portable de Samsung profite de leur quantité supérieure, 8, pour faire parler la poudre. En revanche au niveau graphique tout dépend des tests. Dans certains le S6 est très supérieur, dans d'autres l'iPhone domine.

Passé ces tests, nous vous rappelons qu'avoir une puissance considérable dans un mobile n'a de réel intérêt que s'il y a des logiciels capables de l'exploiter. Et l'on retombe ici dans le débat sans fin de l'intérêt de continuer à faire jouer la poudre dans un domaine où les évolutions logicielles sont lentes et où les éditeurs de jeux ne cherchent jamais à tirer le maximum de puissance du dernier produit mais à vendre des logiciels à un maximum de clients, donc en mettant la barre nettement moins haute.

http://www.macbidouille.com/news/2015/03/03/des-benchs-du-galaxy-s6

Écrit par : SartMatt 3 Mar 2015, 00:25

Du coup en "Off Screen" le GS6 l'emporte assez largement, ce qui démontre que son GPU est nettement plus puissant, tandis qu'en "On Screen" l'iPhone 6 l'emporte tout simplement parce que son GPU a grosso modo 3.7 fois moins de pixels à calculer... Une comparaison avec l'iPhone 6 Plus donnerait du coup des résultats beaucoup plus serrés en "On Screen" (il ferait à peu de choses près les mêmes scores qu'en "Off Screen").

Écrit par : iAPX 3 Mar 2015, 02:16

Pour résumer de manière plus concrète: performant en théorie, mais inutilisable pour jouer dans la pratique, tout du moins de manière comparable à un iPhone 6, voir un 6 Plus.

Un peu similaire pour la CPU: rapide en théorie pour des Apps natives multithreadées, et très lent pour des Apps Java (non-native) et non-multithreadé, ce qui est la grande majorité des Apps Android aujourd'hui.

Écrit par : r@net54 3 Mar 2015, 02:50

Intéressant sur plusieurs points:

- en monocore un A8 a 20nm est plus efficace qu'un Exynos en 14nm. La gravure ne vaut pas le travail sur l'architecture et il y a donc de la marge de progression importante sur le 20nm...

- en multicore en rapport, l'A8 est plus efficace aussi. Ce n'est pas mentionne dans le test mais le resultat doit porter sur le multicore big, donc les 4 core les plus rapides (il serait ettonant d'arriver a un score aussi bas avec 8 cores)

A noter tout de meme que le Galaxy S6 est 65% plus performant que le S4 en CPU.

Au niveau graphique le GPU ARM Mali T760 semble effectivement un peu meilleur que le PowerVR GX6450 qui equipe l'A8, ce qui n'est pas une surprise. Il va falloir attendre qu'Apple ait aquis la maitrise technique suffisante pour produire ses propre GPU, mais pour l'instant ARM domine, hormis le trop rare Tegra k1 ou x1.

Le plus interressant reste la consommation.

Sur le meme test la baisse de performance liee a la surchauffe du processeur n'est que de 4% au pire et en multicore. Rappelons que les performances d'un processeur sont lies a sa frequence et donc s'il chauffe trop il ralentit la frequence pour ne pas depasser la temperature critique. Ici on voit clairement que malgre le peu d'espace et l’absence de refroidissement actif (ventilateur), meme poussé dans ses retranchements le SoC contient sa production thermique (et on doit etre a 2.1 Ghz sur 4 core)...

C'est effectivement vrai et cela l'est d'autant plus que la on est sur des évaluations faites avec un logiciel specifique au bench, qui donc n'a pas vraiment de sens pour une exploitation reelle. Certes depuis la decouverte les annees precedente des optimisations specifiques des CPU et GPU pour tricher dans les bench, aujourd'hui on peut penser que ces resultats sont plus fiables, mais ils restent neanmoins artificiels.

Par contre ce qui est intéressant c'est de voir l'evolution de la puissance, du maintien (voir de la reduction) de la consommation et de l'augmentation des performances graphiques, cela dans l'objectif d'une utilisation prochaine dans des PC. Car sur un PC des logiciels exploitants la puissance du processeur et du GPU il n'y a que ca.

Je reprends l'element du throttling qui on le voit sur un appareil de ce type pourrait etre un cauchemar. Mais il en est rien, et meme a pleine charge soutenue sur les 4 core la temperature ne monte pas! Cela veut dire que demain, Samsung ou Apple peuvent faire des vrais 8 core a plus de 2ghz qui tiendront dans un ultrabook sans ventilation et avec une autonomie dépassant la journée.

Il reste maintenant a attendre NVidia avec sa revision maison du X1 et l'A9 d'Apple...

Écrit par : zed_bill 3 Mar 2015, 06:53

Il faudra surtout attendre des benchs plus poussé avant de tirer des plans sur la comète comme tu le fais.

Écrit par : 406 3 Mar 2015, 07:38

Franchement, à ce niveau, le principale, c'est de ne pas avoir de latence à l'affichage. après, j'imagine mal des gens choisir leur tel portable selon les perfs aujourd'hui, pas comme hier.

Écrit par : Albook 3 Mar 2015, 07:42

Et quand est-il de la consommation ? Qui dit puissance supérieure, dit consommation plus importante , batterie plus volumineuse ou autonomie moindre .

Écrit par : flan 3 Mar 2015, 08:11

Je ne te comprends pas : pour moi ces benchs montrent bien qu'Intel est à la ramasse, qu'ils n'arriveront jamais à faire du 7nm, que l'ARM est prêt pour remplacer le x86 sur le desktop ou les serveurs, que l'ARM guérit le cancer et que de toute façon, bientôt nous serons tous dominés par l'ARM

Écrit par : SartMatt 3 Mar 2015, 09:14

Les performances dans ce cas arriveraient au dessus de celle de l'iPhone 6, avec une qualité d'image comparable.

Parce que justement, ce qui n'est pas comparable, c'est le 2560x1440 et le 1334x750...

Et par rapport à l'iPhone 6 Plus, le GS6 offrira en 2560x1440 des performances comparables à celles du 6 Plus en 1920x1080...

Elle peut éventuellement en avoir indirectement, si elle permet d'augmenter la fréquence, mais affiner la gravure ne permet pas forcément d'augmenter la fréquence.

Et c'est clairement pas avec Geekbench qu'on peut juger ça, ce bench est beaucoup trop court...

Sur mon Nexus 6, pour arriver à une baisse de performances liée à la surchauffe, il faut que je lance AnTuTu, et pas qu'une seule fois, ce n'est qu'au bout de 2-3 runs que je commence à avoir une baisse de performances, et c'est au bout de 5-6 de runs qu'elle atteint son maximum.

Exemple sur la dernière fois que j'ai essayé de vider la batterie :

* 20h37 : 39100

* 21h46 : 40800

* 21h50 : 34800

* 21h56 : 30800

* 22h01 : 24800

* 22h05 : 25300

* 22h10 : 25200

* 22h17 : 23900

* 22h23 : 21300

* 22h28 : 17400

Bref, au bout de près de 2h de test, les performances continuaient à baisser... Et ça aurait peut-être même encore continué à baisser si j'avais testé plus longtemps (forcément, vu que le but était de vider la batterie, je me suis arrêté une fois la batterie vide...).

Donc c'est pas un bench qui fait moins d'une minute de pleine charge qui va donner une information fiable à ce niveau.

Pour avoir ce genre d'infos, il faudra sans doute attendre que la presse dispose d'exemplaires en prêt pour faire des tests poussés. Les tests rapides sur un modèle d'expo dans un salon ne permettent pas d'aller aussi loin.

Écrit par : dtb06 3 Mar 2015, 09:45

Du coup en "Off Screen" le GS6 l'emporte assez largement, ce qui démontre que son GPU est nettement plus puissant, tandis qu'en "On Screen" l'iPhone 6 l'emporte tout simplement parce que son GPU a grosso modo 3.7 fois moins de pixels à calculer... Une comparaison avec l'iPhone 6 Plus donnerait du coup des résultats beaucoup plus serrés en "On Screen" (il ferait à peu de choses près les mêmes scores qu'en "Off Screen").

Exactement ce que je voulais dire. C'est juste que le nombre de pixels à traiter est plus grand à cause d'un écran plus défini.

D'un autre côté, je pense que dans peu de temps les performances pures ne seront plus un argument de vente. C'est ce qui s'est passé avec les ordinateurs, à part quelques niches et des joueurs exigeants, on ne choisit plus un ordinateur à cause de la fréquence de son processeur.

Écrit par : Heret 3 Mar 2015, 09:48

Du coup, iPhone ou Samsung pour être le premier à poster une connerie sur Facebook ou Twitter ?

Écrit par : Carbonized 3 Mar 2015, 10:47

Source ? J'ai pas vu le moindre test qui ai fait une mesure chiffrée de la baisse des performances liée à la surchauffe...

J'ai également vu l'article, je ne sais plus sur quel site, mais le processeur a été poussé à fond pendant plusieurs minutes, et il ne baissait que de quelques %.

EDIT : c'est sur tomshardware, en bas de l'article :

http://www.tomshardware.fr/articles/galaxy-s6-tests,1-55637.html

Il consomme apparemment 35% de moins que la génération précédent en 20nm. La DDR4 consomme également moins, ainsi que la mémoire flash, et la dalle AMOLED de l'écran (même s'il y a beaucoup plus de pixels).

Autre benchmark intéressant, c'est celui de la mémoire flash UFS 2.0. La vitesse en écriture était de 24Mo/s sur le Galaxy S5, elle est maintenant de 139Mo/s (314 en lecture) !

Écrit par : ypos 3 Mar 2015, 11:02

Du coup en "Off Screen" le GS6 l'emporte assez largement, ce qui démontre que son GPU est nettement plus puissant, tandis qu'en "On Screen" l'iPhone 6 l'emporte tout simplement parce que son GPU a grosso modo 3.7 fois moins de pixels à calculer... Une comparaison avec l'iPhone 6 Plus donnerait du coup des résultats beaucoup plus serrés en "On Screen" (il ferait à peu de choses près les mêmes scores qu'en "Off Screen").

Exactement ce que je voulais dire. C'est juste que le nombre de pixels à traiter est plus grand à cause d'un écran plus défini.

D'un autre côté, je pense que dans peu de temps les performances pures ne seront plus un argument de vente. C'est ce qui s'est passé avec les ordinateurs, à part quelques niches et des joueurs exigeants, on ne choisit plus un ordinateur à cause de la fréquence de son processeur.

Ça fait longtemps que les performances pures ne sont plus un argument de vente, sauf pour les geeks peut-être qui reste une part marginale de la cible.

Cela démontre une fois de plus que des écrans si petits avec une résolution si élevée ne présente aucun intérêt si ce n'est accumuler les inconvénients (plus gourmand, plus lent). Je ne comprends pas que certains constructeurs persistent dans cette voie.

Écrit par : SartMatt 3 Mar 2015, 11:15

EDIT : c'est sur tomshardware, en bas de l'article :

http://www.tomshardware.fr/articles/galaxy-s6-tests,1-55637.html

Et 4% sur Geekbench, ce n'est pas une variation significative vue la variabilité des résultats (quand on fait une cinquantaine de tests en à peine plus de 30s sur un OS multi-tâche avec des services en arrière-plan, forcément, il y a une grande variabilité...).

Tiens, 10 runs consécutifs sur mon Nexus 6 (avec un étui partiellement en caoutchouc, qui dégrade sans doute la dissipation...) :

* 1 : 758/2327

* 2 : 876/2678

* 3 : 950/2800

* 4 : 968/2986

* 5 : 939/3016

* 6 : 892/2741

* 7 : 998/3120

* 8 : 932/2876

* 9 : 917/2834

* 10 : 949/2829

Faudrait sans doute un bon nombre de runs supplémentaires pour voir pleinement l'effet du throttling, qui au bout d'1h30 d'AnTuTu n'a pas encore atteint son impact maximum...

Écrit par : r@net54 3 Mar 2015, 12:04

Si tu n'as que ca comme argument...

Je ne fais que constater des informations accessibles a tous et comparables. De plus ces résultats sont cohérents avec ce qui était attendu.

Par contre, il y a une chose qui reste dans l'inconnu c'est qu'il y a des rumeurs qui indiquent que Samsung pourrait -pour des difficultés de production - équiper les S6 de différents processeurs. Et la effectivement il faudra des bench spécifiques.

Autrement, comme je le dis, il va falloir tester la machine en conditions reelles avec une utilisation reelle, et pas avec des bench, pour voir au niveau experience d'utilisation ce que toute cette puissance et ces ameliorations ca apporte. Ce n'est pas la premiere fois que des performances en hausse sur le papier et dans les bench ne se convertissement pas en equivalence en utilisation.

Mais la tres bonne nouvelle, c'est qu'alors que la puissance augmente considérablement d'une génération a l'autre, la consommation baisse, et heureusement parce qu'avec la finesse actuelle des boitiers, pas la peine de faire tourner 10 heures la machine pour verifier si elle chauffe... 4 core a 2,1 ghz coincés dans 8mm y a pas de magie, soit la produciton thermique est contenue soit elle ne l'est pas. Si elle ne l'est pas, un core peut faire un pic d'au plus quelques secondes et apres faut attendre que l'energie se soit evacuée sinon on est dans le cauchemar throttling, et la on ne parle pas d'exploitation de la latence thermique sur quelques dixiemes de seconde.

Écrit par : gromeul 3 Mar 2015, 12:16

Du coup, iPhone ou Samsung pour être le premier à poster une connerie sur Facebook ou Twitter ?

Écrit par : ManiX 3 Mar 2015, 12:23

L'intérêt de la puissance au jour de la présentation de l'appareil est aussi de disposer de réserve pour les années à venir. Mon pauvre iPhone 4S était bien à la peine sous iOS8, et l'idée que le 6 et le 6+ sont des "bêtes" me rassure sur leur pérennité au gré des mises à jour.

Même si côté MàJ, il n'y a pas franchement de quoi s'inquiéter chez Samsung ! ![]()

Écrit par : gromeul 3 Mar 2015, 12:28

Même si côté MàJ, il n'y a pas franchement de quoi s'inquiéter chez Samsung !

Mon 4s ne peinait pas sous iOs8, pas plus que celui de mon épouse. Il semble d'ailleurs que la prochaine mise à jour ne soit pas source de ralentissement sur un 4S

Écrit par : r@net54 3 Mar 2015, 12:58

Elle peut éventuellement en avoir indirectement, si elle permet d'augmenter la fréquence, mais affiner la gravure ne permet pas forcément d'augmenter la fréquence.

Bon celle la je l'encadre et je la garde bien au chaud!

Heu tu sais que la conjecture de Moore sur laquelle repose tout le business x86 d'Intel depuis 1975 repose justement sur la diminution de la finesse de gravure, histoire de pouvoir augmenter le nombre de transistors (et donc augmenter la puissance de traitement): Moore postule un doublement du nombre a coût constant tous les 2 ans, doublement qui serait rendu possible par une gravure plus fine.

Quant a l'augmentation de la frequence comme consequence de la finesse de gravure, faut que tu m'explique? Les 4ghz c'est en 2005 avec une gravure au mieux de 90nm. Le FX 9590 lui atteint les 5ghz avec une gravure de 32nm mais au prix de 220W. Aujourd'hui on est a 22nm avec au mieux du 4ghz et pour le 14nm j'ai pas vu d'annonce allant au-dela de 4ghz et encore, on est plutot bien en dessous. Si la finesse de gravure avait un impact sur la frequence, pourquoi le 22nm ne serait pas - disons - a 16ghz?

Et pourquoi les fondeurs se tirent la bourre et dépensent de fortunes colossales pour gagner quelques nanomètres, alors que depuis le 20nm descendre en finesse ne fait qu'augmenter les effets quantiques, les désintégrations alpha, les courants de fuite, demande des processus toujours plus précis et des matériaux de qualité croissante,... et que tout ça a un coût croissant?

Écrit par : SartMatt 3 Mar 2015, 14:34

L'augmentation de la finesse permet l'augmentation de la complexité sur une même surface. Mais ce n'est pas l'augmentation de la finesse qui implique le gain de performances, le fait d'augmenter la finesse n'impliquant pas nécessairement de faire une nouvelle micro-architecture plus complexe et la micro-architecture plus complexe ne nécessite pas forcément une finesse plus grande... On le voit particulièrement bien chez Intel ces dernières années, puisque justement il alterne entre nouvelle micro-architecture avec une même finesse de gravure et nouvelle finesse de gravure avec une même micro-architecture très légèrement retouchée.

En l'occurrence, Samsung utilise une micro-architecture Cortex-A57/Cortex-A53 que d'autres utilisent en 20nm, il n'y aucune raison que cette finesse accrue lui donne un avantage direct de performances par rapport à ses concurrents en 20nm (forcément, par rapport à l'Exynos 5, c'est plus performant, mais grâce au passage d'A15/A7 à A57/A53, pas grâce au 14nm). Un Exynos 5 gravé en 14nm au lieu de 28nm aurait les performances d'un Exynos 5.

Je te croyais pourtant scientifique... Un scientifique devrait savoir que pour juger l'impact d'une variable, on le fait en ne touchant pas aux autres variables... Et jusqu'à preuve du contraire, la variable "finesse de gravure" n'a pas d'impact significatif sur les performances si tu ne touches pas à d'autres variables, comme "micro-architecture", "fréquence", etc... Elle n'est qu'un moyen de toucher aux autres variables sans faire flamber les variables "coût" et "consommation".

Dans certains cas limite elle peut éventuellement avoir un léger impact sur les performances, notamment quand une puce est exploitée à une fréquence trop proche de la limite de ses transistors et que ça provoque parfois des erreurs... Là un affinement peut permettre d'augmenter la fréquence limite et donc de réduire les erreurs. Mais même là, ce n'est pas vraiment un effet direct sur les performances, c'est plus un effet de bord.

L'accroissement de la finesse de gravure peut permettre d'augmenter la fréquence quand le facteur limitant de la montée en fréquence est la consommation électrique de la puce : la finesse accrue permet de réduire la consommation, et donc de remonter la fréquence à consommation égale. Une puce de la complexité des puces actuelles pourrait par exemple très bien être gravée en 300nm (pour peu qu'on soit prêt à y mettre le prix, puisqu'on parle d'une puce plusieurs centaines de fois plus grande), mais ne pourrait alors pas tourner aux mêmes fréquences, preuve que la finesse de gravure actuelle joue bien un rôle dans la fréquence maximale admissible par les puces.

Dans d'autres cas, c'est la micro-architecture ou d'autres contraintes qui limitent, et effectivement dans ce cas affiner la gravure n'apportera pas de gain en fréquence.

Jusqu'au début des années 2000, c'était plutôt le premier cas qui dominait, et la montée en fréquence se faisait au fil de l'affinement de la gravure. Depuis, c'est le second cas qui domine, et les gains de performances se font quasi uniquement sur l'amélioration des micro-architectures, la finesse de gravure étant là pour contenir la consommation et réduire les coûts.

Mais ce qui fait les gains de performances, ce n'est PAS la finesse de gravure, c'est la micro-architecture. L'Exynos 7 est plus performant que l'Exynos 5 parce que c'est du A57/A53 au lieu du A15/A7. Il ne sera par contre pas plus performant qu'un autre A57/A53, même gravé en 20nm. Par contre, il sera moins cher à produire et consommera généralement moins d'énergie à fréquence égale.

Écrit par : SartMatt 3 Mar 2015, 14:55

Cela dit, ce n'est pas forcément un défaut, si l'inertie thermique permet de maintenir les performances maximales pendant plus longtemps, ça limite forcément le risque que le throtelling ait un impact en usage courant, où on est rarement à pleine charge pendant des périodes très longues, car de toute façon en pleine charge la batterie ne tiendrait vraiment pas longtemps, de l'ordre de deux grosses heures par exemple avec un Nexus 6, et avec bon nombre de chargeurs la puissance fournie ne serait pas suffisante pour éviter la panne sèche (toujours sur mon Nexus 6, si je fais tourner BOINC en étant sur un chargeur 5W la batterie se vide... et encore pire sur un port USB, il faut 3-4 fois plus de temps pour prendre 1% de batterie que pour en perdre 1 quand BOINC tourne...).

Écrit par : kwak-kwak 3 Mar 2015, 16:33

Oui, mais a force de rajouter de la complexité à ton architecture RISC, il va arriver un point où faute de savoir quoi rajouter tu vas finir par te dire: "Tien, et si on rajoutait un jeu d'instruction x86 !"... Et la tu finis par pourrave tout ce qui se fait sur le marché dans les bench single-core

Écrit par : SartMatt 3 Mar 2015, 16:44

Mais non, pour l'instant ils savent quoi rajouter, ils mettent plein de cœurs... C'est pratique, ça permet de multiplier les performances en crête dans les benchs, sans pénaliser l'autonomie en utilisation "normale" (grâce à la désactivation des cœurs inactifs). Mediatek vient de présenter un SoC octo-cœur pour le milieu de gamme... Et c'est pas du 4+4 en big.LITTLE, c'est bien du 8 cœurs symétrique, avec uniquement des cœurs Cortex-A53...

Si ce n'est pas déjà le cas, la majorité des gens auront bientôt plus de cœurs dans leur smartphone que dans leur ordinateur

Écrit par : os2 3 Mar 2015, 18:54

Un peu similaire pour la CPU: rapide en théorie pour des Apps natives multithreadées, et très lent pour des Apps Java (non-native) et non-multithreadé, ce qui est la grande majorité des Apps Android aujourd'hui.

tu sais qu'il y a plus qu'une application qui tourne en même temps?

Écrit par : Dreaming 3 Mar 2015, 19:37

Surtout dans Android... ![]()

Écrit par : DefKing 4 Mar 2015, 18:19

Je ne te comprends pas : pour moi ces benchs montrent bien qu'Intel est à la ramasse, qu'ils n'arriveront jamais à faire du 7nm, que l'ARM est prêt pour remplacer le x86 sur le desktop ou les serveurs, que l'ARM guérit le cancer et que de toute façon, bientôt nous serons tous dominés par l'ARM

A moins de passer l'ARM à gauche ?

Propulsé par Invision Power Board (http://www.invisionboard.com)

© Invision Power Services (http://www.invisionpower.com)