Bienvenue invité ( Connexion | Inscription )

|

13 Nov 2014, 10:13 13 Nov 2014, 10:13

Message

#21

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 237 Inscrit : 10 Feb 2004 Lieu : Toulouse Membre no 14 613 |

Bah j'avais déja écrit que c'étais bien plus performant qu'un Core2 Duo pour l'A8 (sans parler de la GPU comparé à un GMA quelconque), mais apparemment certains, qui se reconnaitront, pensent que c'est du bullshit, que geekbench n'a pas de valeur (sous prétexte que comme chaque bench il ne représente que certains scénarios, ce qui est vrai). Mais je pense que l'A8 et l'A8X sont incroyables et qu'en quelques années à fait bien plus en matière d'architecture CPU qu'AMD dans la même période, et surtout que l'architecture Cyclone d'Apple est maintenant meilleure en terme de performances/cycle qu'Haswell et Broadwell d'Intel (qu'on aura sur nos Mac en 2015). Ce qui est incroyable pour une architecture orienté économie d'énergie et non performance, surtout pour un acteur inconnu dans ce domaine! Pour donner une idée, nVidia qui fait des ARM depuis bien plus longtemps, est plus lent à 2.2Ghz que l'A8X à 1.5Ghz, les deux en 64bit. Ça donne une idée du retard à combler, qui est déja de 3-5ans pour nVidia par rapport à Apple! Bon la il faut avouer que tu racontes un peu n'importe quoi... Geekbench, comme tous les benchmarks universelles, ca vaut pas vraiment grand chose... Si on se fie seulement aux benchmarks, on pourrait par exemple en deduire via les resultats sous 3Dmark de futuremark qu'un A6 est un peu plus rapide qu'un A7 par exemple (resultats en physics qui test les perfo CPU) alors que sous geekbench l'A7 offre un score 2 fois plus eleve que l'A6... Mefiance avec les benchs... Autant l'A8 (et l'A8X) sont de tres bons CPU mobiles, autant ils n'ont rien de particulierement revolutionnaire. Qu'est ce que l'A8X au final? Un A8 sous steroides qui est lui meme qu'une simple iteration de l'A7. Autant l'A7 a secoue un peu le cocottier, autant l'A8 on ne peut pas en dire autant. Enfin, quand au dernier paragraphe, la c'est completement a la masse comme affirmation... Oui l'A8X est plus rapide que le K1 64 bits, non nvidia n'est pas en retard. En l'etat actuel, son K1 est au meme niveau question GPU que l'A8X (et bien plus rapide dans certains cas), et sa partie CPU en monocore est du meme accabit, les performances plus elevees etant du a l'integration de 3 coeurs contre 2 sur le K1 (et encore, sous certains benchs le k1 s'avere aussi rapide que l'A8X). Alors oui l'A8X est la reference en terme de SOC mobile, mais le K1 en est bien plus proche, et nvidia a au contraire ete en avance sur apple qui ne lui est repasse devant qu'avec la sortie de l'Ipad Air 2. Et ne pas oublie une chose, l'A8X est grave en 20nm contre 28nm pour le K1 -------------------- 2015: Macbook pro 13,3' early 2011 (i5 2410M) + Config fixe Gamer + Huawei mate 7 + Ipad Air 32Go + Cowon S9

2004 = > DD externe 120Go + graveur DVD dual 8x firewire |

|

|

|

13 Nov 2014, 11:31 13 Nov 2014, 11:31

Message

#22

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 338 Inscrit : 24 Feb 2003 Membre no 6 379 |

Passer du X86 à l'ARM est avant tout une décision idéologique et politique. Le problème n'est plus tant de pouvoir proposer des applications véloces sur des processeurs ayant 3 milliards de transistors comme l'A8X mais de faire que tous les grands suivent Apple. Quels grands ? Ceux du logiciel style MS ou Adobe ? MS en ce moment à l'air de se remuer un peu (mieux vaut tard…), donc supporter l'ARM n'aurait rien d'insurmontable pour eux. Adobe par contre est encore empêtré dans des logiciels assez archaïques et dépassés, et là ça va prendre un peu plus de temps. Mais on se souviendra qu'Adobe n'a pas eu trop le choix que de passer à OS X et aux procs Intel alors qu'à l'époque la part de marché du Mac était bien inférieure à celle d'aujourd'hui. Et Apple n'avait clairement pas le même poids ! Donc lentement peut-être, mais ça se ferait. Quand aux autres développeurs, une éventuelle transition ça se résumera à 95% du temps à cocher une case dans Xcode. Exactement comme le passage à Intel ou au 64 bits. Le problème est là et Intel fera tout pour que ce n'arrive pas. Rappelez vous juste ce qu'Intel a réussi à faire pour bloquer AMD. On est pas du tout dans la même situation ! Déjà tu commets l'erreur, et c'est pas la première fois, même récemment, de voir Apple comme faible et à la merci du premier venu. Alors qu'Intel est franchement petit à côté. Apple pourrait presque les racheter ! Tu te trompes d'époque, là le géant c'est la Pomme. Les autres ils sont tous en dessous, voir même très en dessous. Ensuite ce qu'Intel à fait par le passé ce sont des pressions sur les constructeurs de PC et des benchs foireux pour les médias… C'est bien ça mais Apple s'en fout ! La Pomme si transition il y avait mettrait ses puces dans ses machines, et l'entreprise est très bonne en com' donc Intel pourrait raconter ce qu'il veut aux médias que ça ne changerait rien. Donc à mon avis rien n'empêcherais que ça puisse se faire. Excepté si l'opération n'offre pas une plus value suffisante. N'oublions pas que si transition vers Intel il y a eu c'était parce que les PC rattrapaient dangereusement les Mac PPC. Mais là encore la situation actuelle est fort différente, car si Intel faiblit, tous les constructeurs en subissent à égalité les conséquence. Un Mac ne sera donc quoi qu'il arrive ni meilleur ni plus mauvais en perfs qu'un PC qu'Intel ai ou non fait des progrès. Pour l'instant Apple peut donc parfaitement se contenter du puces Intel, y'a pas de concurrence. Mais par contre d'ici un certain temps et si Intel progresse peu, elle pourrait jouer son vatout en passant sur ARM, et avoir là un gros avantage sur les fabricants de PC. Ça c'est pour le CPU, mais si j'en reviens à l'article on y parle de GPU, et je me dit qu'il y a une chose qui pourrait se faire beaucoup plus rapidement et avec probablement peu de problèmes de compatibilité qui serait de greffer sur nos Mac un GPU dérivé de celui de l'impressionnant A8x (sur une puce graphique on peut multiplier les coeurs à l'envie cela s'optimise fort bien). Après tout aujourd'hui on de très bonnes cartes chez AMD, mais il est par exemple inenvisageable de mettre une 295X même en version mobile dans un MacBook [air] ! Trop gros, trop chaud, trop consommateur ! Et si les GPU intégrés d'Intel ont heureusement fait des progrès au fil des années et ne consomment pas grand chose, la puissance n'est pas tellement là. Avec un GPU made in Apple on pourrait avoir les deux: performances et économie d'énergie. Et ça serait le paradis pour les devs: on pourrait avoir l'API Metal que ça soit iOS ou OS X ! Enorme avantage… Voilà une deuxième carte à jouer pour Apple. Apple est fort, mais Apple ne serait rien sans ARM. Si ARM n'avait pas sorti des architectures aussi poussées, Apple n'arriverait pas à faire tout ça. S'il te plaît arrête de minimiser le travail d'Apple. ARM n'est qu'une base architecturale, et n'importe quel site spécialisé (Anandtech ou autre) a déjà depuis fort longtemps démontré que la Pomme avait pas mal amélioré ce CPU. Sinon comme tu expliques qu'un A8 tienne tête voir dépasse des concurrents avec 4 voir 8 coeurs et je ne sais combien de plus de MHz ? Le rendement des puces d'Apple est sans commune mesure ! C'est vraiment ARM qui dépote, et qui va mettre une énorme claque à Intel, et ça c'est bon. On va peut-être enfin se débarasser de la vieillissante architecture x86 Faut dire aussi que ce sont des produits qui à la base n'ont pas du tout été conçus pour les mêmes usages et ne sont pas nés en même temps, loin de là. Et quand je vois les dernières puces mobiles d'Intel j'ai l'impression qu'ils ont parfaitement compris la situation. C'est pas du tout un débat pro/anti Intel. On discute là juste de ce qui est opportun de faire. Crois-bien en tout qu'Apple ne prendra pas de décision à la légère et sûrement pas par fanatisme comme laisse par contre transparaître ton commentaire. |

|

|

|

13 Nov 2014, 12:30 13 Nov 2014, 12:30

Message

#23

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 422 Inscrit : 3 Dec 2003 Membre no 12 193 |

Et il faut garder à l'esprit que faire monter le niveau de performances des puces ARM au niveau des puces x86 équipant les Mac actuellement, ça ne se fera pas sans sacrifier le ratio performances/W : on optimise une puce pour les performances ou pour la consommation, pas pour les deux à la fois. Ça c'est si tu parts du principe que les deux types de processeur ont le même "rendement", or le progrès c'est justement d'augmenter le rendement : le proc d'une société X peut être à la fois plus performant et plus économe que celui d'une société Y qui a un moins bon rendement. |

|

|

|

13 Nov 2014, 12:58 13 Nov 2014, 12:58

Message

#24

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 4 969 Inscrit : 26 Jan 2011 Lieu : Pollachius virens Membre no 164 083 |

mais apparemment certains, qui se reconnaitront, pensent que c'est du bullshit, que geekbench n'a pas de valeur (sous prétexte que comme chaque bench il ne représente que certains scénarios, ce qui est vrai). Ça vient surtout du fait que Geekbench n'utilise pas les optimisations de toutes les plateformes, ce qui rend les comparaisons cross-plateform particulièrement hasardeuses. Par exemple, comparer des résultats sous ARM avec NEON et sous x86 avec x87, ça n'a pas vraiment de sens. Ça revient à comparer la vitesse de deux voitures dont l'une est limitée au premier rapport de sa boîte de vitesse. Et oui, une FIAT Panda en 4ème est plus rapide qu'une Audi en 1ère. Il y a une boite de vitesses sur les Fiat Panda ? --> [] -------------------- MBP 2017 15" avec clavier pourri et touchbar inutile

|

|

|

|

13 Nov 2014, 13:07 13 Nov 2014, 13:07

Message

#25

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 117 Inscrit : 4 Oct 2010 Membre no 159 713 |

Mais on se souviendra qu'Adobe n'a pas eu trop le choix que de passer à OS X et aux procs Intel alors qu'à l'époque la part de marché du Mac était bien inférieure à celle d'aujourd'hui. Et Apple n'avait clairement pas le même poids ! Donc lentement peut-être, mais ça se ferait. Je ne partage pas tes certitudes. Apple a peut-être gagné des parts de marcher sur les ordinateurs, mais en a grandement perdu dans les domaines couvert par Adobe. Je pense que si Adobe annonçait demain que d'ici 3 ans il n'y aurait plus de nouvelles versions de leur suite pour Mac, les utilisateurs lâcheraient le Mac mais garderaient Adobe. Un passage sur ARM des Mac ferait sûrement réfléchir Adobe à deux fois avant de tenter l'expérience. Comme tu dis, au passage sur intel Adobe n'a pas eu le choix. Dans l'état actuel des choses je pense qu'Adobe peut faire sans le Mac (et imposer une migration sur Windows à tous ses utilisateurs). |

|

|

|

13 Nov 2014, 13:58 13 Nov 2014, 13:58

Message

#26

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 53 Inscrit : 25 Aug 2005 Membre no 44 514 |

Apple est fort, mais Apple ne serait rien sans ARM. Si ARM n'avait pas sorti des architectures aussi poussées, Apple n'arriverait pas à faire tout ça. C'est vraiment ARM qui dépote, et qui va mettre une énorme claque à Intel, et ça c'est bon. On va peut-être enfin se débarasser de la vieillissante architecture x86 Il te manque un petit bout d'histore. ARM, la société que tu cites comme étant la seule origine du succès d'Apple, a été fondée comme joint venture entre Apple et Acorn en 1990... L'expertise d'Apple remonte un peu plus loin que tu ne le crois |

|

|

|

13 Nov 2014, 13:58 13 Nov 2014, 13:58

Message

#27

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Après tout aujourd'hui on de très bonnes cartes chez AMD, mais il est par exemple inenvisageable de mettre une 295X même en version mobile dans un MacBook [air] ! Trop gros, trop chaud, trop consommateur ! Et si les GPU intégrés d'Intel ont heureusement fait des progrès au fil des années et ne consomment pas grand chose, la puissance n'est pas tellement là. Enfin pour l'instant, dans les SoC Apple, il n'y a que le CPU qui soit Apple, le GPU ça reste du PowerVR standard, donc pas vraiment made in Apple.Avec un GPU made in Apple on pourrait avoir les deux: performances et économie d'énergie. Et ça serait le paradis pour les devs: on pourrait avoir l'API Metal que ça soit iOS ou OS X ! Enorme avantage… Voilà une deuxième carte à jouer pour Apple. Par contre, on pourrait effectivement envisager de voir un GPU de cette famille dans les Mac : revenir sur le marché PC avec les PowerVR, c'est justement dans les plans d'Imagination Technologies pour la série 7 (actuellement Apple utilise des série 6). Imagination promet jusqu'à 1.5 TFlops sur le plus gros PowerVR 7, ce qui le placerait en performances brutes au niveau d'une GeForce 770M ou 860M (mais pour l'instant Imagination se compare plutôt à la 730M, en disant que le gros PowerVR 7 sera au dessus). -------------------- |

|

|

|

13 Nov 2014, 14:25 13 Nov 2014, 14:25

Message

#28

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 207 Inscrit : 28 Sep 2012 Membre no 179 248 |

Apple est fort, mais Apple ne serait rien sans ARM. Si ARM n'avait pas sorti des architectures aussi poussées, Apple n'arriverait pas à faire tout ça. C'est vraiment ARM qui dépote, et qui va mettre une énorme claque à Intel, et ça c'est bon. On va peut-être enfin se débarasser de la vieillissante architecture x86 Il te manque un petit bout d'histore. ARM, la société que tu cites comme étant la seule origine du succès d'Apple, a été fondée comme joint venture entre Apple et Acorn en 1990... L'expertise d'Apple remonte un peu plus loin que tu ne le crois Je connais ça très bien, mais l'ARM de 1990 n'a plus rien à voir avec l'ARM de maintenant, et c'était surtout Acorn qui était leader (d'ailleurs ARM est une société britannique, tout comme Acorn) |

|

|

|

13 Nov 2014, 14:40 13 Nov 2014, 14:40

Message

#29

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 4 894 Inscrit : 24 Apr 2003 Lieu : Depuis chez lui Membre no 7 276 |

Comme d'autres le rappellent ici, la comparaison des CPUs sur des plateformes différentes est une entreprise délicate dont les résultats ne sont pas d'une fiabilité légendaire. Pour autant, au niveau design et efficience des SoC ARM, force est de constater qu'Apple a - en quelques années - acquis une solide expérience en la matière et semble se positionner aujourd'hui comme un acteur incontournable, voire un leader. J'avoue être impressionné par l'efficacité d'Apple sur ce point. C'est effectivement impressionnant d'en être arrivé là en partant de zéro ou presque (ils ont racheté Intrinsity et P.A. Semi, mais P.A. Semi ne travaillait absolument pas sur architecture ARM au moment du rachat). Le plus amusant étant que, comme Apple ne décrit pas dans le détail les technologies déployées dans les puces et se contente de les évoquer en termes très généralistes, les gens à tendance geek ont tendance à passer totalement à côté de l'"innovation" que ça représente pour concevoir ça, et qu'il faut tomber sur des dissections menées par des gens indépendants pour prendre la mesure du travail accompli. Le passage éventuel des Macs sur ARM ne peut se faire, comme Lionel le dit, que pour des raisons politiques, parce qu'il faut convaincre le public et les développeurs de faire le saut sur une nouvelle architecture si l'on veut que celle-ci se vende. Et, comme en politique, on va entendre pendant des années des rumeurs plus ou moins fiables d'un basculement imminent, jusqu'au jour où celui va s'opérer. Un peu comme Le Canard enchaîné parle constamment d'un remaniement ministériel. Un jour, celui-ci a forcément lieu et le journal se félicite de sa clairvoyance, en oubliant les trente fois où ils en avaient parlé sans que ça soit vérifié dans les faits. Déjà, il faudrait qu'Apple ait des processeurs ARM au niveau des puces Intel Core de bureau, ce qui est loin d'être un fait acquis, même s'il est déjà probable que des équipes planchent sur des déclinaisons des puces mobiles "rien qu'au cas où". Vu leur compétence et leur taille, ça serait idiot pour eux de ne pas réfléchir à cette question et de ne pas explorer cette voie. Ensuite, il faut surtout que le basculement sur architecture ARM leur rapporte quelque chose, notamment des ventes. Si c'est pour économiser du fric avec une solution interne par rapport à un processeur Intel, ça représente des clopinettes. Il faut surtout que ça leur rapporte des ventes supplémentaires. Pour la transition Power PC vers Intel, c'était un point acquis. Le G4 et le G5 se traînaient côté performances (ha, les comparatifs à l'avantage du G4 sur un filtre Photoshop bien précis lors des keynotes, et le RDF qui jouait à plein), Intel permettait à Apple de revenir au niveau, de bénéficier d'une compatibilité optionnelle avec Windows, et de récupérer des compilateurs GCC autrement mieux optimisés que ceux pour Power PC. À part pour les applications pas encore portées en x86, il n'y a eu très vite aucune raison de rester sur une machine Power PC par rapport aux Macs Intel. Le basculement sur ARM n'aurait pas le même effet, déjà parce que les gens n'éprouvent pas de mécontentement particulier envers Intel et ne trouvent pas leurs machines particulièrement lentes. Le jour où ils auront l'impression qu'elles font du surplace côté performances depuis des années, ça peut changer, mais on n'y est pas encore. Les MacBook Pro et Air actuels tiennent toute une journée sans recharge, donc un processeur avec un meilleur rendement ne serait pas déterminant. Il faudrait qu'il y ait un gros écart de performances, et qu'une puce non Intel écrase la concurrence en permettant des débouchés encore inimaginables aujourd'hui. Là, oui, les gens pourraient être tentés de prendre un Mac à processeur ARM s'il permet des trucs hors de la portée d'un PC sous Windows/x86. Et ça n'est probablement pas l'année prochaine qu'on y arrivera. -------------------- « Ayez confiance, je sais ce que je fais. »

|

|

|

|

13 Nov 2014, 15:08 13 Nov 2014, 15:08

Message

#30

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 117 Inscrit : 4 Oct 2010 Membre no 159 713 |

|

|

|

|

13 Nov 2014, 15:15 13 Nov 2014, 15:15

Message

#31

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 237 Inscrit : 10 Feb 2004 Lieu : Toulouse Membre no 14 613 |

C'est du standard, Apple n'a fait "que" mettre deux fois le meme ensemble de 4 unites pour doubler la puissance.

ps: quand je dis standard c'est dans le sens que les unites utilisees sont standardisees contrairement aux modifications qu'apple realise sur les cores CPU par rapport au design ARM. Des modifications ont bien sur du etre implantees pour fonctionner avec ce nombre d'unite, sachant qui plus est que les gpu powervr series6XT ne sont sences utiliser au max que 6 unites. Ce message a été modifié par superayate - 13 Nov 2014, 15:24. -------------------- 2015: Macbook pro 13,3' early 2011 (i5 2410M) + Config fixe Gamer + Huawei mate 7 + Ipad Air 32Go + Cowon S9

2004 = > DD externe 120Go + graveur DVD dual 8x firewire |

|

|

|

13 Nov 2014, 15:24 13 Nov 2014, 15:24

Message

#32

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 531 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

MS en ce moment à l'air de se remuer un peu (mieux vaut tard…), donc supporter l'ARM n'aurait rien d'insurmontable pour eux. Adobe par contre est encore empêtré dans des logiciels assez archaïques et dépassés, et là ça va prendre un peu plus de temps. Mais on se souviendra qu'Adobe n'a pas eu trop le choix que de passer à OS X et aux procs Intel alors qu'à l'époque la part de marché du Mac était bien inférieure à celle d'aujourd'hui. Et Apple n'avait clairement pas le même poids ! Donc lentement peut-être, mais ça se ferait. Archaïque, dépassé mais incontournable. Si Adobe n'est plus compatible avec les futurs Mac, à ton avis qu'est ce qu'il va se passer ? Ben des tas de gens pragmatiques vont acheter un PC. D'autres laisseront tomber Adobe pour.... quoi au fait ? -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

13 Nov 2014, 15:33 13 Nov 2014, 15:33

Message

#33

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 4 894 Inscrit : 24 Apr 2003 Lieu : Depuis chez lui Membre no 7 276 |

Ça arrangeait Adobe et Microsoft que Mac OS X tourne en x86, parce que ça permettait un portage plus facile du code entre Windows et Mac. ARM, ça serait le contraire, parce qu'il y aurait du travail à reprendre de zéro, des trucs distinctifs en plus à coder, et que ces éditeurs essayent quand même de faire autant que possible du multiplateforme, avec peu d'éléments codés en Objective C ou exploitant Cocoa, alors que c'est justement ce code-là qui est le plus indépendant de l'architecture processeur et le plus simple à faire basculer.

Apple pourrait passer outre les éditeurs, à condition d'avoir une solution façon Rosetta pour convertir du code Intel en ARM à la volée, au prix d'un ralentissement. Il faudrait donc par exemple avoir un processeur ARM qui soit d'emblée deux fois aussi efficace que son prédécesseur Intel pour compenser la dégradation des performances causée par la traduction à la volée. -------------------- « Ayez confiance, je sais ce que je fais. »

|

|

|

|

13 Nov 2014, 15:42 13 Nov 2014, 15:42

Message

#34

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Enfin pour l'instant, dans les SoC Apple, il n'y a que le CPU qui soit Apple, le GPU ça reste du PowerVR standard, donc pas vraiment made in Apple. Il me semble que pourtant l'article explique que le GPU utilisé n'est pas si standard que ça, non ?Alors que pour la partie CPU, seul le jeu d'instructions est standard, le schéma est propre à Apple. -------------------- |

|

|

|

13 Nov 2014, 15:57 13 Nov 2014, 15:57

Message

#35

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 237 Inscrit : 10 Feb 2004 Lieu : Toulouse Membre no 14 613 |

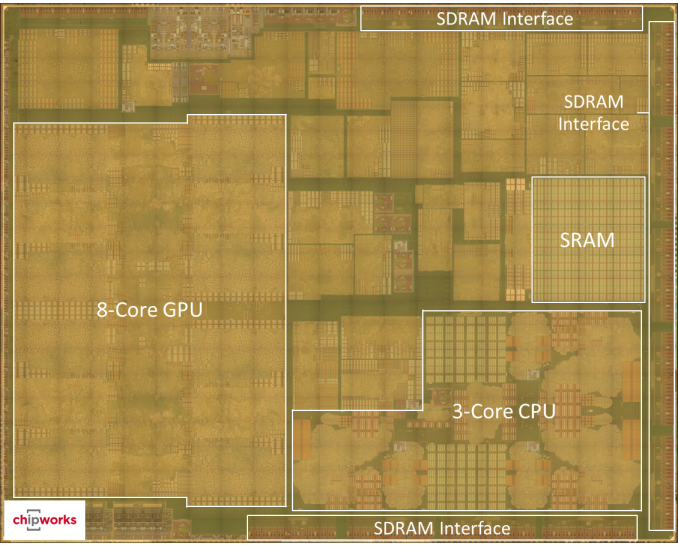

Le floorplan de l'A8X est assez surprenant par rapport a d'autres chips:

Perso ce que je trouve interessant dans le cas present c'est qu'il sagit d'un vrai 3 cores et non d'un 4 cores avec desactivation de l'un d'eux, il semble que TSMC maitrise pas si mal que ca leur 20nm pour qu'Apple soit si confiant -------------------- 2015: Macbook pro 13,3' early 2011 (i5 2410M) + Config fixe Gamer + Huawei mate 7 + Ipad Air 32Go + Cowon S9

2004 = > DD externe 120Go + graveur DVD dual 8x firewire |

|

|

|

13 Nov 2014, 16:14 13 Nov 2014, 16:14

Message

#36

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 090 Inscrit : 13 Jul 2005 Membre no 42 327 |

Faut dire aussi que ce sont des produits qui à la base n'ont pas du tout été conçus pour les mêmes usages et ne sont pas nés en même temps, loin de là. Et quand je vois les dernières puces mobiles d'Intel j'ai l'impression qu'ils ont parfaitement compris la situation. C'est pas du tout un débat pro/anti Intel. On discute là juste de ce qui est opportun de faire. Crois-bien en tout qu'Apple ne prendra pas de décision à la légère et sûrement pas par fanatisme comme laisse par contre transparaître ton commentaire. Il faut dire que l'expérience te pousse à la prudence. Qu'est ce que j'ai pu rigoler le jour où Apple a annoncé que les Mac passaient sous Intel. La veille encore LVM chiait sur les processeurs Intel et du jour au lendemain, il les a trouvé super. C'est formidable le fanboyisme, ça permet de faire un virage à 180 degré en moins de 24 heures. Tellement prévisible et tellement peu crédible. |

|

|

|

13 Nov 2014, 18:27 13 Nov 2014, 18:27

Message

#37

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 5 000 Inscrit : 1 Jul 2010 Membre no 156 073 |

MS en ce moment à l'air de se remuer un peu (mieux vaut tard…), donc supporter l'ARM n'aurait rien d'insurmontable pour eux. Adobe par contre est encore empêtré dans des logiciels assez archaïques et dépassés, et là ça va prendre un peu plus de temps. Mais on se souviendra qu'Adobe n'a pas eu trop le choix que de passer à OS X et aux procs Intel alors qu'à l'époque la part de marché du Mac était bien inférieure à celle d'aujourd'hui. Et Apple n'avait clairement pas le même poids ! Donc lentement peut-être, mais ça se ferait. Archaïque, dépassé mais incontournable. Si Adobe n'est plus compatible avec les futurs Mac, à ton avis qu'est ce qu'il va se passer ? Ben des tas de gens pragmatiques vont acheter un PC. D'autres laisseront tomber Adobe pour.... quoi au fait ? Adobe aussi est pragmatique en travaillant à des versions déportées dans le nuage de ses applications. Photoshop Streaming fonctionne pour Chrome 0S (ARM et x86) ainsi que dans le navigateur Chrome (Windows 7 et 8). Un Mac ARM iOS X aura peut-être droit un jour à une version. -------------------- L'homme n'est que poussière... c'est dire l'importance du plumeau ! Alexandre Vialatte

|

|

|

|

13 Nov 2014, 19:02 13 Nov 2014, 19:02

Message

#38

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

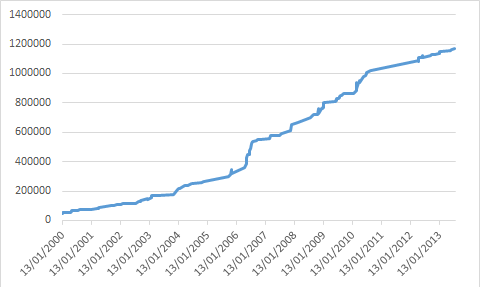

Passer du X86 à l'ARM est avant tout une décision idéologique et politique. Le problème n'est plus tant de pouvoir proposer des applications véloces sur des processeurs ayant 3 milliards de transistors comme l'A8X mais de faire que tous les grands suivent Apple. Quels grands ? Ceux du logiciel style MS ou Adobe ? MS en ce moment à l'air de se remuer un peu (mieux vaut tard…), donc supporter l'ARM n'aurait rien d'insurmontable pour eux. Adobe par contre est encore empêtré dans des logiciels assez archaïques et dépassés, et là ça va prendre un peu plus de temps. Mais on se souviendra qu'Adobe n'a pas eu trop le choix que de passer à OS X et aux procs Intel alors qu'à l'époque la part de marché du Mac était bien inférieure à celle d'aujourd'hui. Et Apple n'avait clairement pas le même poids ! Donc lentement peut-être, mais ça se ferait. Quand aux autres développeurs, une éventuelle transition ça se résumera à 95% du temps à cocher une case dans Xcode. Exactement comme le passage à Intel ou au 64 bits. ... Bien argumenté. Il faut rajouter que la grosse evolution en terme de processeur c'est la reduction de consommation, parce que la puissance brute elle stagne méchamment depuis 2007 sur x86:  Intel a fait de gros progres sur la performance par watt, mais il faut bien se mettre en tete qu'il s'agit s'une optimisation de l'architecture archaique du x86 qui etait initialement pensee dans la dynamique de la conjecture de Moore: la progression de la finesse de gravure etait la clef du gain de puissance et de diminution de la consommation... Le x86 a ete stoppe net avec le mur des 4ghz qui a sonne le glas du mythe de la conjecture de Moore: on peut descendre en finesse de gravure, mais ca n'ameliore pas beaucoup la situation, notamment en terme de dégagement thermique. AMD a permis au x86 d'avoir un sursit en lui offrant un moteur RISC et une architecture 64 bits, mais ca ne change rien au probleme de conception initiale et il faut se rappeler que le code x86 doit etre converti en instructions RISC avant d'etre execute, et le processeur dispose d'un ordonnanceur qui reorganise les instructions avant de les executer... Donc on est sur une architecture complexe, avec des technologies tres avancees, un niveau de complication extreme pour maintenir une vieille architecture basée sur un principe dépassé. ARM c'est l'inverse, une architecture pensee pour l'efficacite par watt, la plasticite et l'efficience du code. Et surtout l'architecture n'est pas basée sur la conjecture de Moore, les processeurs ARM devant etre efficaces en embarqué bien plus vite que ne progressait le finesse de gravure. On voit qu'a la différence du x86, ARM offre une architecture ouverte dans une environnement extrêmement concurrentiel ou des solutions innovantes peuvent etre facilement mise en place: tout l'inverse du x86 et de la politique de monopole totalitaire d'Intel. Aujourd'hui ARM est l'architecture de reference pour le mobile, et se developpe hors de l'embarque vers le serveurs, le HPC et maintenant le PC. Ce qu'a fait Apple est un processeur ultra mobile mais qui a une puissance desktop. Le travail sur le GPU est une nouveaute qui demontre qu'Apple a acquis non seulement le savoir faire sur CPU mais va au-dela. Pour comprendre ou en est Apple réellement, il va falloir attendre le SoC de l'Apple watch. Pour Apple passer sous ARM sa ligne PC a plusieurs avantages, a commencer par le cout et la maitrise logiciel/materiel. Le probleme pour Apple c'est qu'aujourd'hui la partie logicielle a besoin d'etre reprise en main sérieusement Adobe aussi est pragmatique en travaillant à des versions déportées dans le nuage de ses applications. Photoshop Streaming fonctionne pour Chrome 0S (ARM et x86) ainsi que dans le navigateur Chrome (Windows 7 et 8). Un Mac ARM iOS X aura peut-être droit un jour à une version. Si Adobe ne passait pas a ARM cela relancerait la concurrence sur un secteur qui est soumis a un monopole délétère depuis des années, et la baisse des ventes chez Adobe va les inciter a se réveiller enfin. Donc Adobe passera a ARM c'est meme pas la question. Ce qui compte pour utiliser ces logiciels c'est plus les performances graphiques que le CPU, et la on a bien des gens qui travaillent avec uniquement les pauvres unites graphiques integrées aux Core ix... On ne parle meme pas des Mac Pro qui embarquent des GPU NVidia alors que la majorite des softs de traitements graphiques sont optimise pour les cartes NVidia. Donc lorsque Apple sortira ces Mac ARM, ils tourneront au moins aussi vite que ce que l'on a actuellement et les performances graphiques seront probablement meilleures, a part pour les modeles haut de gamme avec des GPU Nvidia, et encore, quand on voit l'anemique GPU de l'iMac retina, ca va pas etre difficile de faire mieux. Quant a l'histoire du cloud computing pour faire tourner ce type de soft c'est du markting et c'est sans interet. Ce message a été modifié par r@net54 - 13 Nov 2014, 19:03. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

13 Nov 2014, 19:18 13 Nov 2014, 19:18

Message

#39

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 495 Inscrit : 18 Sep 2007 Membre no 95 094 |

Passer du X86 à l'ARM est avant tout une décision idéologique et politique. Le problème n'est plus tant de pouvoir proposer des applications véloces sur des processeurs ayant 3 milliards de transistors comme l'A8X mais de faire que tous les grands suivent Apple. Le problème est là et Intel fera tout pour que ce n'arrive pas. Rappelez vous juste ce qu'Intel a réussi à faire pour bloquer AMD. Si Apple veut passer à de l'ARM pour les Macs, personne ne pourra les arrêter. Qu'en est-il de l'avance d'ARM par rapport à X86 en termes de performance/Watt ? De même pour le GPU type powerVR versus l'intel IRIS ? C'est un critère important. Intel a dépassé ARM sur le rapport performance/Watt lors de la sortie des Atoms Baytrail. Il est possible que certains designs de référence d'ARM soient repassés légèrement devant depuis mais ils ont été à nouveau dépassés par les derniers Moorefield. Par contre Apple et ses Ax a largement dépassé ARM depuis longtemps et dépasse visiblement assez largement Intel avec l'A8. Pour ce qui est de l'efficacité des PowerVR, c'est réellement difficile à évaluer. Une chose dont on peut être sûrs c'est qu'ils sont si bons que même Intel en utilise (sur des puces d'entrée de gamme : les Atoms Moorefield ). |

|

|

|

13 Nov 2014, 19:26 13 Nov 2014, 19:26

Message

#40

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

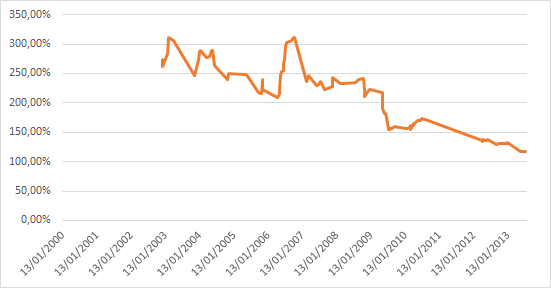

Il faut rajouter que la grosse evolution en terme de processeur c'est la reduction de consommation, parce que la puissance brute elle stagne méchamment depuis 2007 sur x86: Bien essayé... Mais : 1) SuperPi est un benchmark qui n'utilise aucune nouvelle instruction. C'est bien pour comparer les performances brutes sur quelques opérations simples, mais ce n'est absolument pas représentatif de l'évolution des performances réelles à l'usage sur pas mal de tâches, car toutes les applications d'aujourd'hui utilisent les nouveaux jeux d'instructions... C'est particulièrement vrai par exemple pour tout ce qui est applications multimédia, où l'apport des nouvelles instructions peut parfois se traduire par un doublement des performances d'une génération à l'autre, même si les performances en arithmétique pure n'ont presque pas bougé. 2) L'auteur de ce graphique a choisi une échelle linéaire pour le temps de calcul : c'est complètement con comme échelle ! Une échelle linéaire sur un temps de calcul, ça fait qu'une augmentation exponentielle des performances donne une courbe logarithmique : c'est totalement biaisé, ça donne l'impression que la progression est de plus en plus faible. À plus forte raison, quand le progression n'est plus exponentielle, une représentation logarithmique "écrase" encore plus la courbe, renforçant l'impression de stagnation. En l'occurrence, la "méchante stagnation" depuis 2007, c'est quand même une multiplication des performances par un facteur supérieur à 2 (certes, on était auparavant plus habitué à voir ça sur deux ans, voir moins), sur du code ne profitant pas des plus grosses améliorations... AMD a permis au x86 d'avoir un sursit en lui offrant un moteur RISC et une architecture 64 bits, mais ca ne change rien au probleme de conception initiale et il faut se rappeler que le code x86 doit etre converti en instructions RISC avant d'etre execute, et le processeur dispose d'un ordonnanceur qui reorganise les instructions avant de les executer... Ce qui est rigolo avec toi, c'est que on a beau t'expliquer que tous les processeurs performants d'aujourd'hui font de la traduction d'instruction (et en particulier les deux ARM les plus performants sur le marché grand public : A8 et Tegra K1, ce dernier faisant cette traduction de façon logicielle) et qu'une bonne part fait aussi de l'exécution out-of-order (y compris l'A8, dont le re-order buffer est aussi gros que celui d'un Haswell), tu continues à présenter ça comme un défaut propre à l'architecture x86 Quand à la complexité de l'architecture, quand on voit qu'un A8 tape dans les 2 milliards de transistors, soit plus qu'un Haswell quad-core GT2 (1.6 milliards), on peut se demander si c'est vraiment aussi simple que tu le prétends EDIT : d'après cette image http://pc.watch.impress.co.jp/img/pcw/docs/615/261/06.jpg et celle là http://media.bestofmicro.com/R/R/462375/or..._A7-A8_Dies.jpg, on peut estimer que les deux cœurs CPU du A8 font ~12.9mm² contre ~8.8mm² pour deux cœurs Atom Bay Trail. Alors que l'A8 est gravé très légèrement plus fin. Même avec la grosse marge d'erreur inhérente à ce type de mesures, il est donc à peu près certain que deux cœurs A8 nécessitent plus de transistors que 2 cœurs Bay Trail. Complexité du x86 tu disais ? -------------------- |

|

|

|

14 Nov 2014, 11:37 14 Nov 2014, 11:37

Message

#41

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 076 Inscrit : 16 Dec 2002 Membre no 5 167 |

Je pense à un truc du genre MacTracker qui donne plein d'informations mais pas de mesure comparative de puissance. MacTracker à pourtant une rubrique Benchmarks dans la partie processeur pour quasiment tout les modèles. Ah oui, j'avions point vu. Merci. En admettant que c'est représentatif, mon imac fait quatre fois moins bien qu'un imac actuel. Ils auraient gardé des écrans mats que ça me donnerait envie de moderniser mon engin... -------------------- Co-fondateur et Administrateur de l'U.P.L.

Membre du club des AIPBP (Anciens Inscrits Pas Beaucoup de Posts) Voir la liste |

|

|

|

14 Nov 2014, 16:50 14 Nov 2014, 16:50

Message

#42

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Il faut rajouter que la grosse evolution en terme de processeur c'est la reduction de consommation, parce que la puissance brute elle stagne méchamment depuis 2007 sur x86: Bien essayé... Mais : 1) SuperPi est un benchmark qui n'utilise aucune nouvelle instruction. C'est bien pour comparer les performances brutes sur quelques opérations simples, mais ce n'est absolument pas représentatif de l'évolution des performances réelles à l'usage sur pas mal de tâches, car toutes les applications d'aujourd'hui utilisent les nouveaux jeux d'instructions... C'est particulièrement vrai par exemple pour tout ce qui est applications multimédia, où l'apport des nouvelles instructions peut parfois se traduire par un doublement des performances d'une génération à l'autre, même si les performances en arithmétique pure n'ont presque pas bougé. 2) L'auteur de ce graphique a choisi une échelle linéaire pour le temps de calcul : c'est complètement con comme échelle ! Une échelle linéaire sur un temps de calcul, ça fait qu'une augmentation exponentielle des performances donne une courbe logarithmique : c'est totalement biaisé, ça donne l'impression que la progression est de plus en plus faible. À plus forte raison, quand le progression n'est plus exponentielle, une représentation logarithmique "écrase" encore plus la courbe, renforçant l'impression de stagnation. En l'occurrence, la "méchante stagnation" depuis 2007, c'est quand même une multiplication des performances par un facteur supérieur à 2 (certes, on était auparavant plus habitué à voir ça sur deux ans, voir moins), sur du code ne profitant pas des plus grosses améliorations... SuperPi évalue la puissance de calcul brute du core comme tu le reconnais. Il n'évalue pas les autres unites comme les unites de traitement vectoriel, les unite de gestion I/O, les equivalents des DSP, etc. Ce test est donc représentatif de la puissance de calcul en monocore. il est valable et représentatif de la progression reelle de la puissance. Et cette puissance de calcul est celle du CPU. Si on veut évaluer la puissance en vectoriel, par exemple pour le traitement video, les CPU sont totalement écrasés par le GPGPU. Pareil pour le traitement de signal. Je sais que ca fait mal de voir ca, mais le choix de la representation est legitime et significative. Le systeme est simple et il dit bien ce qu'il veut dire: combien de temps met un processeur pour realiser un calcul standard? Il dit donc que depuis 2007 il n'y a pas eu d'evolution significative sur la puissance de traitement: le temps necessaire pour realiser le calcul étant quasi le meme depuis 7 ans, ce que tu reconnais aussi! Quant a la complexité de l'architecture, tu détournes volontairement le sujet sur le nombre de composants (transistors). Ca n'a rien a voir évidemment avec la complexité de l'architecture. Dans un x86 on a au moins 1 niveau de pre-traitement et de post-traitement des données supplémentaires, donc ca augmente la complexité d'au moins 2 niveaux. D'ailleurs tu le sais pertinemment. Intel a un savoir faire en terme d'optimisation de rendement qui est superieur a la majorite des autres concepteurs de CPU, a part IBM. Ils disposent aussi d'un savoir faire en terme de gravure parmi les meilleurs. Pourquoi avec une telle avance ils n'arrivent pas avec les Atom a écraser les ARM? Si aujourd'hui TSMC est en train de faire son retard sur Intel en terme d'efficacite de gravure, c'est tout nouveau et ils sont pas encore aussi efficace qu'Intel. Donc on a un x86 totalement maitrisé optimisé comme une formule 1 par des ingenieurs qui sont les meilleurs au monde et en face on a de l'ARM qui est encore tres loin d'etre aussi optimisé et qui est moins maitrisée. Donc la marge de progression entre le x86 et l'ARM n'est pas la meme. La difference c'est l'efficacité de l'architecture:CQFD. Ce message a été modifié par r@net54 - 14 Nov 2014, 17:03. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

14 Nov 2014, 17:16 14 Nov 2014, 17:16

Message

#43

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 515 Inscrit : 21 Sep 2005 Membre no 46 410 |

SuperPi évalue la puissance de calcul brute du core comme tu le reconnais. Il n'évalue pas les autres unites comme les unites de traitement vectoriel, les unite de gestion I/O, les equivalents des DSP, etc. Ce test est donc représentatif de la puissance de calcul en monocore. il est valable et représentatif de la progression reelle de la puissance. Et cette puissance de calcul est celle du CPU. Si on veut évaluer la puissance en vectoriel, par exemple pour le traitement video, les CPU sont totalement écrasés par le GPGPU. Pareil pour le traitement de signal. Je sais que ca fait mal de voir ca, mais le choix de la representation est legitime et significative. Le systeme est simple et il dit bien ce qu'il veut dire: combien de temps met un processeur pour realiser un calcul standard? Il dit donc que depuis 2007 il n'y a pas eu d'evolution significative sur la puissance de traitement: le temps necessaire pour realiser le calcul étant quasi le meme depuis 7 ans, ce que tu reconnais aussi! Ça revient à mesurer la vitesse maximale d'une voiture en la bloquant au 1er rapport de sa boîte de vitesse. Ce n'est donc absolument pas significatif pour la vie de tous les jours. |

|

|

|

14 Nov 2014, 17:47 14 Nov 2014, 17:47

Message

#44

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Ce test est donc représentatif de la puissance de calcul en monocore. Dans un contexte bien particulier. Donc pas représentatif de la réalité.Si on veut évaluer la puissance en vectoriel, par exemple pour le traitement video, les CPU sont totalement écrasés par le GPGPU. Sauf qu'il y a dans la réalité énormément de logiciels qui font appel à ces unités vectorielles (y compris les OS eux mêmes), sans pour autant faire appel au GPGPU. Donc ignorer totalement ces unités dans les tests, ce n'est pas du tout représentatif de l'usage réel.Et les nouvelles instructions qui sont apportées à chaque génération de CPU, c'est pas forcément que sur du vectoriel, c'est parfois aussi sur de l'arithmétique de base, sur de la manipulation de chaînes de caractères, etc... Je sais que ca fait mal de voir ca, mais le choix de la representation est legitime et significative. Désolé, mais non. Un choix de présentation graphique qui transformerait une croissance exponentielle en courbe logarithmique, ce n'est pas très légitime, c'est une façon de biaiser la perception qu'on fait du résultat...Il dit donc que depuis 2007 il n'y a pas eu d'evolution significative sur la puissance de traitement: le temps necessaire pour realiser le calcul étant quasi le meme depuis 7 ans, ce que tu reconnais aussi! Depuis 7 ans, si on regarde la courbe on a l'impression que ça n'a pas bougé d'un poil. Si on fait un peu plus attention, on voit qu'il y a une progression d'un facteur de l'ordre de deux, ce qui reste loin d'être négligeable (surtout que dans le même temps, on a aussi quadruplé le nombre de cœurs...). Refait la courbe en prenant la vitesse de traitement au lieu du temps de traitement, elle donnera une vision nettement différente. EDIT : tiens en prime pour ajouter au caractère non représentatif de ce graphique, il ne s'agit pas de l'évolution des performances des CPU commerciaux, mais de l'évolution des records de performances avec des CPU overclockés à mort (c'est dommage de devoir aller chercher moi même ce genre d'infos... si t'avais un minimum d'honnêteté intellectuelle, tu aurais précisé dès le départ le nom du bench, le type de processeurs testés, etc... mais non, toi tu balances juste une courbe sans légende...)... Or, les CPU d'il y a quelques années avaient souvent une marge de progression en OC bien plus importante : les Pentium 4 étaient essentiellement limités par leur dissipation thermique, donc s'envolaient dès qu'on les mettait sous azote, ce qui est beaucoup moins vrai avec les CPU d'aujourd'hui. Tiens, cadeau, voilà la courbe de la vitesse de traitement (tiens, je fait comme toi, je met pas de légende... mais au moins on sait de quoi je parle) :  Qu'est ce qu'on voit alors ? Les performances ne stagnent pas depuis 2007, elles ont simplement cessé d'avoir une progression exponentielle pour s'approcher de quelque chose de plutôt linéaire. Mais le plus intéressant à mon sens, c'est cette courbe là, qui correspond au rapport de performances sur 3 ans :  On voit bien qu'il y a une diminution de la progression de performances, mais on voit aussi qu'on n'est pas encore en stagnation sur 3 ans, et à fortiori encore moins sur 7 ans (la stagnation correspond à 100%). Et c'est sans compter l'impact de la multiplication des cœurs et sans regarder le rapport performances/consommation... Mais ça serait par contre bien plus intéressant de faire ça avec des chiffres de performances à la date de sortie pour des processeurs à leur fréquence normale. Des chiffres réalistes quoi... Quant a la complexité de l'architecture, tu détournes volontairement le sujet sur le nombre de composants (transistors). Ca n'a rien a voir évidemment avec la complexité de l'architecture. Dans un x86 on a au moins 1 niveau de pre-traitement et de post-traitement des données supplémentaires, donc ca augmente la complexité d'au moins 2 niveaux. Euh si, complexité et nombre de transistors sont quand même assez liés... Et au contraire, tu peux avoir un processeur plus simple tout en ayant plus de niveaux, les différents niveaux pouvant être plus ou moins complexes...Mais bon, puisque tu es convaincu que seul ne nombre de niveaux compte, regardons le le nombre de niveaux... Tu dis qu'il y a au moins deux niveaux de plus ? Ben non Le pipeline du Haswell fait entre 14 et 19 niveaux selon les cas, Bay Trail 14 à 17. Un Cortex A15, c'est 15 niveaux pour les entiers, 17 à 25 niveaux pour les flottants. Et pour l'A8, c'est en moyenne au moins 16 niveaux, et généralement compris entre 14 et 19 niveaux (oui, pile poil comme Haswell) (cf AnandTech : http://www.anandtech.com/show/7910/apples-...ecture-detailed , la longueur du pipeline étant forcément supérieure ou égale à la pénalité en cas de mauvaise prédiction de branchement). Accessoirement, comme tu l'auras déduit de ces chiffres, le nombre de niveaux à traverser pour traiter une instruction ne dépend pas de l'architecture, mais de la microarchitecture. D'un processeur ARM à l'autre, on n'a pas le même nombre de niveaux, tout comme il varie d'un processeur x86 à l'autre. Mais on constate que tous les CPU ARM hautes performances ont des pipelines du même ordre de longueur que ceux des Intel haut de gamme. Pourquoi avec une telle avance ils n'arrivent pas avec les Atom a écraser les ARM? Mais quelle avance ? C'est tout le contraire, le x86 est arrivé très tard sur le marché de l'ultramobilité, alors qu'ARM y était déjà en quasi monopole. ARM est présent sur les PDA/smartphones depuis 15/20 ans, le x86 depuis 4-5 ans (Atom Z500, lancé en juin 2010). Et en prime, Intel est arrivé avec un SoC incomplet par rapport à ceux du leader (Qualcomm), donc handicapant (pas de baseband intégré au SoC).Et quand tu arrives ainsi bien après le concurrent, c'est jamais facile de rattraper le retard, surtout avec des OS et des logiciels optimisés uniquement pour le concurrent, et les pertes liées à l'émulation/traduction pour tous les logiciels qui n'auront pas été portés en natif. On voit d'ailleurs bien que le seul marché de l'ultra-mobilité sur lequel ARM n'est pas arrivé bien avant le x86, il est déjà quasiment perdu pour ARM : il ne sort quasiment plus aucune nouvelle tablette Windows ARM, toute la production a basculé sur le x86. Donc on a un x86 totalement maitrisé optimisé comme une formule 1 par des ingenieurs qui sont les meilleurs au monde et en face on a de l'ARM qui est encore tres loin d'etre aussi optimisé et qui est moins maitrisée. Donc la marge de progression entre le x86 et l'ARM n'est pas la meme. Il suffit pas de mettre un CQFD à la fin d'une phrase pour que la phrase en question démontre quoique ce soit... En gros, là tu nous dit juste que selon toi ARM à de la marge de progression parce que selon toi ARM est actuellement moins maitrisé et moins optimisé que le x86. Mais tu démontres que dalle, tu n'as rien pour étayer, aucun argument technique. Juste du doigt levé et du pifomètre.La difference c'est l'efficacité de l'architecture:CQFD. Et au contraire, la réalité des faits montre plutôt que ça commence à stagner aussi dans la monde ARM... Regarde par exemple la progression des performances CPU entre l'A6 et l'A7 puis entre l'A7 et l'A8, la progression a très fortement ralenti... Et c'est encore pire chez la concurrence. -------------------- |

|

|

|

14 Nov 2014, 19:33 14 Nov 2014, 19:33

Message

#45

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 5 000 Inscrit : 1 Jul 2010 Membre no 156 073 |

Quant a l'histoire du cloud computing pour faire tourner ce type de soft c'est du markting et c'est sans interet. Parle pour toi ! Les solutions déportées ne sont pas l'idéal mais peuvent s'avérer fort pratiques dans un monde vraiment mobile, en tout cas, je saurais quoi en faire. Adobe aussi est pragmatique en travaillant à des versions déportées dans le nuage de ses applications. Photoshop Streaming fonctionne pour Chrome 0S (ARM et x86) ainsi que dans le navigateur Chrome (Windows 7 et 8). Un Mac ARM iOS X aura peut-être droit un jour à une version. Si Adobe ne passait pas a ARM cela relancerait la concurrence sur un secteur qui est soumis a un monopole délétère depuis des années, et la baisse des ventes chez Adobe va les inciter a se réveiller enfin. Donc Adobe passera a ARM c'est meme pas la question. Ce qui compte pour utiliser ces logiciels c'est plus les performances graphiques que le CPU, et la on a bien des gens qui travaillent avec uniquement les pauvres unites graphiques integrées aux Core ix... Tu es anti x86 et anti Adobe, je comprends que tu ne sois pas plus nuancé sur le sujet. Le GPU est déporté dans le nuage. Et alors ? Tu ne vois pas d'opportunités de t'en servir ? Quelle concurrence ? Je précise que je n'ai pas d'affection pour Adobe ni pour Intel, je suis agnostique comme toi -------------------- L'homme n'est que poussière... c'est dire l'importance du plumeau ! Alexandre Vialatte

|

|

|

|

|

1 utilisateur(s) sur ce sujet (1 invité(s) et 0 utilisateur(s) anonyme(s))

0 membre(s) :

| Nous sommes le : 17th September 2025 - 01:56 |