Bienvenue invité ( Connexion | Inscription )

14 Mar 2015, 07:16 14 Mar 2015, 07:16

Message

#1

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 578 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

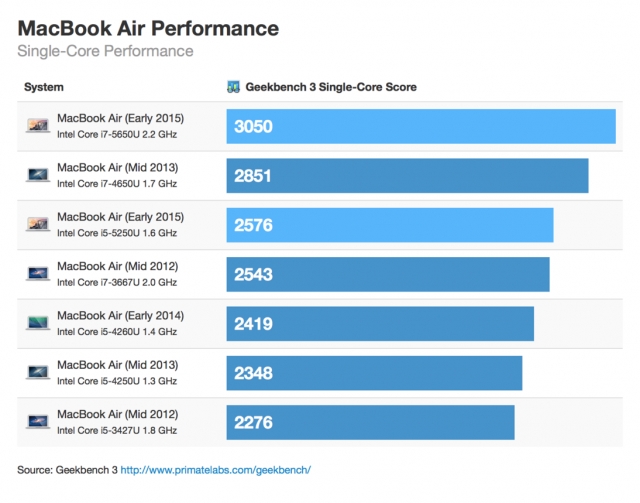

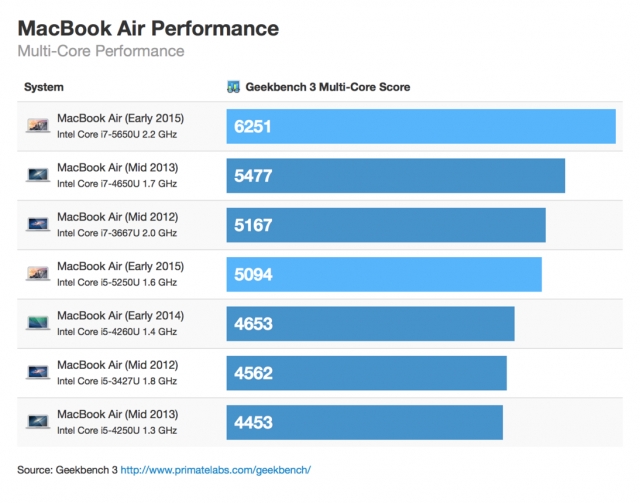

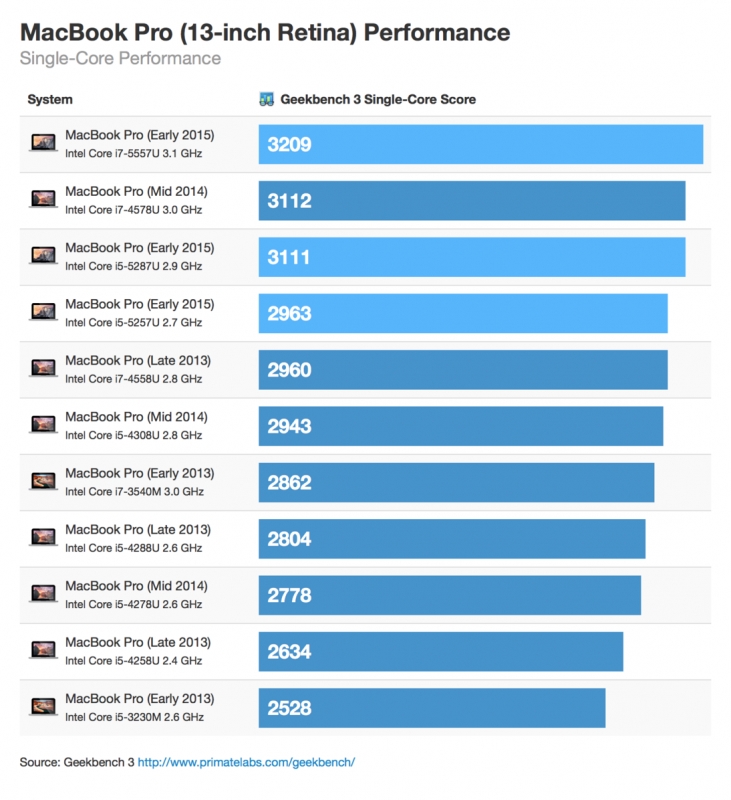

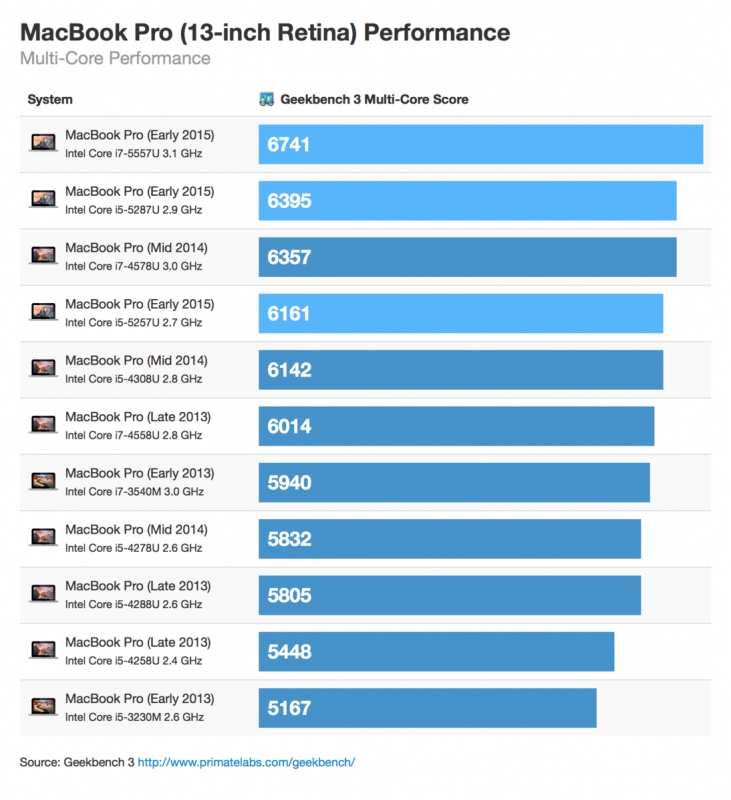

Primate Labs, éditeur de GeekBench, a réalisé une compilation des résultats obtenus par les nouveaux MacBook Air et MacBook Pro.

Si les performances du Core i5 sont en légère hausse, sur le MacBook Air environ 7%, celles du Core i7 sont en réelle augmentation, 14% par rapport au modèle précédent. Si vous en avez les moyens ce dernier est certainement le meilleur compromis et le meilleur rapport puissance-prix.   Au niveau du MacBook Pro les gains de performances apportés par la nouvelle version sont plus faibles, et ce seront certainement le nouveau trackpad haptique et l'autonomie en hausse qui seront les meilleurs arguments pour inciter à adopter cette gamme. Lien vers le billet original -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

|

Réponse(s)

14 Mar 2015, 09:57 14 Mar 2015, 09:57

Message

#2

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 305 Inscrit : 22 Aug 2001 Lieu : Paris Membre no 668 |

Ca reste des sauts de puces (hahaha) depuis un long moment maintenant, au niveau CPU brut.

Mon MBA2012 - core i7 - fait un peu moins de 3k/6k sur Geekbench (tiens ça voudrait dire qu'il était un poil meilleur que le 2013? peut être le CPU est un peu plus élevé.) ici on fait un peu plus… à la louche 10% de perf en 3 ans. Le MBP 13 Retina 2015, idem, en CPU il fait un bon 15% de plus qu'un MacBook Air d'il y a 3 ans. Ce n'est pas époustouflant. Après, oui, ce n'est pas toujours représentatif de l'expérience ressentie, et puis le GPU, le SSD PCI-Express, l'autonomie... heureusement, les machines ont globalement progressé. Autant entre 2010 et 2012, on a eu des vrais gains de CPU sur les ultra portables, autant depuis… c'est bien calme. Ce message a été modifié par GregWar - 14 Mar 2015, 09:58. -------------------- MBP13 Early 2015 - Core i7.

|

|

|

|

14 Mar 2015, 13:36 14 Mar 2015, 13:36

Message

#3

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Ca reste des sauts de puces (hahaha) depuis un long moment maintenant, au niveau CPU brut. Mon MBA2012 - core i7 - fait un peu moins de 3k/6k sur Geekbench (tiens ça voudrait dire qu'il était un poil meilleur que le 2013? peut être le CPU est un peu plus élevé.) ici on fait un peu plus… à la louche 10% de perf en 3 ans. Le MBP 13 Retina 2015, idem, en CPU il fait un bon 15% de plus qu'un MacBook Air d'il y a 3 ans. Ce n'est pas époustouflant. Après, oui, ce n'est pas toujours représentatif de l'expérience ressentie, et puis le GPU, le SSD PCI-Express, l'autonomie... heureusement, les machines ont globalement progressé. Autant entre 2010 et 2012, on a eu des vrais gains de CPU sur les ultra portables, autant depuis… c'est bien calme. Certes la progression est tres faible, mais elle correspond a ce qui ete attendu de la presence d'un CPU ayant une frequence superieure. Au moins on va pas cracher sur ces quelques megahertz de plus, c'est toujours mieux que les régressions qu'on a eu avec les MacMini et iMac d'entree de gamme. On note aussi que l'unite graphique semble etre sensiblement plus performante sur le Macbook Pro 13". Certes ce n'est pas un GPU distinct, mais au moins ca devient intéressant. Et puis il y a surtout le passage en Thunderbolt 2 - bon ok ca va pas durer longtemps, le thunderbolt 3 arrive cet automne avec Skylake... Et la on va pas se plaindre non plus d'avoir des ports a foisons De toute facon Apple ne peut pas malgre ses competences faire progresser la puissance de calcul plus que le processeur d'Intel ne le permet. La question qui reste c'est maintenant de savoir si les générations précédentes de processeurs a la même fréquence auraient données des résultats similaires, moins bons, ou meilleurs? Et la reponse n'est pas évidente. Maintenant il ne reste plus qu'a esperer que les mise a jours de l'automne en version Skylake auront une meilleure performance a frequence egale. Reste qu'entre l'augmentation de prix et le peu apporté par cette generation, il est, comme le disait Lionel il y a quelques jours, tres intéressant de prendre une machine sur le refurb. Allez cet automne Apple nous sort des MBA 12" et 15" Retina, avec 2 Thunderbolt 3, 2 USB C, une carte SD, et un port MagSafe, en 8Go/512Go en base, et au meme prix Ce message a été modifié par r@net54 - 14 Mar 2015, 13:50. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

14 Mar 2015, 22:41 14 Mar 2015, 22:41

Message

#4

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Certes la progression est tres faible, mais elle correspond a ce qui ete attendu de la presence d'un CPU ayant une frequence superieure. Toi faudrait vraiment qu'on te mette sur dynamo... Tu tournes tellement vite sur toi même qu'on aurait une source d'énergie inépuisable Il y a quelques jours, tu étais au bord de l'orgasme quand les premiers résultats geekbenchs semblaient plutôt montrer une stagnation des performances... Tu trouvais ces résultats parfaitement normaux ("Mais ce qui est deja certain, c'est que Broadwell n'apporte rien en puissance.", en réponse à mes doutes sur la validité de ces résultats...), et maintenant tu nous dis que des résultats supérieurs étaient attendus ? Et tu remarqueras que les gains relevés ici, ne correspondent pas seulement à l'augmentation de fréquence et prouvent (100 MHz sur un CPU à 2.6 GHz, ça fait même pas 4%), s'ils se confirment (ça reste du Geekbench, donc à confirmer avec quelque chose de plus fiable...), que l'architecture Broadwell est effectivement plus rapide à fréquence égale que Haswell (Intel promet 5.5% de gain d'IPC, c'est de l'ordre de ce qu'on retrouve ici), puisqu'on voit que les modèles Broadwell égalent, voir dépassent les performances de modèles Haswell avec 100 MHz de plus... Donc comme en plus Apple a mis des Broadwell 100 MHz plus rapides pour le même prix (en dollars, les prix en euros ont évolué à la hausse à cause du taux de change, pas à cause de l'évolution de la configuration), on a une partie du gain qui vient du gain de fréquence, une partie qui vient du gain de l'architecture, et sans doute également une partie qui vient du gain de consommation : une consommation plus faible à fréquence égale permet de pousser le turbo plus haut en fréquence dans des tâches pour lesquelles ils ne pouvait pas atteindre son maximum à cause de la limite de consommation... c'est sans doute ce qui explique que les résultats multi-core soient plus favorables au Broadwell que les single-core, le turbo en multi-core étant plus souvent limité par la consommation qu'en mono. Mais bon, j'attendrais quand même des benchs plus sérieux que Geekbench pour avoir un avis définitif sur la question, même si ces nouveaux résultats Geekbench sont déjà bien plus en accord avec ce qu'on a pu voir jusqu'à présent dans les divers tests de PC... Au passage, ces résultats montrent une nouvelle fois ce que je me tue à répéter depuis des années : Geekbench, c'est sympa pour avoir un résultat approximatif rapidement, mais c'est justement trop rapide pour être fiable... Il y a 3 jours, sur la base de résultats Geekbench on nous disait que les nouveaux MB(A|P) avaient les mêmes performances que les anciens malgré 100 MHz de plus, maintenant avec le même bench on nous dit que finalement ils sont 7 à 14% plus rapides, ce qui dépasse le gain apporté par les 100 MHz de plus... Suffit de regarder la base de résultats Geekbench pour comprendre le problème, puisque pour le MBPR en Core i5-4278U 2.6 GHz on trouve des scores single/multi qui s'étalent de 2339/4612 à 3203/6852 Histoire d'avoir quelque chose de plus fiable, il serait intéressant de faire un script qui prenne pour une machine donnée tous les résultats de la base Geekbench, enlève les 10-20% inférieurs et supérieurs et fasse la moyenne de 60-80% restants. Ça gommerait sans doute le gros des imprécisions de Geekbench. Avis aux amateurs s'il y en a un que ça motive de faire ça La question qui reste c'est maintenant de savoir si les générations précédentes de processeurs a la même fréquence auraient données des résultats similaires, moins bons, ou meilleurs? Et la reponse n'est pas évidente. Bah au regard de ces benchs, non, la question ne se pose plus, puisque le nouveau à 2.9 GHz égale l'ancien à 3 GHz et le nouveau 2.7 dépasse l'ancien 2.8... Augmenter la fréquence de 100 MHz par rapport à la génération précédente, mais en restant sur du Haswell n'aurait donc pas apporté autant de gain de performances...Par ailleurs, ce gain de 100 MHz en passant à Broadwell se fait sans surcoût, comme je te l'ai déjà expliqué l'autre jour. Par exemple, un i5-5287U à 2.9 GHz, c'est le même prix qu'un i5-4308U à 2.8 GHz (315$), qu'il dépasse largement, et est 26% moins cher que le i5-4578U à 3 GHz qu'il dépasse légèrement... Le rapport performances/prix est donc nettement en faveur du Broadwell. Comme il a aussi jusqu'à preuve du contraire l'avantage sur le rapport performances/consommation et qu'il ne nécessite aucune évolution significative de la carte mère par rapport à Haswell, rester sur Haswell serait totalement injustifié : on aurait eu des machines moins performantes et moins autonomes à prix égal, ou aussi performantes et moins autonomies pour plus cher (parce que faut pas rêver, le surcoût sur le CPU, il aurait pas été pris sur la marge d'Apple hein). Intel a compensé la stagnation du core en puissance de calcul brute par un ensemble de coprocesseurs qui déchargent le Core de plus en plus de taches et les font bien mieux et bien plus vite: ex le GPU, l'unite qui s'occupe de la cryptographie, l'unite vectorielle, les divers DSP, la gestion de l'alimentation Décidément, on a beau te le répéter, tu continues à débiter les mêmes âneries...Non, l'unité vectorielle n'est PAS un coprocesseur. C'est justement l'un des intérêts du x86, c'est qu'il permet très facilement d'intégrer de nouvelles instructions directement dans le processeur, évitant ainsi de passer par un coprocesseur, avec tous les inconvénients que ça implique : un coprocesseur a son propre flux d'instructions, donc ça duplique en partie les circuits de décodage d'instructions, il doit communiquer avec le CPU via le goulet d'étranglement du bus système, ce qui limite les performances, il n'a pas d'accès direct à la mémoire et au cache (sauf éventuellement son propre cache s'il en a un...), et encore moins aux registres. C'était d'ailleurs l'un des griefs d'Intel envers ARM à l'époque des Xscale : alors que sur un Pentium l'unité MMX a pu être directement intégrée dans le cœur d'exécution, elle devait être un coprocesseur sur le Xscale, ce qui réduisait son bénéfice. Donc la cryptographie et l'unité vectorielle (enfin les unités vectorielles), ça fait partie intégrante du cœur d'exécution sur un x86. Le GPU, ça reste bien entendu indépendant. Mais en dehors de la 3D et d'OpenCL, tous les gains de performances qu'on observe sur les générations successives de processeurs Intel sont obtenus SANS recours au GPU. Et c'est le cas de ces résultats geekbench, qui sont bien des résultats CPU, pas GPU. C'est à ma connaissance la seule unité de traitement qui soit externe au CPU sur les Core i (c'est quoi les "divers DSP" dont tu parles ?). -------------------- |

|

|

|

15 Mar 2015, 12:21 15 Mar 2015, 12:21

Message

#5

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Certes la progression est tres faible, mais elle correspond a ce qui ete attendu de la presence d'un CPU ayant une frequence superieure. Toi faudrait vraiment qu'on te mette sur dynamo... Tu tournes tellement vite sur toi même qu'on aurait une source d'énergie inépuisable Bravo pour l'attaque personnelle: tu n’arrivais déjà plus qu'a surnager mais la tu coules dans la vulgarité et tes propos n'ont plus la moindre crédibilité ou un quelconque intérêt. C'est pathétique et ça en dis long sur ton comportement et sur ce qu'il te reste. Je sais pas quel est ton problème exactement, a part que tu détestes Apple, mais on dirait que ton jugement n'est plus qu’émotionnel et réactionnel et tu ne supporte plus de ne pas avoir raison, d’être contredis, que ce soit par quelqu'un et plus encore par la réalité. Même lorsque l'on ne s'adresse pas a toi, tu attaques les gens, tu les apostrophes vulgairement, et tu ne développe pas d'argumentaire construit... Tu n'as plus d'opinion mais tu défends un dogme...! Mais regarde autour de toi: ici personne ne t'agresse, les gens ne font que parler de technologies. On se fout de qui tu es, d’où tu viens, de ce que tu peux représenter, de ton métier, de ta formation ou pas. Tu n'existes pas! La seule chose ici c'est que l'on écrit, on échange des opinions, on constate des faits. Le fait dont il est question ici c'est qu'Intel est pris une fois de plus en défaut sur sa propagande face a la réalité. On constate tous que le x86 n'est plus capable de monter en puissance, que la débauche technologique et financière d'Intel aboutie a un surplace incontestable. Broadwell est un échec a divers niveaux pour Intel, qui a pourtant fait des investissements de manière colossale. Le passage de 22nm a 14nm n'apporte vraiment pas grand chose, et surtout en regard des investissements qui ont été nécessaires pour sa mise en place. Intel se retrouve aujourd'hui en concurrence directe et frontale avec Samsung: TSMC et GF ne sont pas loin... Tous constatent que la conjecture de Moore a atteint son terme. Lionel a commencé cette serie d'articles des la sortie des premiers exemplaires avec ce que nous disons tous, ici: broadwell n'apporte rien qui ne justifie l'achat d'une nouvelle machine. On le voit tous, on est tous d'accord. Apres ca veut pas dire que les machines sont a jeter, mais le bon conseil c'est d'attendre la prochaine génération ou d'acheter une machine a un meilleur prix sur le refurb, c'est tout. Broadwell aurait du signer un mise a jour majeure des Mac et des PC, voire révolutionner le marche mobile: c'est un échec assourdissant. Broadwell est si en retard qu'il n'y a que les petits portables qui peuvent etre equipés, il risque de ne jamais y avoir de broadwell en dehors, Intel passant directement a Skylake. Et les performances de broadwell signent une stagnation incontestable. On constate tous que le passage a Broadwell des plus petits Mac est anecdotique: pour qu'Apple mentionne cette mise a jour il a fallut parler d'autres technologies. Les Mac concernés sont un peu plus rapides grâce a des fréquences un peu plus élevées, ben oui c'est logique fréquence plus élevée = vitesse supérieure. Apple aurait mis des Haswell avec le meme gain de frequence, on aurait eu le meme gain de vitesse... Apple n'aurait juste pas pu monter autant le prix de ses machines. Mais en fait on s'en fout. D'ailleurs les quelques lecteurs de ce forum, majoritairement j'ai l'impression, se contrefichent totalement de que ce tu peux raconter et n'ont aucun intérêts dans tes propos. Pas plus que dans les miens. La seule chose qui leur importe c'est pour une partie de savoir s'ils ont un intérêt a acheter cette génération 2015. Et ce que tout le monde leur dis, c'est que non, ces machines ne sont pas meilleures que celles d'il y a 2ou 3 ans pour l'utilisation qu'ils en ont. C'est tout. Et ça s’arrête la. Que je donne quelques infos, fasse des remarques, conteste la propagande d'Intel pour la remettre face a la réalité, ce qui va intéresser un peu quelques uns c'est le débat technique et les connaissances que ca peut véhiculer. En dehors d'un argumentaire technique que n'importe qui pourrait tenir, tes propos a ce niveau n'ont pas la moindre importance. Ce message a été modifié par r@net54 - 15 Mar 2015, 12:56. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

15 Mar 2015, 12:44 15 Mar 2015, 12:44

Message

#6

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 12 576 Inscrit : 25 Nov 2001 Membre no 1 397 |

Le fait dont il est question ici c'est qu'Intel est pris une fois de plus en défaut sur sa propagande face a la réalité. On constate tous que le x86 n'est plus capable de monter en puissance, que la débauche technologique et financière d'Intel aboutie a un surplace incontestable. Broadwell est un échec a divers niveaux pour Intel, qui a pourtant investit de manière colossale. Le passage de 22nm a 14nm n'apporte vraiment pas grand chose, et surtout en regard des investissement qui ont été nécessaire pour sa mise en place. Intel se retrouve aujourd'hui en concurrence direct et frontal avec Samsung: TSMC et GF ne sont pas loin... Tous constatent que la conjecture de Moore a atteint son terme. Ce constat est faussé et la loi de Moore n'a aucun sens. Le x86 ne monte plus en puissance parce que aujourd'hui le marché est différent et Intel doit s'adapter. Ce sont les puces économes qui se vendent de nos jours. ARM doit monter en puissance en restant dans le même ordre de consommation. Intel doit faire l'inverse, baisser la consommation sans perdre en puissance. La loi de Moore avait pour but de servir de base pour le marché. Ce message a été modifié par zero - 15 Mar 2015, 12:56. |

|

|

|

15 Mar 2015, 15:10 15 Mar 2015, 15:10

Message

#7

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Le fait dont il est question ici c'est qu'Intel est pris une fois de plus en défaut sur sa propagande face a la réalité. On constate tous que le x86 n'est plus capable de monter en puissance, que la débauche technologique et financière d'Intel aboutie a un surplace incontestable. Broadwell est un échec a divers niveaux pour Intel, qui a pourtant investit de manière colossale. Le passage de 22nm a 14nm n'apporte vraiment pas grand chose, et surtout en regard des investissement qui ont été nécessaire pour sa mise en place. Intel se retrouve aujourd'hui en concurrence directe et frontale avec Samsung: TSMC et GF ne sont pas loin... Tous constatent que la conjecture de Moore a atteint son terme. Ce constat est faussé et la loi de Moore n'a aucun sens. Le x86 ne monte plus en puissance parce que aujourd'hui le marché est différent et Intel doit s'adapter. Ce sont les puces économes qui se vendent de nos jour. ARM doit monter en puissance en restant dans le même ordre de consommation. Intel doit faire l'inverse, baisser la consommation sans perdre en puissance. La loi de Moore avait pour but de servir de base pour le marché. Ben la conjecture de Moore a servi de base pour de développement des x86 depuis 1975. En 1965 Moore, cofondateur d'Intel constate que la complexité des semiconducteur double a cout constant tous les ans. En 1975, trois an après l'apparition du microprocesseur, rendu possible par le transistor, Moore predit que le nombre de transistors dans le microprocesseur double tous les 18 mois, et de fait que la puissance du processeur liée au nombre de transistors subissait la même croissance. Donc en miniaturisant les transistors, on augmente la puissance en gardant le même cout. Le corolaire c'est que l'on peut augmenter la vitesse de traitement en augmentant la fréquence, et puisque la densité augmente, la fréquence peut augmenter dans le même ordre, se disait on alors... C'est effectivement la feuille de route d'une stratégie industrielle et commerciale qui s'est installée dans un monopole partagé entre Intel et Microsoft: Wintel. Moore avait prédit que la miniaturisation des transistors tomberait sur un "mur" physique aux environs de 2015. Sauf que le mur a ete atteint en 2004 en ce qui concerne la montee en frequence. Et la grosse epine dans ce dogme omniprésent a ete le développement du mobile, totalement rate par le x86(efficacite energetique), et surtout l’avènement du GPGPU(puissance de calcul), qu'Intel a aussi totalement raté avec Larrabee. Maintenant, si tu parles des évolutions technologiques en profondeur, il est vrai que le x86 rénové par AMD avec le passage a l'architecture 64bits et le passage a un moteur RISC, tout comme la parallélisation du traitement (pipeline/reordonnancement) ont changé la donne et ont modéré le principe de la conjecture de Moore pour la maintenir jusqu'a 2014. Ensuite la conjecture de Moore ne vaut que dans le monde x86. Dans le monde RISC les principes fondateurs sont différentes depuis le debut. On voit dans le monde ARM une croissance de la puissance qui s'opere avec au pire un maintien de la consommation et au mieux une diminution de cete comssomation. Et d'apres ARM la marge de progression pour les deux axes est encore conséquente comme le démontre le cortex A72 (-75%). Tu constates que le x86 ne monte plus réellement en puissance, on est tous d'accord. La ou les avis divergent c'est sur les causes. Je fais partie de ceux qui pensent que le x86 ne peut plus monter en puissance a cause des principes de fondement de son architecture, même si celle-ce a ete bien revue, notamment par AMD et aussi avec l'adoption du Finfet en 2011 par Intel. Le Finfet c'est un travail d'architecture sur le transistor pour augmenter son efficacité énergétique (plus de 35% de vitesse pour 2 fois moins d’énergie: certains estiment que c'est la plus importante évolution dans les processeurs depuis 40ans) On constate aussi que le besoin de puissance est toujours présent, même s'il n'est plus focalisé sur le CPU, mais va sur le GPU, le vectoriel, le traitement des ES, le traitement de signal,... tout ca realisé par des unités spécialisées utilisant des architectures différentes de celles du CPU: les coprocesseurs, qu'ils soient integres au SoC ou repartis sur la CM. Par contre l’efficacité énergétique est devenue une priorite. Pourquoi? On donne souvent comme argument que c'est face a la crise énergétique dans laquelle on s'engage. D'autres rapportent que c'est a cause de la miniaturisation des appareils. C'est deux arguments sont recevables, mais ne justifient pour autant pas l’arrêt de la croissance de la puissance... sauf sur les systèmes qui sont originellement et fondamentalement mauvais sur l’efficacité énergétique. Ils n'ont comme alternatives que de figer leur puissance en essayant d'etre énergétiquement plus rentable: en multipliant les core et en gerant plus finement l'alimentation en fonction des besoins reels, il y a une diminution de la consommation non negligeable pour le meme traitement: en gros si au lieu d'eclairer toute la ville en permanence on éclaire que les zone ou il y a des gens, on gagne en consommation... Bien sur l'autre solution c'est d'installer des ampoules LED qui elles sont tres efficaces énergétiquement... Je vais d'ailleurs prendre l'exemple de l'ampoule a incandescence: 95% de la production de ce type d'ampoule c'est de ... la chaleur! Donc plus on veut de puissance d’éclairage plus l'ampoule va dégager de chaleur et le filament va perdre de la matière. C'est typiquement mauvais en efficacité énergétique. Et on arrive a un parallèle assez intéressant: plus on veut de lumière plus il faut que la piece soit grande pour absorber la chaleur produite, et forcement si on a une pièce plus grande, il faut plus de lumière pour l’éclairer, et ainsi de suite. La solution c'est de ventiler, sauf que la aussi il y a des limites... Fondamentalement le x86 est par principe mauvais en efficacité énergétique, du fait qu'il s'appuie sur la conjecture de Moore, ce qui pourrait revenir -en reprenant l'exemple de l'ampoule a incandescence- a dire que pour augmenter la production lumineuse on augmente la puissance électrique, le filament doublant sa résistance a l’évaporation tous les 18 mois... L'exemple de ca c'est typiquement le P4. Intel n'avait pas de difficultés pour faire progresser sa puissance, il suffisait d'augmenter la densité de transistor et monter la fréquence. L'equation etait d'ailleurs encore simple pour le marketing: augmentation de fréquence = croissance de puissance. Sauf que ce principe a atteint un mur physique: celui de la gestion de la production thermique. Si les processeurs sont limités a 4Ghz c'est pas un chiffre qui est tombé comme ca de manière arbitraire: les causes sont des lois physiques. A partir de ce constat il a fallut changer de stratégie et commencer a s'adapter a la notion d’efficacité énergétique. En plus de cela les physiciens commencent a définir que seuls les systèmes physiques qui disposent d'une bonne efficacité énergétique intrinsèques peuvent durer et se développer. Intel étant soumis maintenant a une vraie concurrence, il faut qu'il fasse évoluer son système vers l’efficacité énergétique: très gros défi vu les bases de départ, mais c'est une question de survie. Ce message a été modifié par r@net54 - 15 Mar 2015, 15:21. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

15 Mar 2015, 15:56 15 Mar 2015, 15:56

Message

#8

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

et surtout l’avènement du GPGPU(puissance de calcul), qu'Intel a aussi totalement raté avec Larrabee. Larrabee à la base, c'était un projet qui visait à faire un GPU à base de x86 (il y avait des pilotes DirectX et OpenGL...). C'est suite à l'échec de ce projet qu'Intel a décidé, plutôt que de tout jeter, de le réorienter vers un concurrent du GPGPU : c'est ainsi qu'est né le Xeon Phi, qui reprend les principes de Larrabee et qui sert à la même chose que le GPGPU. La seule chose qui a été abandonnée par rapport à Larrabee, c'est en fait la possibilité d'utiliser la puce comme un GPU... On ne peut donc pas considérer Larrabee comme un ratage total sur le GPGPU, alors qu'aujourd'hui une carte d'accélération basée directement sur les travaux du projet Larrabee permet justement à Intel de contrer efficacement le GPGPU dans le HPC. À tel point que c'est grâce à ce descendant de Larrabee que, pour la première fois de l'histoire du Top 500, une machine dont toute la puissance de calcul provenait de puces Intel est arrivée en tête du classement en juin 2013, et n'a plus quitté cette place depuis (et ça aussi, je crois que c'est une première, une machine qui reste en première position sur 4 classements de suite SANS modification de sa configuration matérielle (IBM avait eu 6 ou 7 premières place de suite avec BlueGene, mais c'était en ajoutant régulièrement des processeurs, la machine était passée de 65 000 cœurs à plus de 200 000)...Maintenant, si tu parles des évolutions technologiques en profondeur, il est vrai que le x86 rénové par AMD avec le passage a l'architecture 64bits et le passage a un moteur RISC, tout comme la parallélisation du traitement (pipeline/reordonnancement) Sauf que comme on te l'a déjà expliqué, le décodage des instructions x86 en micro-ops avant leur injection dans le pipeline est arrivé bien avant le 64 bits (2002), aussi bien chez Intel (Pentium Pro, 1995) que chez AMD (K5, 1996).Et clairement, aujourd'hui ces micro-ops ne peuvent pas être considérées comme du RISC, c'est plutôt du VLIW, depuis qu'Intel a introduit la fusion de micro-ops (avec le Pentium M, repris plus tard par AMD de façon très limitée dans le K8, puis plus complète dans le K9). De même pour le pipeline et l'exécution out-of-order, ce n'est pas AMD qui a introduit ça dans le x86. Le 8086, c'est-à-dire le tout premier CPU x86, il avait déjà un pipeline (en fait, j'aimerais bien un exemple de processeur sans pipeline... je ne pense pas que ça existe), et le premier x86 conçu par AMD était l'Am386 (avant, AMD utilisait directement les micro-architecture Intel sous licence), des années plus tard. Pour l'out-of-order, le premier x86 à le faire était le Pentium Pro, en 1995, suivi par l'AMD K5 en 1996 (qui est du coup le premier x86 grand-public à le faire, mais pas le premier x86... chez Intel c'est arrivé chez le grand public avec le Pentium II, basé sur le Pentium Pro, en 1997). Quand à la parallélisation en interne, avec les pipelines superscalaires, c'est aussi Intel qui l'a introduit sur le x86, avec le Pentium, en 1993, AMD a attendu 96 avec le K5. Et c'est d'ailleurs pareil sur les CPU ARM les plus performants, qui ont aussi adopté le décodage en micro-ops suivi d'une fusion de micro-ops et atteignent un niveau de complexité qui n'a plus rien à voir avec ce que prône le RISC (un cœur Apple Cyclone, c'est aujourd'hui plus complexe qu'un cœur Intel Atom : l'analyse de la surface des cœurs démontre clairement que le cœur Cyclone utilise plus de transistors que le cœur Atom, et ce malgré une quantité de cache moindre...). C'est deux arguments sont recevables, mais ne justifient pour autant pas l’arrêt de la croissance de la puissance... La croissance de la puissance n'a pas été arrêtée, sur les marchés où il y a encore une forte demande pour de la puissance supplémentaire : serveurs et datacenter.Sur le marché du PC, la demande pour plus de puissance c'est clairement tassée, depuis un moment. Parce qu'on a aujourd'hui des CPU qui répondent aux besoins de 99% des gens sans ralentissements. Je me souviens que quand j'ai commencé à m'intéresser à l'informatique, je changeais régulièrement de CPU, en prenant toujours le plus haut de gamme. Je ne changeais pas parce qu'il y avait plus puissant que ce que j'avais, mais parce que j'avais "besoin" de plus puissant, ce que je ressentais régulièrement à l'usage. Maintenant, je change pour réduire la consommation, et je ne prends même plus les puces les plus haut de gamme, car je sais que je n'ai absolument pas besoin du supplément de puissance qu'elles apportent... Tu me proposerais aujourd'hui un processeur deux fois plus rapide que le mien pour la même efficacité énergétique, ça ne m'intéresserait pas de le changer (de fait, ça existe du x86 deux fois plus performant que le mien, et non, ça ne m'intéresse pas de changer... je changerais peut-être dans deux ou trois ans...). Parce que je ne vois pas dans quel usage ça m'apporterait quelque chose. Même mon portable, beaucoup moins puissant que mon PC de bureau, me suffit en fait dans l'écrasante majorité des cas ! Et ce tassement de la demande de puissance ne concerne d'ailleurs pas que les CPU des PC, c'est aussi le cas sur les GPU (aujourd'hui avec un GPU milieu de gamme de 2-3 ans, tu fais tourner tous les jeux avec une bonne qualité, il y a dix ans c'était vraiment pas le cas), sur les mobiles... Fondamentalement le x86 est par principe mauvais en efficacité énergétique Sauf que aujourd'hui des solutions x86 sont régulièrement plus efficaces énergétiquement que des solutions à base d'ARM. Il n'y a que sur les CPU les moins performants qu'ARM arrive à surpasser l'efficacité énergétique du x86...Tiens par exemple, puisque l'autre jour tu vantais les mérites du X-Gene sur les serveurs, qui menacerait selon toi Intel, voici ce que ça donne niveau efficacité énergétique : http://www.anandtech.com/show/8357/explori...er-platforms/17 Le X-Gene offre les performances d'un Atom C pour deux fois et demi sa consommation, tandis que le Xeon E3-1230L a une efficacité énergétique près de 3 fois supérieure à celle du X-Gene... Tu parles d'une menace ^^ De même, si tu regardes ce qu'un Core M est capable de sortir comme performances avec une enveloppe thermique de 5W et si tu compares ça à ce que sort un SoC ARM haut de gamme, avec là aussi une enveloppe thermique qui approche aujourd'hui les 5W, voir la dépasse, ça ne fait aucun doute que l'efficacité énergétique est supérieure sur le Core M. Tiens, quelques chiffres de consommation à la prise mesurés à l'instant avec des appareils Android exécutant BOINC à 100% de charge CPU, écran éteint et batterie chargée, tous branchés au chargeur du Nexus 6 (sauf la TF701T qui a besoin de son chargeur propriétaire) : - 9.3W la tablette TF701T en Tegra 4 - 10.3W pour le Nexus 6 en Snapdragon 800 (et ça tombe à 8.3 quand il se met à faire du throttling parce que la température dépasse largement les limites du raisonnable et qu'on se retrouve avec un cœur à l'arrêt et un au 2/5 de sa fréquence) - 5.1W avec la Nexus 7 2013 en Snapdragon S4 Pro - 1.7W pour le Moto G 2013 en Snapdragon 400 Bien sûr on peut sans doute enlever 10-30% à cause du rendement du transfo, mais ça reste quand même des consommations élevées, on est loin des SoC ARM haut de gamme 2-3W d'il y a quelques années, des niveaux de consommation qu'on ne trouve plus que sur l'entrée de gamme aujourd'hui... -------------------- |

|

|

|

Les messages de ce sujet

Lionel Les performances des nouveaux MacBook Pro et Air 14 Mar 2015, 07:16

Lionel Les performances des nouveaux MacBook Pro et Air 14 Mar 2015, 07:16

SartMatt Citation (r@net54 @ 15 Mar 2015, 12:21) M... 15 Mar 2015, 13:12

SartMatt Citation (r@net54 @ 15 Mar 2015, 12:21) M... 15 Mar 2015, 13:12

r@net54 Citation (SartMatt @ 15 Mar 2015, 13:12) ... 15 Mar 2015, 16:26

r@net54 Citation (SartMatt @ 15 Mar 2015, 13:12) ... 15 Mar 2015, 16:26

SartMatt Citation (r@net54 @ 15 Mar 2015, 16:26) M... 15 Mar 2015, 16:49

SartMatt Citation (r@net54 @ 15 Mar 2015, 16:26) M... 15 Mar 2015, 16:49

Eagle Kiss Citation (r@net54 @ 15 Mar 2015, 12:21) L... 15 Mar 2015, 14:15

Eagle Kiss Citation (r@net54 @ 15 Mar 2015, 12:21) L... 15 Mar 2015, 14:15

GregWar Citation (r@net54 @ 14 Mar 2015, 13:36) D... 15 Mar 2015, 09:08

GregWar Citation (r@net54 @ 14 Mar 2015, 13:36) D... 15 Mar 2015, 09:08

Bicougnot Pourquoi n'y a-t-il pas sur les graphes le MBA... 14 Mar 2015, 10:43

Bicougnot Pourquoi n'y a-t-il pas sur les graphes le MBA... 14 Mar 2015, 10:43

Beaubarre Citation (Bicougnot @ 14 Mar 2015, 10:43)... 14 Mar 2015, 11:44

Beaubarre Citation (Bicougnot @ 14 Mar 2015, 10:43)... 14 Mar 2015, 11:44

Anozer Par contre les MBP 15" n'ont eu aucune mi... 14 Mar 2015, 11:08

Anozer Par contre les MBP 15" n'ont eu aucune mi... 14 Mar 2015, 11:08

wiiish Bonjour, j'aimerais comprendre si quelqu'u... 14 Mar 2015, 13:37

wiiish Bonjour, j'aimerais comprendre si quelqu'u... 14 Mar 2015, 13:37

r@net54 Citation (wiiish @ 14 Mar 2015, 14:37) Bo... 14 Mar 2015, 14:45

r@net54 Citation (wiiish @ 14 Mar 2015, 14:37) Bo... 14 Mar 2015, 14:45

GregWar Citation (wiiish @ 14 Mar 2015, 13:37) Bo... 15 Mar 2015, 09:36

GregWar Citation (wiiish @ 14 Mar 2015, 13:37) Bo... 15 Mar 2015, 09:36

Mayeric @bicougnot :

Lors de la maj des MacBook Air de 20... 14 Mar 2015, 14:04

Mayeric @bicougnot :

Lors de la maj des MacBook Air de 20... 14 Mar 2015, 14:04

Montréal A l'utilisation on ne sentira aucunement ce ga... 14 Mar 2015, 14:12

Montréal A l'utilisation on ne sentira aucunement ce ga... 14 Mar 2015, 14:12

Bug Citation (Montréal @ 14 Mar 2015, 14:12)... 14 Mar 2015, 15:07

Bug Citation (Montréal @ 14 Mar 2015, 14:12)... 14 Mar 2015, 15:07

Mayeric @r@net:

Merci je partage entièrement ton point d... 14 Mar 2015, 14:57

Mayeric @r@net:

Merci je partage entièrement ton point d... 14 Mar 2015, 14:57

Eagle Kiss Citation (r@net54 @ 14 Mar 2015, 14:45) F... 14 Mar 2015, 19:40

Eagle Kiss Citation (r@net54 @ 14 Mar 2015, 14:45) F... 14 Mar 2015, 19:40

wiiish @Mayeric : Merci pour ta réponse ! Tu confirm... 14 Mar 2015, 14:59

wiiish @Mayeric : Merci pour ta réponse ! Tu confirm... 14 Mar 2015, 14:59

fluorgasmic @Bug

Nope -> il y avait le connecteur du char... 14 Mar 2015, 19:02

fluorgasmic @Bug

Nope -> il y avait le connecteur du char... 14 Mar 2015, 19:02

jérôme b Attendons les tests des parties graphiques de ces ... 14 Mar 2015, 23:03

jérôme b Attendons les tests des parties graphiques de ces ... 14 Mar 2015, 23:03

SartMatt Citation (jérôme b @ 14 Mar 2015, 23:03... 14 Mar 2015, 23:11

SartMatt Citation (jérôme b @ 14 Mar 2015, 23:03... 14 Mar 2015, 23:11

Alias Personnellement, je viens de vendre mon MBA 4/128 ... 15 Mar 2015, 09:51

Alias Personnellement, je viens de vendre mon MBA 4/128 ... 15 Mar 2015, 09:51

Dreaming Comme s'il allait s'abaisser à ça... 15 Mar 2015, 19:41

Dreaming Comme s'il allait s'abaisser à ça... 15 Mar 2015, 19:41

Eagle Kiss Moi je pense que votre différent est récurrent e... 15 Mar 2015, 19:43

Eagle Kiss Moi je pense que votre différent est récurrent e... 15 Mar 2015, 19:43

bricoleur Moi, j'ai une question basique (excusez de n... 15 Mar 2015, 20:43

bricoleur Moi, j'ai une question basique (excusez de n... 15 Mar 2015, 20:43

SartMatt Citation (bricoleur @ 15 Mar 2015, 20:43)... 15 Mar 2015, 21:03

SartMatt Citation (bricoleur @ 15 Mar 2015, 20:43)... 15 Mar 2015, 21:03

bricoleur Merci pour l'explication (plus puissant Vs ... 15 Mar 2015, 22:13

bricoleur Merci pour l'explication (plus puissant Vs ... 15 Mar 2015, 22:13

iAPX Tout ça pour quoi?!?

Finalement les performa... 15 Mar 2015, 22:26

iAPX Tout ça pour quoi?!?

Finalement les performa... 15 Mar 2015, 22:26

SartMatt Citation (iAPX @ 15 Mar 2015, 22:26) Fina... 15 Mar 2015, 22:54

SartMatt Citation (iAPX @ 15 Mar 2015, 22:26) Fina... 15 Mar 2015, 22:54

zero Citation (r@net54 @ 15 Mar 2015, 23:10) F... 16 Mar 2015, 04:37

zero Citation (r@net54 @ 15 Mar 2015, 23:10) F... 16 Mar 2015, 04:37

Lionel Citation (zero @ 16 Mar 2015, 04:37) Cita... 16 Mar 2015, 17:48

Lionel Citation (zero @ 16 Mar 2015, 04:37) Cita... 16 Mar 2015, 17:48

Webtourist J'attends surtout le test de performances du n... 16 Mar 2015, 12:21

Webtourist J'attends surtout le test de performances du n... 16 Mar 2015, 12:21

SartMatt Citation (Webtourist @ 16 Mar 2015, 12:21... 16 Mar 2015, 15:12

SartMatt Citation (Webtourist @ 16 Mar 2015, 12:21... 16 Mar 2015, 15:12

Bug Citation (Webtourist @ 16 Mar 2015, 12:21... 16 Mar 2015, 17:43

Bug Citation (Webtourist @ 16 Mar 2015, 12:21... 16 Mar 2015, 17:43

Webtourist Citation (Bug @ 16 Mar 2015, 17:43) Citat... 17 Mar 2015, 13:15

Webtourist Citation (Bug @ 16 Mar 2015, 17:43) Citat... 17 Mar 2015, 13:15  |

1 utilisateur(s) sur ce sujet (1 invité(s) et 0 utilisateur(s) anonyme(s))

0 membre(s) :

| Nous sommes le : 29th December 2025 - 14:03 |