Bienvenue invité ( Connexion | Inscription )

15 Jan 2015, 23:55 15 Jan 2015, 23:55

Message

#1

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 531 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

A plusieurs reprises nous vous avons rapporté de source très fiables qu'Apple avait dans ses cartons des prototypes totalement fonctionnels de Mac dotés de processeurs ARM.

Un célèbre analyste appelé Ming-Chi Kuo y croit. Mais pour lui, et nous sommes d'accord, Apple n'a pas l'intention de sortir ces machines dans un avenir proche. La société pourrait attendre au moins un an ou deux pour se lancer et prendre un des plus gros paris de son histoire récente. Toujours selon ses informations, Apple aurait besoin de ce temps pour que ses puces ARM soient capables de concurrencer un processeur Core i3 ou un Atom. Cela permettrait à la société de proposer toute une entrée de gamme ARM, le reste devant continuer à tourner sur des processeurs Intel. Cela introduit l'idée qu'Apple puisse avoir deux gammes de Mac avec deux architectures radicalement différentes. Ce serait difficile à gérer et même Microsoft qui avait deux modèles de tablettes Surface, une ARM et une x86 a fini par jeter l'éponge sur le premier modèle, se focalisant sur le second. En effet, on aurait alors des Mac pouvant faire tourner certains logiciels, chose dont les autres modèles ne seront pas capables, un vrai casse-tête même au niveau commercial. Certes, certains imagineront à nouveau un miracle Rosetta mais nous vous rappelons qu'Apple avait réussi ce pari de l'émulation en remplaçant dans tous ses modèles un processeur G4 ou G5 par deux coeurs x86 déjà plus puissants individuellement. Or, il serait aujourd'hui certes possible de proposer un processeur ARM doté de 8 ou 16 cœurs puissants, mais il aurait alors une consommation supérieure à son pendant chez Intel, ce qui réduirait de manière totale son intérêt. Lien vers le billet original -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

|

Réponse(s)

16 Jan 2015, 21:45 16 Jan 2015, 21:45

Message

#2

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 863 Inscrit : 7 Feb 2012 Membre no 174 401 |

Cela introduit l'idée qu'Apple puisse avoir deux gammes de Mac avec deux architectures radicalement différentes. Ce serait difficile à gérer et même Microsoft qui avait deux modèles de tablettes Surface, une ARM et une x86 a fini par jeter l'éponge sur le premier modèle, se focalisant sur le second. Microsoft a sorti une tablette ARM tout comme Apple a sorti une tablette ARM Dans le cas d'Apple, le monde entier a applaudi des deux mains en félicitant IOS et ses nouvelles applications, et personne, oui, personne, ne s'est émeu que les tablettes iOS ne puissent faire tourner la logithèque OS X Dans le cas de Microsoft, la majorité des gens, et même les plus intelligents et les plus informés, se sont tiraillés de douleur et d'incompréhension comme quoi la surface RT était incapable de faire tourner la logithèque Windows x86 C'est surtout pour ça que Microsoft a jeté l'éponge ... enfin aussi parcequ'en même temps ils ont sorti une surface Pro qui elle était sous x86 avec un vrai Windows, du coup c'était incompréhensible pour les consommateurs. Si Apple avait sorti un iPad PRO sous x86 avec OSX en même temps que l'ipad, ce dernier n'aurait surement pas connu le succès qu'il a eu, et, surtout, les tablettes ne seraient que des ordinateurs sans clavier et avec un stylet, ce qui est, rappelons le, une hérésie Conclusion : la surface Pro est une hérésie -------------------- Machine principale : [NEW] MacBook Pro 14", M1Max / 32Go RAM / 2To SSD 😍😍😍😍 + Ecran Pro Display 32'' 😍😍😍😍😍😍😍😍

Machine complémentaire : Ipad Pro 2020, 11", 256Go + Magic Keyboard 😍😍😍 |

|

|

|

17 Jan 2015, 18:05 17 Jan 2015, 18:05

Message

#3

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

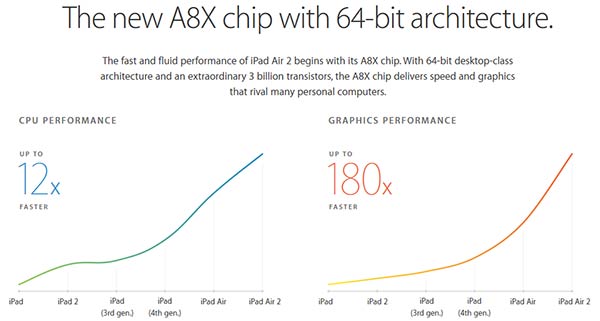

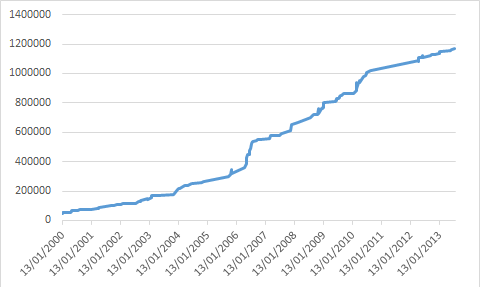

Cela introduit l'idée qu'Apple puisse avoir deux gammes de Mac avec deux architectures radicalement différentes. Ce serait difficile à gérer et même Microsoft qui avait deux modèles de tablettes Surface, une ARM et une x86 a fini par jeter l'éponge sur le premier modèle, se focalisant sur le second. Microsoft a sorti une tablette ARM tout comme Apple a sorti une tablette ARM Dans le cas d'Apple, le monde entier a applaudi des deux mains en félicitant IOS et ses nouvelles applications, et personne, oui, personne, ne s'est émeu que les tablettes iOS ne puissent faire tourner la logithèque OS X Dans le cas de Microsoft, la majorité des gens, et même les plus intelligents et les plus informés, se sont tiraillés de douleur et d'incompréhension comme quoi la surface RT était incapable de faire tourner la logithèque Windows x86 C'est surtout pour ça que Microsoft a jeté l'éponge ... enfin aussi parcequ'en même temps ils ont sorti une surface Pro qui elle était sous x86 avec un vrai Windows, du coup c'était incompréhensible pour les consommateurs. Si Apple avait sorti un iPad PRO sous x86 avec OSX en même temps que l'ipad, ce dernier n'aurait surement pas connu le succès qu'il a eu, et, surtout, les tablettes ne seraient que des ordinateurs sans clavier et avec un stylet, ce qui est, rappelons le, une hérésie Conclusion : la surface Pro est une hérésie C'est en partie vrai, mais il reste aussi un élément marketing majeur qui est la rentabilité lie au prix de vente. Aujourd'hui la production de tablettes ARM est très rentable pour Apple, qui maitrise la totalité du matériel, rentable pour Samsung (en tout cas sur les modèles 9"), peut être rentable pour Lenovo et éventuellement Asus, qui peuvent se permettre de vendre avec une belle marge leurs tablettes. Pour les autres c'est comme les smartphones, c'est difficilement rentable. Pourquoi les fabricants essayent dans ces conditions d'etre a tout prix (c'est le cas de le dire) sur le marche mobile: parce que le marche PC est en récession et que le mobile semblait être la releve avec des croissances inconnues depuis des années. QU'importe alors de vendre a perte, l'important était de se faire une place et de capturer une PDM pour garder des clients captifs: veille recette du onde PC Wintel. On voit Intel avec le meme raisonnement qui est oblige de gérer des pertes colossales liees aux Atom. Si Intel maintient cette machine a perdre de l'argent depuis 2008, et que chaque année il lui faut "acheter" un peu plus cher des PDM artifielement, c'est parce qu'Intel a tout a perdre si la société n'arrive pas a se faire meme une peine place sur le mobile. Aujourd'hui on estime qu'un Atom est "vendu" entre $3 et $5 pour concurrencer les processeurs ARM. Le hic c'est qu'a $5 une ARM est rentable, un Atom c'est a partir de $30 pour les plus petits modèle et ça monte a près de $100, surtout si on compte que pour Intel faut budgeter les efforts monstrueux de la société nécessaire pour faire évoluer les Atom (ne serait ce pour passer en 64 bits - ça a l'air de rien comme ça mais c'est loin d'être simple, y a qu'a voir les difficultés de Qualcomm avec son 810…). Mais l'Atom, meme a ce prix plus que bradé, reste une déception et il faut qu'Intel "subventionne" les Atom directement pour les fabricants, notamment en participant largement a la R&D, l'industrialisation, voire meme en achetant des stock entier de produit fini pour en garantir le prix de vente… Alors oui on voit quelques produits motorises avec des Atom, mais il s'agit d'une goutte d'eau lorsque l'on compare a la masse de produits ARM, et le gros problème pour Intel c'est que les performances des ARM grimpent en meme temps que le prix d'achat des ARM diminue: on voit les fondeurs chinois qui aujourd'hui produisent de l'A9 et de l'A17 a des couts défiants toute concurrence, permettant de sortir des mini PC sous les $100 et des tablettes 9" sous les $150, et cela en garantissant des marges… Donc Microsoft est dans ces conditions dans une position délicate. C'est pas que la société soit incapable de vendre a perte pour se faire une grosse PDM, c'est le cas de tout ses produits, a part les clavier/souris. Mais la situation avec la tablette AMR était très différente a cause de la forte concurrence. Microsoft comme Intel sont des sociétés qui ont un modèle économique base sur le monopole et la position dominante. Tout le système de Microsoft est organise autour de la dépendance a Windows, et tout nouvel élément doit renforcer cette dépendance. Avec la tablette ARM, Microsoft a fait une erreur majeure en terme de marketing. La tablette, n'ayant pas été financee suffisamment et peut être pour ne pas se mettre complètement a dos Intel, est sortie sans être compatible avec le marche Windows. Microsoft a donc sorti une machine nouvelle avec un OS nouveau et innovant, face aux leader du marches: iOS et Android. Sans la sacro-sainte retrocompatibilite qui est le dogme de Wintel, la Surface restait un outsider qui devait démontrer une supériorité et un intérêt économique face a l'écosystème iOS et a l'hypeconcurence Android… Microsoft, se rendant compte de ça a préféré je ter l'éponge et abandonner le secteur de la tablette. On le constate, la Surface Pro n'est pas vendu comme une tablette, ni meme un TabletPC, mais comme un Ultrabook. C'est finement joue, car ça permet a Microsoft un positionnement tarifaire eleve et ça evite les comparaisons performances/autonomies des univers Android et iOS. Les Surfaces Pro sont comparees donc a des Ultrabook, voire des portables, qui font tourner Windows! Microsoft a vu juste dans ce rattrapage marketing, on le voit face a la domination indéboulonnable d'iOS et Android. Apres, Microsoft a aussi couvert ses arrière. Se lancer dans la conception d'une tablette ARM voulait dire soit attaquer les performances des machines d'Apple et de Samsung, soit se battre sur les tarifs des chinois. Microsoft était incapable de faire l'un ou l'autre et conserver sa position dans le train de sénateur motorise par Intel était une solution raisonnable. Maintenant le souci c'est qu'Intel n'arrive toujours pas apres des années de guerre économique a surpasser ARM et qu'ARM commence a devenir présent dans tous les secteurs informatique, depuis l'embarque jusqu'au HPC. Pire encore, si on reste dans le monde mobile, on voit que non seulement la puissance des processeur a une croissance qui fait rêver le x86, mais que cela se fait en meme temps que l'optimisation énergétique progresse aussi. Du cote du x86 la puissance de calcule brute stagne apres une forte progression jusqu'en 2005:  Du cote ARM c'est l'inverse, et on le voit notamment avec les processeurs équipant les iPhone et iPad:  Et Apple n'est pas le meilleur en terme de puissance. NVIdia qui vient de pressente de Tegra x1, explose les performances de tout le reste.  Le monde ARM est donc dans une course a la puissance et a l'efficacité énergétique soutenu par une concurrence très dynamique. Si le passage aux 64bit a représente une pose dans cette course a la puissance, cela va repartir de plus belle maintenant. Pire encore pour Intel, si on regarde la courbe de progression de puissance du GPGPU, puissance de calcul brute, on voit que c'est la aussi la courbe est fortement au désavantage du x86.  On le constate, la sortie du tout x86 est surtout liee a des réalités technologiques et puisqu'Intel s'entête a stagner en voulant conserver le juteux monopole etablit sur l'archaïque x86, le marche lui passe a des solutions qui offrent des perspectives d'avenir. Et cela est a l'avantage du client, qui se retrouve avec un matériel innovant, soutenu par une concurrence dynamique et qui a aujourd'hui le choix de pouvoir opter pour l'éditeur/constructeur qui lui offre le meilleur outil. Ce message a été modifié par r@net54 - 17 Jan 2015, 18:16. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

17 Jan 2015, 18:55 17 Jan 2015, 18:55

Message

#4

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

On voit Intel avec le meme raisonnement qui est oblige de gérer des pertes colossales liees aux Atom. [...] Le hic c'est qu'a $5 une ARM est rentable, un Atom c'est a partir de $30 pour les plus petits modèle et ça monte a près de $100 Attention, la gamme Atom ne se limite pas aux mobile... La division mobile est déficitaire, mais ce déficit est probablement en grande partie compensée par les bénéfices faits avec les différents dérivés du Bay Trail sur PC et serveurs (il y a des puces Bay Trail qui dépassent les 150$ : 171$ pour l'Atom C2750, 161$ pour le Pentium N3540...).Quand à la rentabilité, tu délires... 100$, c'est le prix de vente de certains Atom, pas leur seuil de rentabilité ! Et à l'inverse, il y a des Atom qui ne seraient clairement pas rentables à 5$ hein... Mais ce qui est certain, c'est qu'aujourd'hui le seuil de rentabilité d'un Atom est du même ordre de prix que celui d'un ARM équivalent : ce sont des puces du même ordre de complexité, qui nécessitent à peu près autant de silicium, il n'y AUCUNE raison valable que l'une revienne 6 à 20 fois plus cher (ce sont tes chiffres) que l'autre... surtout si on compte que pour Intel faut budgeter les efforts monstrueux de la société nécessaire pour faire évoluer les Atom (ne serait ce pour passer en 64 bits - ça a l'air de rien comme ça mais c'est loin d'être simple, y a qu'a voir les difficultés de Qualcomm avec son 810…) Où l'on découvre à quel point tu ne sais vraiment pas de quoi tu parles Depuis, tous les Atom sont 64 bits, même si le support du 64 bits n'est pas toujours activé, pour des raisons marketing. Et pareil avec les Pentium 4, le 64 bits est arrivé via une évolution mineure du Prescott. Il semblerait qu'en x86 le passage au 64 bits n'ait vraiment pas été une difficulté... Pas sûr que ça soit beaucoup plus compliqué dans le monde ARM. Les difficultés de Qualcomm sur le Snapdragon 810 ne viennent sûrement pas du 64 bits d'ailleurs, puisqu'ils ne conçoivent pas le cœur d'exécution (c'est du Cortex A57/A53), mais visiblement plutôt d'autres choses : peut-être le passage au 20nm (hypothèse la plus probable, vu que le retard serait lié à des problèmes de surchauffe, une conséquence classique d'une mauvaise maitrise d'un processus de gravure) ? le big.LITTLE ? ou encore l'une des nouvelles fonctions que vont gérer ce SoC (combinaison des images de deux caméras, Dolby Atmos, annulation de bruit de fond, WiGi à 4 Gbit/s, intégration de Shazam...). Donc Microsoft est dans ces conditions dans une position délicate. C'est pas que la société soit incapable de vendre a perte pour se faire une grosse PDM, c'est le cas de tout ses produits, a part les clavier/souris. Décidément, tu es en forme aujourd'hui pour débiter des âneries au kilomètre... Donc Microsoft vendrait tous ses produits à perte, sauf les claviers et souris ? La vache, ils doivent en vendre un sacré paquet pour arriver à éponger toutes les pertes des autres produits et faire en prime 22 milliards de bénéfice annuel Tout le système de Microsoft est organise autour de la dépendance a Windows, et tout nouvel élément doit renforcer cette dépendance. Donc quand Microsoft sort Office sur le web et sur iOS et Android par exemple, c'est pour renforcer la dépendance à Windows ? On le constate, la Surface Pro n'est pas vendu comme une tablette, ni meme un TabletPC, mais comme un Ultrabook. Oui, mais alors un ultrabook sans clavier et sans souris (vendus en option) et qui s'utilise avec un écran tactile... Je sais pas comment t'appelle ça, mais moi j'appelle ça une tablette...Maintenant le souci c'est qu'Intel n'arrive toujours pas apres des années de guerre économique a surpasser ARM et qu'ARM commence a devenir présent dans tous les secteurs informatique, depuis l'embarque jusqu'au HPC. Ça c'est ta vision étriquée des choses... La réalité, c'est qu'en 2014 Intel a repris beaucoup plus sur le mobile à ARM (Intel est devenu le second fournisseur de CPU pour tablettes hors Apple, derrière Qualcomm, et à peu près tout le monde s'accorde à dire qu'ils seront premier d'ici deux ou trois ans) qu'ARM n'en a repris à Intel sur les autres secteurs... Les ordinateurs portables et de bureau à ARM sont encore anecdotique (et malgré tout, ARM a réussi à perdre des parts sur le marché des laptops, avec les Chromebook qui reviennent sur du x86), et c'est à peine mieux sur les serveurs (où Intel a annoncé une croissance de 25% cette année), et encore pire sur le HPC (la part du x86 dans le top 500 est au plus haut, tandis qu'ARM n'y est toujours pas entré).Pire encore, si on reste dans le monde mobile, on voit que non seulement la puissance des processeur a une croissance qui fait rêver le x86 T'as peur de rien dis donc... Regarde l'évolution des performances des iPhone sur les 4/5 dernières années, ou celle des Nexus sur la même période, et tu verras un net infléchissement de la courbe de croissance en 2014 (valable aussi chez d'autres constructeurs bien sûr). C'est pas comme si je te l'avais déjà expliqué 40 fois Voilà par exemple les tests de Anandtech sur les Nexus 5/6 et iPhone 5S/6 : http://anandtech.com/show/8687/the-nexus-6-review/4 Gain moyen de la génération 2014 par rapport à la 2013 : 21.2% sur les Nexus, 28.3% sur les iPhone Et le test du même Anandtech sur les Nexus 4/5 et iPhone 5/5S : http://anandtech.com/show/7517/google-nexus-5-review/4 Gain moyen de la génération 2013 par rapport à la 2012 : 78.4% sur les Nexus, 64.9% sur les iPhone Et voilà pour les iPhone 4/4S/5 (dans le test du Nexus 4 chez Anand il y a trop peu de comparaisons avec le Galaxy Nexus) : http://anandtech.com/show/6330/the-iphone-5-review/10 Gain moyen de la génération 2012 par rapport à la 2011 : 107% sur les iPhone Gain moyen de la génération 2011 par rapport à la 2010 : 105% sur les iPhone On voit donc bien que la croissance qu'on a connu il y a quelques années n'est vraiment plus là. Tiens, comme sur x86... Et ça correspond exactement à ce que je prédisais déjà à l'époque : ARM progressait vite parce que ça venait de très loin, mais fini par se prendre un mur, comme toutes les autres architectures. Il n'y a pas de miracles, les autres architectures sont surtout limitées par la physique et ARM n'est pas au dessus des lois de la physique... Du cote du x86 la puissance de calcule brute stagne apres une forte progression jusqu'en 2005: Rhooo... Ce qui est chouette avec toi, c'est que comme tu nous ressors toujours les mêmes trucs bidons, il suffit de te redonner les réponses de l'époque (là et là)...http://i.pcworld.fr/1296385-superpi-32m-historique-hwbot.png Donc je te le répète, vu que ça ne veut pas rentrer : une courbe présentée comme ça amplifie fortement l'impression de stagnation, puisque forcément quand tu doubles les performances en passant de 6000 à 3000 secondes, ça donne l'impression d'un progrès visuelle d'un progrès beaucoup plus gros que quand tu doubles les performances quelques années plus tard en passant de 60 à 30s... Il suffit, plutôt que de faire la courbe du temps de calcul, de faire la courbe de la vitesse de calcul (les performances du CPU, c'est bien la vitesse de calcul, pas le temps de calcul), en décimales par seconde, pour se rendre compte que ce qui stagne, c'est ton argumentaire, pas la puissance de calcul des processeurs :  Et comme je te l'ai déjà maintes fois rappelé, Super Pi est un benchmark qui ne prend en compte ni les nouvelles instructions des CPU (même pas le MMX il me semble...) et qui n'utilise qu'un seul cœur. Dans la réalité, les gains de performances globaux depuis 2000 sont donc largement supérieurs à ceux observés sur Super Pi, grâce au passage de 1 à 4 cœurs, voir plus, et grâce aux nouvelles instructions, qui sont largement utilisées par tous les logiciels ayant besoin de performances maximales. C'est un benchmark qui est encore beaucoup utilisé dans les concours d'overclocking, pour des raisons historiques (on cherche toujours à battre le record du précédent, être le premier à faire un score sur un nouveau benchmark est moins intéressant... si demain je décide de faire un chrono sur une course de 105m35 à reculons, je deviendrais le recordman du monde du 105m35 à reculons, mais ça ne vaudra rien par rapport à un titre de recordman du monde du 100m...), mais que plus personne n'utiliser pour juger des performances d'un processeur moderne... Accessoirement, les scores pris en compte pour réaliser cette courbe ne sont pas les scores des meilleurs CPU du commerce, mais ceux des records d'overclocking. Ce n'est donc pas représentatif de la réalité des CPU disponibles sur le marché, les gains obtenus par overclocking n'étant pas forcément les mêmes à chaque génération de processeur. Les premières générations de Core 2 avaient par exemple un très fort potentiel d'overclocking, alors que les Core i d'aujourd'hui en ont un peu moins. Du cote ARM c'est l'inverse, et on le voit notamment avec les processeurs équipant les iPhone et iPad: Ah ben tiens, là comme par hasard tu nous prends une courbe de la vitesse de calcul, et pas du temps de calcul... Tu essayerais de nous enfumer que tu ne t'y prendrais pas autrement http://hexus.net/media/uploaded/2014/10/c2...7e94af4b84e.jpg Et puis c'est la courbe de performances donnée par Apple, donc tu peux être certain qu'elle prend en compte la multiplication des cœurs et les nouvelles instructions. Et que c'est une mesure dans le meilleur des cas, pas une moyenne ("up to"...). Enlève ne serait ce que la prise en compte des cœurs multiples, et tu verras que la courbe ne sera pas plus glorieuse que celle de la vitesse des puces x86 sur Super Pi que je t'ai mise juste au dessus. Si le passage aux 64bit a représente une pose dans cette course a la puissance, cela va repartir de plus belle maintenant. Dans la réalité, on constate que cette pause ne semble pas liée au passage au 64 bits : chez Apple, le ralentissement des gains de performances intervient après le passage au 64 bits, chez les autres il intervient avant... Le point commun, c'est qu'il intervient chez tout le monde en même temps. De là à supposer que ça n'a rien à voir avec le 64 bits mais plutôt avec le fait qu'on commence à atteindre les limites de ce qu'on peut tirer d'un CPU qui doit rentrer dans un smartphone, il n'y a qu'un pas...

-------------------- |

|

|

|

18 Jan 2015, 06:21 18 Jan 2015, 06:21

Message

#5

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Il suffit, plutôt que de faire la courbe du temps de calcul, de faire la courbe de la vitesse de calcul (les performances du CPU, c'est bien la vitesse de calcul, pas le temps de calcul) Eh bien entendu le temps de calcul n'a strictement rien en commun avec la vitesse de calcul... Au fait on mesure la vitesse, comment deja? Allez un petit coup de Wikipedia pour te rafraichir les idees: De manière élémentaire, la vitesse s'obtient par la division d'une mesure d'une variation (de longueur, poids, volume, etc) durant un certain temps par une mesure du temps écoulé. Je te rappelle que meme en traitement parallèle, l'element de base du calcul, c'est le temps que met une unite de traitement (un core) pour traiter l'instruction prenant le plus de temps a traiter... A partir de la on peut faire une projection qui donnera une valeur statistique qui sera la vitesse du calcul, que ce soit a minima, a maxima ou en moyenne! Ce qui est signifiant pour la puissance de traitement, c'est le nombre d'instructions traitées par unites de temps mais aussi le volume et la complexité de données traitées par unite de temps. Donc ce qui est signifiant pour la puissance, c'est le temps de calcul! Pouvoir executer x instructions par cycle c'est bien, la question est de savoir si c'est a la suite ou en parallèle... Parce que la signification est pas la meme et le resultat n'a alors pas la meme implication: pouvoir executer 3 instructions en parallèle dans le cas ou le traitement ne peut se faire qu'une instruction apres l'autre, ca veut dire que par cycle on a alors 2 operations nulles pour une operation signifiante! Ce qui veut dire que la quantites de donnees traitee par unite de temps est une information cruciale pour la puissance de traitement, et donc du processeur! Evidemement il ne s'agit pas de la vitesse de transmission des donnees, qui est certes importantes pour eviter de creer un goulet d'etranglement, mais bien de la quantite de donnees traitees: et cela est encore plus significatif dans le calcul vectoriel, celui dans lequel sont specialises les GPGPU... Et comme je te l'ai déjà maintes fois rappelé, Super Pi est un benchmark qui ne prend en compte ni les nouvelles instructions des CPU (même pas le MMX il me semble...) et qui n'utilise qu'un seul cœur. Dans la réalité, les gains de performances globaux depuis 2000 sont donc largement supérieurs à ceux observés sur Super Pi, grâce au passage de 1 à 4 cœurs, voir plus, et grâce aux nouvelles instructions, qui sont largement utilisées par tous les logiciels ayant besoin de performances maximales. Tu racontes n'importe quoi. Que tu me denigres parce que mon argumentaire contredis tes croyances c'est une technique rethorique comme une autre, mais denigrer un programme comme super PI, ca va un peu loin. En fait ce que tu es en train d'insinuer c'est que Super PI n'evalue pas l'efficacite des autres architectures (unitee vectoriel, coprocesseur,...) qui sont embarquées dans les SoC x86... Super PI est justement un des rares logiciel capables d'evaluer la puissance de calcul brute et lineaire d'un processeur. Il demontre un resultat comparable depuis des annees: la puissance de calcul brute d'un core! Ses resultats ne sont pas manipulés du fait que tel type de calcul a ete donné a une unite (un coprocesseur) a la place du core, qu'un type d'instruction aura ete optimisee pour les bench, etc... Tu peux comparer un processeur d'il y a 10 an avec un processeur actuel et avoir un resultat fiable. Le fait que les x86 d'aujourdhui sont des SoC, n'est pas une mauvaise chose en soi, puisque ca permet de compenser les limites de d'une vielle architecture. Et heureusement que les unites vectorielles existent dans ces SoC, parce que sinon tout ce qui est traitement "multimedia" ne serait simplement pas possible. Mais dans les faits, la puissance de calcul du core, Super PI demontre bien la realite de la progression. Et quand tu dois faire du calcul non vectoriel, ce qui va compter c'est justement ce qu'evalue Super PI. Donc tu peux denigrer ce programme parce qu'il derange tes croyances, en attendant ses resultats sont significatifs pour toute personne qui s'intéresse a la veritable puissance de calcul du core. Accessoirement, les scores pris en compte pour réaliser cette courbe ne sont pas les scores des meilleurs CPU du commerce, mais ceux des records d'overclocking. Ce n'est donc pas représentatif de la réalité des CPU disponibles sur le marché, les gains obtenus par overclocking n'étant pas forcément les mêmes à chaque génération de processeur. Les premières générations de Core 2 avaient par exemple un très fort potentiel d'overclocking, alors que les Core i d'aujourd'hui en ont un peu moins. Décidément, tu raconte n'importe quoi, du moment que ca t'arrange, et le dénigrement est une habitude. Puissance de calcul brute par core, tu comprends ce terme? Je le repete, meme si j'ai peu d'espoir que tu l'accepte, il s'agit d'evaluer la puissance de traitement d'un core, pas de savoir si une unite specialisee avec une architecture parallele fait mieux qu'un core x86 ou si un DSP traite plus vite un signal qu'un core x86, ou si une unite dediee au chiffrement fait mieux qu'un core x86, ou si le niveau de pipeline et le scheduler arrivent a mettre 3 instructions (exécutées en parallele) par cycles,.... non, la question ici c'est quelle est la vitesse de traitement d'une fonction par le core! Bien évidement si on monte la fréquence, on augmente mécaniquement la vitesse de traitement du flux d'instructions/donnees, c'est pourtant pas difficile a comprendre. Ensuite mettre 3 instructions par cycles, c'est bien, mais ca a un cout lie a la complexité que cela implique derriere. Faut inclure dans le calcul tout le processus de pretraitement dans ce cas, rajouter le temps perdu lorsque la prediction echoue et qu'il faut relancer le calcul,etc... Par contre augmenter la fréquence de traitement, c'est simple (a calculer et a gérer) et efficace (sauf en terme de consommation, element tres en défaveur du x86 et de sa complication extreme). Apres, pour rappel si la frequence nominale des Core 2 etaient sous-dimensionnee, c'est qu'Intel avait encore les moyens d'etre prudent sur leur fréquence de certification parce qu'Intel devait vraiment faire attention a l'epoque... la reputation de barbecue des x86 etait encore dans les esprits. Avec Haswell et plus encore Broadwell, les benefices sont si faibles qu'Intel n'a pas le choix et doit certifier des frequences qu'il n'aurait jamais fait 5 ans plus tot. Ce veut juste dire qu'Intel prend sur la capacite d'overclock, et rien d'autre. D'un autre cote Intel maitrisant l'overclock dynamique (ils appellent ca le mode turbo) tout comme d'underclocking (ils appellent ca l'optimisation énergétique...) et les cycles de vie des architectures etant toujours plus court, Intel ne prend pas un gros risque. Si le passage aux 64bit a représente une pose dans cette course a la puissance, cela va repartir de plus belle maintenant. Dans la réalité, on constate que cette pause ne semble pas liée au passage au 64 bits : chez Apple, le ralentissement des gains de performances intervient après le passage au 64 bits, chez les autres il intervient avant... Le point commun, c'est qu'il intervient chez tout le monde en même temps. De là à supposer que ça n'a rien à voir avec le 64 bits mais plutôt avec le fait qu'on commence à atteindre les limites de ce qu'on peut tirer d'un CPU qui doit rentrer dans un smartphone, il n'y a qu'un pas...Alors je reformule vu que ca pas l'air d'etre clair pour toi. Apple a preparé le passage au 64 bits depuis des années et a été trés en avance sur la concurrence pour commercialiser un processeur ARM64. Toute la concurrence a ete surprise et a du bouleverser son calendrier pour passer au 64bit, cela entrainant des retard et des difficultés qui ont de fait ralentie le travail pour assurer la montee en puissance des processeurs. Apple ayant pris une avance suffisante, n'a fait qu'une petite optimisation de son A7 en travaillant surtout sur l'unite graphique. Le gros morceau c'est l'A9 et surtout l'A10 qui seront des processeurs devant tourner sur mobile et sur desktop. Et la on va pas parler de 20% de progression au detour d'une petite optimisation mais d'une montee en puissance pour du desktop. Et ne t'en fais pas pour la concurrence d'Apple, ils sont en train de passer l'obstacle du 64 bit et vont reprendre la course a la puissance, car eux aussi ils preparent des processeurs pour desktop. Ceci étant, selon tes dires..., Intel serait passe au 64 bits facilement... mais qui a créé l'architecture 64 bits du x86,? Ah oui AMD avec la gamme AMD64, ca te rappelle quelque chose? Bon aujourd'hui Intel ose appeler ce jeu d'instructions et par extension l'architecture Intel 64... Néanmoins, faut reconnaitre qu'Intel a fait des progrès extraordinaires sur l'unite graphique battant a ce niveau toutes les previsions (et probablement la conjecture de Moore). Ce message a été modifié par r@net54 - 18 Jan 2015, 06:29. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

18 Jan 2015, 10:43 18 Jan 2015, 10:43

Message

#6

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Eh bien entendu le temps de calcul n'a strictement rien en commun avec la vitesse de calcul... Bien sûr que c'est lié, je dis pas le contraire... Mais ça donne par contre des courbes qui n'ont pas du tout la même allure, comme le montre la courbe de vitesse de calcul que j'obtiens à partir des mêmes données que celles qui donnent ta courbe de temps de calcul...Au fait on mesure la vitesse, comment deja? Là où sur ta courbe on a l'impression qu'il n'y a plus aucune progression depuis 2005, la courbe de vitesse donne bien l'impression inverse... Avec strictement les mêmes données (je suis allé récupérer les chiffres sur HWBot). Et comme face à ta courbe de temps de calcul des x86, tu mettais une courbe de vitesse de calcul des ARM Apple, le minimum de l'honnêteté intellectuelle pour rendre les deux visuellement comparables (c'est quand même le but des représentations graphiques...) aurait bien été qu'elles représentent la même chose, donc soit convertir la courbe des x86 en courbe de vitesse, soit convertir la courbe des ARM Apple en courbe de temps de calcul. Comme j'avais les données qui ont servi pour faire la courbe de temps de calcul des x86, c'était plus facile de faire avec précision la courbe de vitesse, donc je l'ai fait. Et si on faisait la courbe de temps de calcul des ARM Apple à partir de la courbe de vitesse donnée par Apple, on obtiendrait une courbe du même aspect que celle du temps de calcul des x86, c'est à dire une courbe qui s'écrase de plus en plus. N'importe qui qui a suivi correctement des cours de maths de première S devrait comprendre ça... Tiens, pour illustrer, voici les courbes du temps de traitement et de la vitesse avec une croissance exponentielle des performances :  Avec ça, tu vas continuer à prétendre que comme vitesse et temps sont liés, représenter l'un ou l'autre ne change rien ? De la première courbe, tu prétendrais qu'à partir de la septième itération, les performances stagnent... Alors qu'entre la septième et la dixième, les performances progressent d'un même facteur qu'entre la première et la quatrième (et dans l'absolu, progressent autant entre la 9ème et la 10ème qu'entre la 1ère et la 9ème...). Avec la seconde courbe, c'est flagrant qu'il n'y a pas stagnation. Une courbe de temps de traitement donnera toujours l'impression de se tasser, sauf si un jour tu trouves une solution pour que le résultat du traitement arrive avant qu'on le demande (pour avoir un temps de traitement négatif...). Autrement, tu auras toujours une courbe qui tend asymptotiquement vers 0, et donne donc rapidement l'impression d'une stagnation, même si tu multiplies les performances par 100 chaque année (en fait, plus le facteur est grand, plus la courbe va sembler stagner rapidement...). Niveau première S. Tu racontes n'importe quoi. Je ne dénigre pas Super PI. Je t'explique ce que c'est. Tiens, va voir Wikipedia : http://fr.wikipedia.org/wiki/Super_PIQue tu me denigres parce que mon argumentaire contredis tes croyances c'est une technique rethorique comme une autre, mais denigrer un programme comme super PI, ca va un peu loin. "Super Pi n'est plus mis à jour depuis 1995, cependant il est toujours très utilisé surtout dans le milieu de l'overclocking." C'est juste exactement ce que j'ai dit (et ça confirme au passage mon doute sur le MMX, puisque le MMX est arrivé en 1997, deux ans après l'abandon de SuperPi) : ça n'utilise aucune instruction moderne, et ça ne profite pas des cœurs multiples. D'où le fait qu'à part s'amuser à faire des records, plus personne ne l'utilise (HWBot, qui est la soruce de ton graphique, c'est un site d'overclockers avec des bases de record). Et cette phrase sur la page Wikipedia de Super PI remonte à 2008, c'est dire à quel point il est connu et ancien que Super PI est juste bon à faire des records, pas à évaluer les performances d'un CPU en usage réel. En fait ce que tu es en train d'insinuer c'est que Super PI n'evalue pas l'efficacite des autres architectures (unitee vectoriel, coprocesseur,...) qui sont embarquées dans les SoC x86... Je ne l'insinue pas. Je l'affirme : un programme qui date d'avant ces unités vectoriels ne peut pas les utiliser. Et ces unités ne sont pas "embarquées dans les SoC x86", mais bien dans les CPU x86. Elles font partie intégrante du cœur d'exécution du CPU, ce n'est pas un circuit externe accolé au CPU au sein d'un SoC.Super PI est justement un des rares logiciel capables d'evaluer la puissance de calcul brute et lineaire d'un processeur. Il demontre un resultat comparable depuis des annees: la puissance de calcul brute d'un core! Non. Uniquement la puissance de calcul brute avec les vieilles instructions, sans tenir compte des nouvelles.Par contre, il y a du progrès, tu reconnais que ça ne tient pas compte des cœurs multiples, donc que ça n'est pas représentatif de la puissance réellement exploitable des processeurs... Donc tu sauras désormais qu'il ne faut pas comparer la courbe des résultats sous Super Pi à la courbe d'Apple qui prend en compte les cœurs multiples. Tu peux comparer un processeur d'il y a 10 an avec un processeur actuel et avoir un resultat fiable. Fiable, oui. Représentatif, non. Parce que contrairement à Super Pi, les applications ont évolué ces 20 dernières années. Elles utilisent massivement les nouvelles instructions qui ont été introduites ces 20 dernières années, et les applications gourmandes exploitent pour la plupart la multiplication des cœurs. Un test ne prenant en compte ni les nouvelles instructions, ni les cœurs supplémentaires n'est donc pas représentatif des performances obtenues en usage réel. C'est pour ça qu'il n'y a que les overclockers qui jouent encore à Super Pi, les tests comparatifs de CPU ne l'utilisent plus depuis longtemps.Le fait que les x86 d'aujourdhui sont des SoC, n'est pas une mauvaise chose en soi, puisque ca permet de compenser les limites de d'une vielle architecture. Et heureusement que les unites vectorielles existent dans ces SoC, parce que sinon tout ce qui est traitement "multimedia" ne serait simplement pas possible. Les unités MMX, SSE, AVX et cie font bien partie du CPU, ce ne sont pas des unités séparées couplées au CPU au sein du SoC ! À quelques exceptions près (les SoC Bay Trail et quelques SoC Core i pour ultrabooks), la seule unité de calcul externe qui soit intégrée dans les die des CPU Intel, c'est le GPU, et ce n'est pas de ça que je parlais quand je disais que SuperPi n'utilise aucune des unités de nouvelles unités de calcul qui sont massivement utilisées par les applications d'aujourd'hui.Et la plupart des CPU Intel ne sont PAS de SoC. Ce sont simplement des CPU avec un contrôleur mémoire, un contrôleur PCI-E et un GPU dans le même die, ce n'est pas du tout le niveau d'intégration qu'on a avec un SoC (qui intègre également le réseau, les contrôleurs de stockage, les I/O, l'audio, souvent même le traitement de la sortie du capteur photo, etc...). Le seul cas où le MMX est une unité externe par rapport au CPU (ou plutôt est vu comme une unité externe), c'est, comme l'a expliqué Ambroise plus haut, sur les Strong ARM d'Intel, où Intel n'a pas eu le droit d'intégrer directement le MMX dans le jeu d'instructions natif du CPU. Donc tu peux denigrer ce programme parce qu'il derange tes croyances, en attendant ses resultats sont significatifs pour toute personne qui s'intéresse a la veritable puissance de calcul du core. Donc les seules personnes qui s'intéresseraient encore à la véritable puissance de calcul du core, ce sont toi et les overclockeurs ? Je le repete, meme si j'ai peu d'espoir que tu l'accepte, il s'agit d'evaluer la puissance de traitement d'un core Alors pourquoi compares tu cette courbe à celle d'Apple qui prend bien évidemment les cœurs supplémentaires en compte ? Ah oui, parce que tu ne fais preuve d'aucune honnêteté intellectuelle.Apple ayant pris une avance suffisante, n'a fait qu'une petite optimisation de son A7. Ah ben oui, c'est bien connu. Quand on prend de l'avance et qu'on a des moyens colossaux pour continuer de financer la R&D, on préfère attendre la concurrence Je croyais pourtant que les processeur ARM ont encore une énorme marge de progression super facile à exploiter ? Le fait qu'Apple, qui ne suis pas trop la course aux cœurs pour se concentrer plutôt sur les performance par cœur, ait ajouté un troisième cœur sur l'iPad plutôt que de profiter de cette marge de progression si facile à exploiter sur la performance par cœur tendrait plutôt à montrer que cette marge n'existe que dans ton imagination, et que face aux difficultés à améliorer les performances de son cœur, Apple a préféré ajouter un cœur supplémentaire. Ceci étant, selon tes dires..., Intel serait passe au 64 bits facilement... mais qui a créé l'architecture 64 bits du x86,? Ah oui AMD avec la gamme AMD64, ca te rappelle quelque chose? Bon aujourd'hui Intel ose appeler ce jeu d'instructions et par extension l'architecture Intel 64... Oui, c'est AMD. Ça ne veut pas pour autant dire qu'Intel a eu des difficultés à faire passer le x86 au 64 bits (surtout que ce qu'ils ont repris d'AMD, c'est juste le jeu d'instruction... donc en fait essentiellement des variantes 64 bits des instructions 32 bits existantes, et le choix de l'opcode à attribuer à ces instructions... extrêmement complexe quoi ^^)... La raison pour laquelle c'est AMD qui a fait le x86-64 avant Intel est bien plus commerciale que technique : les plans d'Intel pour le 64 bits, c'était l'IA-64 (utilisé sur l'Itanium), qui devait par la suite être décliné dans des processeurs grand public. AMD, qui n'avait pas de licence IA-64 a préféré faire évoluer le x86 en 64 bits. Intel ayant compris que la complexité de l'IA-64 et l'arrivée du 64 bits en x86 allait l'empêcher d'amener l'IA-64 en dehors des datacenter, il a suivi AMD sur le x86-64. Mais il ne semble pas avoir rencontré de grosses difficultés à ce niveau, le premier CPU Intel x86-64 est arrivé peu de temps après les Athlon 64 (juin 2004 contre septembre 2003).Si j'étais mauvaise langue, je dirais même que le fait qu'AMD ait été le premier à faire du x86-64 montre à quel point il n'y avait aucune difficulté à le faire... Parce que si AMD a pu le faire avec un tel succès (les Athlon 64, c'est la plus belle réussite d'AMD...) avec les moyens qu'il avait, c'est assez clair qu'Intel n'aurait eu aucune difficulté à le faire sans AMD s'il en avait pris la décision avant. Et le fait est qu'aujourd'hui contrairement à ce que tu laissais entendre Intel n'a aucun travail à faire pour passer les Atom en 64 bits, ils le sont depuis des années. -------------------- |

|

|

|

Les messages de ce sujet

Lionel Mac ARM: Apple pourrait attendre encore un an ou deux 15 Jan 2015, 23:55

Lionel Mac ARM: Apple pourrait attendre encore un an ou deux 15 Jan 2015, 23:55

iAPX Apple a déja eu deux gammes avec deux architectur... 16 Jan 2015, 00:08

iAPX Apple a déja eu deux gammes avec deux architectur... 16 Jan 2015, 00:08

fuby Citation (iAPX @ 16 Jan 2015, 07:08) Appl... 16 Jan 2015, 02:03

fuby Citation (iAPX @ 16 Jan 2015, 07:08) Appl... 16 Jan 2015, 02:03

Ambroise Citation (fuby @ 16 Jan 2015, 02:03) Il f... 16 Jan 2015, 07:47

Ambroise Citation (fuby @ 16 Jan 2015, 02:03) Il f... 16 Jan 2015, 07:47

fuby Citation (Ambroise @ 16 Jan 2015, 14:47) ... 16 Jan 2015, 09:22

fuby Citation (Ambroise @ 16 Jan 2015, 14:47) ... 16 Jan 2015, 09:22

Ambroise Citation (fuby @ 16 Jan 2015, 02:03) Et c... 16 Jan 2015, 07:56

Ambroise Citation (fuby @ 16 Jan 2015, 02:03) Et c... 16 Jan 2015, 07:56

r@net54 L'analyste en question évoque le passage dans... 16 Jan 2015, 00:48

r@net54 L'analyste en question évoque le passage dans... 16 Jan 2015, 00:48

zero Citation (r@net54 @ 16 Jan 2015, 08:48) N... 16 Jan 2015, 00:51

zero Citation (r@net54 @ 16 Jan 2015, 08:48) N... 16 Jan 2015, 00:51

Pascal 77 Citation (r@net54 @ 16 Jan 2015, 00:48) D... 16 Jan 2015, 09:41

Pascal 77 Citation (r@net54 @ 16 Jan 2015, 00:48) D... 16 Jan 2015, 09:41

SartMatt Citation (kiw0r @ 16 Jan 2015, 09:36) Voi... 16 Jan 2015, 10:28

SartMatt Citation (kiw0r @ 16 Jan 2015, 09:36) Voi... 16 Jan 2015, 10:28

MacMobile Xcode n'utilise plus le GCC mais le LLVM (Low... 16 Jan 2015, 00:54

MacMobile Xcode n'utilise plus le GCC mais le LLVM (Low... 16 Jan 2015, 00:54

El Bacho Citation (MacMobile @ 16 Jan 2015, 00:54)... 16 Jan 2015, 01:15

El Bacho Citation (MacMobile @ 16 Jan 2015, 00:54)... 16 Jan 2015, 01:15

GregWar Citation (El Bacho @ 16 Jan 2015, 01:15) ... 16 Jan 2015, 08:08

GregWar Citation (El Bacho @ 16 Jan 2015, 01:15) ... 16 Jan 2015, 08:08

r@net54 Citation (GregWar @ 16 Jan 2015, 09:08) D... 16 Jan 2015, 14:03

r@net54 Citation (GregWar @ 16 Jan 2015, 09:08) D... 16 Jan 2015, 14:03

SartMatt Citation (r@net54 @ 16 Jan 2015, 14:03) t... 16 Jan 2015, 14:55

SartMatt Citation (r@net54 @ 16 Jan 2015, 14:03) t... 16 Jan 2015, 14:55

Crapouilleau Citation (r@net54 @ 16 Jan 2015, 14:03) L... 16 Jan 2015, 16:15

Crapouilleau Citation (r@net54 @ 16 Jan 2015, 14:03) L... 16 Jan 2015, 16:15

Ambroise Citation (r@net54 @ 16 Jan 2015, 14:03) L... 16 Jan 2015, 17:25

Ambroise Citation (r@net54 @ 16 Jan 2015, 14:03) L... 16 Jan 2015, 17:25

MacMobile Citation (El Bacho @ 15 Jan 2015, 19:15) ... 16 Jan 2015, 14:08

MacMobile Citation (El Bacho @ 15 Jan 2015, 19:15) ... 16 Jan 2015, 14:08

jipeca J'ai l'impression que j'en ai pour des... 16 Jan 2015, 01:09

jipeca J'ai l'impression que j'en ai pour des... 16 Jan 2015, 01:09

Kierkegaard Citation (jipeca @ 15 Jan 2015, 19:09) J... 16 Jan 2015, 01:15

Kierkegaard Citation (jipeca @ 15 Jan 2015, 19:09) J... 16 Jan 2015, 01:15

Alizés À l'ARM et son retard de calendrier, comme à... 16 Jan 2015, 01:34

Alizés À l'ARM et son retard de calendrier, comme à... 16 Jan 2015, 01:34

zorphil Peut-être des Mac ARM tournant sur une nouvelle m... 16 Jan 2015, 07:50

zorphil Peut-être des Mac ARM tournant sur une nouvelle m... 16 Jan 2015, 07:50

JoKerforever Je ne vois pas comment cela peut être commerciale... 16 Jan 2015, 07:57

JoKerforever Je ne vois pas comment cela peut être commerciale... 16 Jan 2015, 07:57

zloran Et pourquoi pas le retour de l'iBook tournant ... 16 Jan 2015, 08:31

zloran Et pourquoi pas le retour de l'iBook tournant ... 16 Jan 2015, 08:31

Lionel En fait, le plus dur n'est pas tant d'imag... 16 Jan 2015, 08:34

Lionel En fait, le plus dur n'est pas tant d'imag... 16 Jan 2015, 08:34

McCaron Citation (Lionel @ 16 Jan 2015, 08:34) En... 16 Jan 2015, 09:38

McCaron Citation (Lionel @ 16 Jan 2015, 08:34) En... 16 Jan 2015, 09:38

McCaron cet analyste est aussi célèbre pour ses prédict... 16 Jan 2015, 09:35

McCaron cet analyste est aussi célèbre pour ses prédict... 16 Jan 2015, 09:35

kiw0r Hello,

Que le mac passe a l'ARM me gêne pas ... 16 Jan 2015, 09:36

kiw0r Hello,

Que le mac passe a l'ARM me gêne pas ... 16 Jan 2015, 09:36

dtb06 Citation (kiw0r @ 16 Jan 2015, 09:36) [..... 16 Jan 2015, 10:03

dtb06 Citation (kiw0r @ 16 Jan 2015, 09:36) [..... 16 Jan 2015, 10:03

shawnscott Quid de Carbon lors du passage de MacOS 9 à X (bo... 16 Jan 2015, 09:45

shawnscott Quid de Carbon lors du passage de MacOS 9 à X (bo... 16 Jan 2015, 09:45

Pascal 77 Citation (shawnscott @ 16 Jan 2015, 09:45... 16 Jan 2015, 11:09

Pascal 77 Citation (shawnscott @ 16 Jan 2015, 09:45... 16 Jan 2015, 11:09

Chicken Mayo Il suffit que ca ne s'appelle plus Mac.

Si ce... 16 Jan 2015, 10:25

Chicken Mayo Il suffit que ca ne s'appelle plus Mac.

Si ce... 16 Jan 2015, 10:25

Webtourist Je suis d'accord avec les analyses qui émette... 16 Jan 2015, 11:35

Webtourist Je suis d'accord avec les analyses qui émette... 16 Jan 2015, 11:35

Pensee La Pomme est un produit perissable !

honetem... 16 Jan 2015, 11:52

Pensee La Pomme est un produit perissable !

honetem... 16 Jan 2015, 11:52

Tophe974 Citation (SartMatt @ 16 Jan 2015, 10:28) ... 16 Jan 2015, 11:53

Tophe974 Citation (SartMatt @ 16 Jan 2015, 10:28) ... 16 Jan 2015, 11:53

SartMatt Citation (Tophe974 @ 16 Jan 2015, 11:53) ... 16 Jan 2015, 12:58

SartMatt Citation (Tophe974 @ 16 Jan 2015, 11:53) ... 16 Jan 2015, 12:58

elbacho En fait Apple, pourrait attendre encore un an ou d... 16 Jan 2015, 12:53

elbacho En fait Apple, pourrait attendre encore un an ou d... 16 Jan 2015, 12:53

El Bacho Citation (elbacho @ 16 Jan 2015, 12:53) Q... 16 Jan 2015, 14:18

El Bacho Citation (elbacho @ 16 Jan 2015, 12:53) Q... 16 Jan 2015, 14:18

Heret Citation (Lionel @ 15 Jan 2015, 23:55) ..... 16 Jan 2015, 14:19

Heret Citation (Lionel @ 15 Jan 2015, 23:55) ..... 16 Jan 2015, 14:19

Montréal Et s'il s'agissait d'un pas de plus ve... 16 Jan 2015, 14:40

Montréal Et s'il s'agissait d'un pas de plus ve... 16 Jan 2015, 14:40

dtb06 Et on l'a bien vu depuis la chute d'AMD (p... 16 Jan 2015, 18:33

dtb06 Et on l'a bien vu depuis la chute d'AMD (p... 16 Jan 2015, 18:33

SartMatt Citation (dtb06 @ 16 Jan 2015, 18:33) Et ... 16 Jan 2015, 18:41

SartMatt Citation (dtb06 @ 16 Jan 2015, 18:33) Et ... 16 Jan 2015, 18:41

Ambroise Citation (dtb06 @ 16 Jan 2015, 18:33) Et ... 16 Jan 2015, 22:16

Ambroise Citation (dtb06 @ 16 Jan 2015, 18:33) Et ... 16 Jan 2015, 22:16

SartMatt Citation (Ambroise @ 16 Jan 2015, 22:16) ... 17 Jan 2015, 00:22

SartMatt Citation (Ambroise @ 16 Jan 2015, 22:16) ... 17 Jan 2015, 00:22

Ambroise Citation (SartMatt @ 17 Jan 2015, 00:22) ... 17 Jan 2015, 07:42

Ambroise Citation (SartMatt @ 17 Jan 2015, 00:22) ... 17 Jan 2015, 07:42

Ambroise Citation (r@net54 @ 18 Jan 2015, 06:21) C... 18 Jan 2015, 11:08

Ambroise Citation (r@net54 @ 18 Jan 2015, 06:21) C... 18 Jan 2015, 11:08

SartMatt Citation (r@net54 @ 17 Jan 2015, 18:05) P... 17 Jan 2015, 19:24

SartMatt Citation (r@net54 @ 17 Jan 2015, 18:05) P... 17 Jan 2015, 19:24

Ambroise Citation (SartMatt @ 17 Jan 2015, 19:24) ... 17 Jan 2015, 22:39

Ambroise Citation (SartMatt @ 17 Jan 2015, 19:24) ... 17 Jan 2015, 22:39

iFrodo Personnellement je suis pour le développement des... 17 Jan 2015, 09:34

iFrodo Personnellement je suis pour le développement des... 17 Jan 2015, 09:34

kwak-kwak Citation (iFrodo @ 17 Jan 2015, 09:34) Pe... 17 Jan 2015, 10:07

kwak-kwak Citation (iFrodo @ 17 Jan 2015, 09:34) Pe... 17 Jan 2015, 10:07

El Bacho Citation (kwak-kwak @ 17 Jan 2015, 10... 17 Jan 2015, 10:23

El Bacho Citation (kwak-kwak @ 17 Jan 2015, 10... 17 Jan 2015, 10:23

Ambroise Citation (iFrodo @ 17 Jan 2015, 09:34) Pe... 17 Jan 2015, 11:57

Ambroise Citation (iFrodo @ 17 Jan 2015, 09:34) Pe... 17 Jan 2015, 11:57

SartMatt Citation (iFrodo @ 17 Jan 2015, 09:34) et... 17 Jan 2015, 15:30

SartMatt Citation (iFrodo @ 17 Jan 2015, 09:34) et... 17 Jan 2015, 15:30

SartMatt RE: Mac ARM: Apple pourrait attendre encore un an ou deux 17 Jan 2015, 22:56

SartMatt RE: Mac ARM: Apple pourrait attendre encore un an ou deux 17 Jan 2015, 22:56

zero r@net54, tu confonds traitement, calcul et opérat... 18 Jan 2015, 07:45

zero r@net54, tu confonds traitement, calcul et opérat... 18 Jan 2015, 07:45

Ambroise Citation (zero @ 18 Jan 2015, 07:45) r@ne... 18 Jan 2015, 08:51

Ambroise Citation (zero @ 18 Jan 2015, 07:45) r@ne... 18 Jan 2015, 08:51

Tophe974 Citation (dtb06 @ 16 Jan 2015, 18:33) Enc... 19 Feb 2015, 01:16

Tophe974 Citation (dtb06 @ 16 Jan 2015, 18:33) Enc... 19 Feb 2015, 01:16

Ambroise Citation (Tophe974 @ 19 Feb 2015, 01:16) ... 19 Feb 2015, 17:28

Ambroise Citation (Tophe974 @ 19 Feb 2015, 01:16) ... 19 Feb 2015, 17:28

Licorne31 Et pourquoi pas un retour au PPC, avec le Power8 q... 19 Feb 2015, 07:48

Licorne31 Et pourquoi pas un retour au PPC, avec le Power8 q... 19 Feb 2015, 07:48

Ambroise Citation (Licorne31 @ 19 Feb 2015, 07:48)... 20 Feb 2015, 13:48

Ambroise Citation (Licorne31 @ 19 Feb 2015, 07:48)... 20 Feb 2015, 13:48  |

4 utilisateur(s) sur ce sujet (4 invité(s) et 0 utilisateur(s) anonyme(s))

0 membre(s) :

| Nous sommes le : 17th September 2025 - 05:05 |