Bienvenue invité ( Connexion | Inscription )

13 Nov 2014, 00:01 13 Nov 2014, 00:01

Message

#1

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 531 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

Anandtech a obtenu de nouvelles informations sur la partie graphique de la puce A8X dont est équipé l'iPad Air 2. Elle est encore bien plus aboutie que ne le laissaient penser les premières estimations.

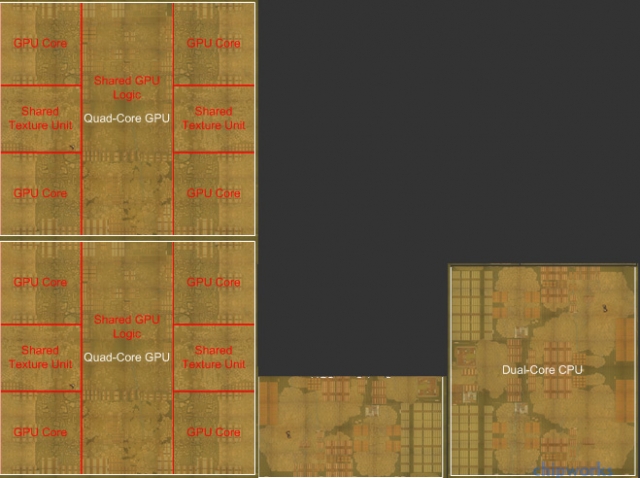

Dans les faits, ses performances sont deux fois supérieures à celles de l'A8. Pour arriver à ça, Apple n'a pas lésiné sur le nombre de transistors et a installé pas moins de 8 cœurs graphiques séparés en deux unités de quatre partageant mémoire vidéo et unités de calcul annexes. Voici une représentation (ce n'est pas une image réelle) de cet ensemble.  Si l'on rajoute à ça les 2 Go de RAM sur un bus 128 bits (contre 64 bits pour les autres appareils iOS), on comprend mieux les résultats bluffants obtenus par l'A8X par rapport à tout ce qui existe ou presque. On peut aussi se rendre compte du potentiel de ces puces Ax chez Apple et les raisons pour lesquelles la société songe à en doter des ordinateurs dans le futur. Lien vers le billet original -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

|

Réponse(s)

13 Nov 2014, 11:31 13 Nov 2014, 11:31

Message

#2

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 338 Inscrit : 24 Feb 2003 Membre no 6 379 |

Passer du X86 à l'ARM est avant tout une décision idéologique et politique. Le problème n'est plus tant de pouvoir proposer des applications véloces sur des processeurs ayant 3 milliards de transistors comme l'A8X mais de faire que tous les grands suivent Apple. Quels grands ? Ceux du logiciel style MS ou Adobe ? MS en ce moment à l'air de se remuer un peu (mieux vaut tard…), donc supporter l'ARM n'aurait rien d'insurmontable pour eux. Adobe par contre est encore empêtré dans des logiciels assez archaïques et dépassés, et là ça va prendre un peu plus de temps. Mais on se souviendra qu'Adobe n'a pas eu trop le choix que de passer à OS X et aux procs Intel alors qu'à l'époque la part de marché du Mac était bien inférieure à celle d'aujourd'hui. Et Apple n'avait clairement pas le même poids ! Donc lentement peut-être, mais ça se ferait. Quand aux autres développeurs, une éventuelle transition ça se résumera à 95% du temps à cocher une case dans Xcode. Exactement comme le passage à Intel ou au 64 bits. Le problème est là et Intel fera tout pour que ce n'arrive pas. Rappelez vous juste ce qu'Intel a réussi à faire pour bloquer AMD. On est pas du tout dans la même situation ! Déjà tu commets l'erreur, et c'est pas la première fois, même récemment, de voir Apple comme faible et à la merci du premier venu. Alors qu'Intel est franchement petit à côté. Apple pourrait presque les racheter ! Tu te trompes d'époque, là le géant c'est la Pomme. Les autres ils sont tous en dessous, voir même très en dessous. Ensuite ce qu'Intel à fait par le passé ce sont des pressions sur les constructeurs de PC et des benchs foireux pour les médias… C'est bien ça mais Apple s'en fout ! La Pomme si transition il y avait mettrait ses puces dans ses machines, et l'entreprise est très bonne en com' donc Intel pourrait raconter ce qu'il veut aux médias que ça ne changerait rien. Donc à mon avis rien n'empêcherais que ça puisse se faire. Excepté si l'opération n'offre pas une plus value suffisante. N'oublions pas que si transition vers Intel il y a eu c'était parce que les PC rattrapaient dangereusement les Mac PPC. Mais là encore la situation actuelle est fort différente, car si Intel faiblit, tous les constructeurs en subissent à égalité les conséquence. Un Mac ne sera donc quoi qu'il arrive ni meilleur ni plus mauvais en perfs qu'un PC qu'Intel ai ou non fait des progrès. Pour l'instant Apple peut donc parfaitement se contenter du puces Intel, y'a pas de concurrence. Mais par contre d'ici un certain temps et si Intel progresse peu, elle pourrait jouer son vatout en passant sur ARM, et avoir là un gros avantage sur les fabricants de PC. Ça c'est pour le CPU, mais si j'en reviens à l'article on y parle de GPU, et je me dit qu'il y a une chose qui pourrait se faire beaucoup plus rapidement et avec probablement peu de problèmes de compatibilité qui serait de greffer sur nos Mac un GPU dérivé de celui de l'impressionnant A8x (sur une puce graphique on peut multiplier les coeurs à l'envie cela s'optimise fort bien). Après tout aujourd'hui on de très bonnes cartes chez AMD, mais il est par exemple inenvisageable de mettre une 295X même en version mobile dans un MacBook [air] ! Trop gros, trop chaud, trop consommateur ! Et si les GPU intégrés d'Intel ont heureusement fait des progrès au fil des années et ne consomment pas grand chose, la puissance n'est pas tellement là. Avec un GPU made in Apple on pourrait avoir les deux: performances et économie d'énergie. Et ça serait le paradis pour les devs: on pourrait avoir l'API Metal que ça soit iOS ou OS X ! Enorme avantage… Voilà une deuxième carte à jouer pour Apple. Apple est fort, mais Apple ne serait rien sans ARM. Si ARM n'avait pas sorti des architectures aussi poussées, Apple n'arriverait pas à faire tout ça. S'il te plaît arrête de minimiser le travail d'Apple. ARM n'est qu'une base architecturale, et n'importe quel site spécialisé (Anandtech ou autre) a déjà depuis fort longtemps démontré que la Pomme avait pas mal amélioré ce CPU. Sinon comme tu expliques qu'un A8 tienne tête voir dépasse des concurrents avec 4 voir 8 coeurs et je ne sais combien de plus de MHz ? Le rendement des puces d'Apple est sans commune mesure ! C'est vraiment ARM qui dépote, et qui va mettre une énorme claque à Intel, et ça c'est bon. On va peut-être enfin se débarasser de la vieillissante architecture x86 Faut dire aussi que ce sont des produits qui à la base n'ont pas du tout été conçus pour les mêmes usages et ne sont pas nés en même temps, loin de là. Et quand je vois les dernières puces mobiles d'Intel j'ai l'impression qu'ils ont parfaitement compris la situation. C'est pas du tout un débat pro/anti Intel. On discute là juste de ce qui est opportun de faire. Crois-bien en tout qu'Apple ne prendra pas de décision à la légère et sûrement pas par fanatisme comme laisse par contre transparaître ton commentaire. |

|

|

|

13 Nov 2014, 19:02 13 Nov 2014, 19:02

Message

#3

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Passer du X86 à l'ARM est avant tout une décision idéologique et politique. Le problème n'est plus tant de pouvoir proposer des applications véloces sur des processeurs ayant 3 milliards de transistors comme l'A8X mais de faire que tous les grands suivent Apple. Quels grands ? Ceux du logiciel style MS ou Adobe ? MS en ce moment à l'air de se remuer un peu (mieux vaut tard…), donc supporter l'ARM n'aurait rien d'insurmontable pour eux. Adobe par contre est encore empêtré dans des logiciels assez archaïques et dépassés, et là ça va prendre un peu plus de temps. Mais on se souviendra qu'Adobe n'a pas eu trop le choix que de passer à OS X et aux procs Intel alors qu'à l'époque la part de marché du Mac était bien inférieure à celle d'aujourd'hui. Et Apple n'avait clairement pas le même poids ! Donc lentement peut-être, mais ça se ferait. Quand aux autres développeurs, une éventuelle transition ça se résumera à 95% du temps à cocher une case dans Xcode. Exactement comme le passage à Intel ou au 64 bits. ... Bien argumenté. Il faut rajouter que la grosse evolution en terme de processeur c'est la reduction de consommation, parce que la puissance brute elle stagne méchamment depuis 2007 sur x86:  Intel a fait de gros progres sur la performance par watt, mais il faut bien se mettre en tete qu'il s'agit s'une optimisation de l'architecture archaique du x86 qui etait initialement pensee dans la dynamique de la conjecture de Moore: la progression de la finesse de gravure etait la clef du gain de puissance et de diminution de la consommation... Le x86 a ete stoppe net avec le mur des 4ghz qui a sonne le glas du mythe de la conjecture de Moore: on peut descendre en finesse de gravure, mais ca n'ameliore pas beaucoup la situation, notamment en terme de dégagement thermique. AMD a permis au x86 d'avoir un sursit en lui offrant un moteur RISC et une architecture 64 bits, mais ca ne change rien au probleme de conception initiale et il faut se rappeler que le code x86 doit etre converti en instructions RISC avant d'etre execute, et le processeur dispose d'un ordonnanceur qui reorganise les instructions avant de les executer... Donc on est sur une architecture complexe, avec des technologies tres avancees, un niveau de complication extreme pour maintenir une vieille architecture basée sur un principe dépassé. ARM c'est l'inverse, une architecture pensee pour l'efficacite par watt, la plasticite et l'efficience du code. Et surtout l'architecture n'est pas basée sur la conjecture de Moore, les processeurs ARM devant etre efficaces en embarqué bien plus vite que ne progressait le finesse de gravure. On voit qu'a la différence du x86, ARM offre une architecture ouverte dans une environnement extrêmement concurrentiel ou des solutions innovantes peuvent etre facilement mise en place: tout l'inverse du x86 et de la politique de monopole totalitaire d'Intel. Aujourd'hui ARM est l'architecture de reference pour le mobile, et se developpe hors de l'embarque vers le serveurs, le HPC et maintenant le PC. Ce qu'a fait Apple est un processeur ultra mobile mais qui a une puissance desktop. Le travail sur le GPU est une nouveaute qui demontre qu'Apple a acquis non seulement le savoir faire sur CPU mais va au-dela. Pour comprendre ou en est Apple réellement, il va falloir attendre le SoC de l'Apple watch. Pour Apple passer sous ARM sa ligne PC a plusieurs avantages, a commencer par le cout et la maitrise logiciel/materiel. Le probleme pour Apple c'est qu'aujourd'hui la partie logicielle a besoin d'etre reprise en main sérieusement Adobe aussi est pragmatique en travaillant à des versions déportées dans le nuage de ses applications. Photoshop Streaming fonctionne pour Chrome 0S (ARM et x86) ainsi que dans le navigateur Chrome (Windows 7 et 8). Un Mac ARM iOS X aura peut-être droit un jour à une version. Si Adobe ne passait pas a ARM cela relancerait la concurrence sur un secteur qui est soumis a un monopole délétère depuis des années, et la baisse des ventes chez Adobe va les inciter a se réveiller enfin. Donc Adobe passera a ARM c'est meme pas la question. Ce qui compte pour utiliser ces logiciels c'est plus les performances graphiques que le CPU, et la on a bien des gens qui travaillent avec uniquement les pauvres unites graphiques integrées aux Core ix... On ne parle meme pas des Mac Pro qui embarquent des GPU NVidia alors que la majorite des softs de traitements graphiques sont optimise pour les cartes NVidia. Donc lorsque Apple sortira ces Mac ARM, ils tourneront au moins aussi vite que ce que l'on a actuellement et les performances graphiques seront probablement meilleures, a part pour les modeles haut de gamme avec des GPU Nvidia, et encore, quand on voit l'anemique GPU de l'iMac retina, ca va pas etre difficile de faire mieux. Quant a l'histoire du cloud computing pour faire tourner ce type de soft c'est du markting et c'est sans interet. Ce message a été modifié par r@net54 - 13 Nov 2014, 19:03. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

13 Nov 2014, 19:26 13 Nov 2014, 19:26

Message

#4

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Il faut rajouter que la grosse evolution en terme de processeur c'est la reduction de consommation, parce que la puissance brute elle stagne méchamment depuis 2007 sur x86: Bien essayé... Mais : 1) SuperPi est un benchmark qui n'utilise aucune nouvelle instruction. C'est bien pour comparer les performances brutes sur quelques opérations simples, mais ce n'est absolument pas représentatif de l'évolution des performances réelles à l'usage sur pas mal de tâches, car toutes les applications d'aujourd'hui utilisent les nouveaux jeux d'instructions... C'est particulièrement vrai par exemple pour tout ce qui est applications multimédia, où l'apport des nouvelles instructions peut parfois se traduire par un doublement des performances d'une génération à l'autre, même si les performances en arithmétique pure n'ont presque pas bougé. 2) L'auteur de ce graphique a choisi une échelle linéaire pour le temps de calcul : c'est complètement con comme échelle ! Une échelle linéaire sur un temps de calcul, ça fait qu'une augmentation exponentielle des performances donne une courbe logarithmique : c'est totalement biaisé, ça donne l'impression que la progression est de plus en plus faible. À plus forte raison, quand le progression n'est plus exponentielle, une représentation logarithmique "écrase" encore plus la courbe, renforçant l'impression de stagnation. En l'occurrence, la "méchante stagnation" depuis 2007, c'est quand même une multiplication des performances par un facteur supérieur à 2 (certes, on était auparavant plus habitué à voir ça sur deux ans, voir moins), sur du code ne profitant pas des plus grosses améliorations... AMD a permis au x86 d'avoir un sursit en lui offrant un moteur RISC et une architecture 64 bits, mais ca ne change rien au probleme de conception initiale et il faut se rappeler que le code x86 doit etre converti en instructions RISC avant d'etre execute, et le processeur dispose d'un ordonnanceur qui reorganise les instructions avant de les executer... Ce qui est rigolo avec toi, c'est que on a beau t'expliquer que tous les processeurs performants d'aujourd'hui font de la traduction d'instruction (et en particulier les deux ARM les plus performants sur le marché grand public : A8 et Tegra K1, ce dernier faisant cette traduction de façon logicielle) et qu'une bonne part fait aussi de l'exécution out-of-order (y compris l'A8, dont le re-order buffer est aussi gros que celui d'un Haswell), tu continues à présenter ça comme un défaut propre à l'architecture x86 Quand à la complexité de l'architecture, quand on voit qu'un A8 tape dans les 2 milliards de transistors, soit plus qu'un Haswell quad-core GT2 (1.6 milliards), on peut se demander si c'est vraiment aussi simple que tu le prétends EDIT : d'après cette image http://pc.watch.impress.co.jp/img/pcw/docs/615/261/06.jpg et celle là http://media.bestofmicro.com/R/R/462375/or..._A7-A8_Dies.jpg, on peut estimer que les deux cœurs CPU du A8 font ~12.9mm² contre ~8.8mm² pour deux cœurs Atom Bay Trail. Alors que l'A8 est gravé très légèrement plus fin. Même avec la grosse marge d'erreur inhérente à ce type de mesures, il est donc à peu près certain que deux cœurs A8 nécessitent plus de transistors que 2 cœurs Bay Trail. Complexité du x86 tu disais ? -------------------- |

|

|

|

14 Nov 2014, 16:50 14 Nov 2014, 16:50

Message

#5

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Il faut rajouter que la grosse evolution en terme de processeur c'est la reduction de consommation, parce que la puissance brute elle stagne méchamment depuis 2007 sur x86: Bien essayé... Mais : 1) SuperPi est un benchmark qui n'utilise aucune nouvelle instruction. C'est bien pour comparer les performances brutes sur quelques opérations simples, mais ce n'est absolument pas représentatif de l'évolution des performances réelles à l'usage sur pas mal de tâches, car toutes les applications d'aujourd'hui utilisent les nouveaux jeux d'instructions... C'est particulièrement vrai par exemple pour tout ce qui est applications multimédia, où l'apport des nouvelles instructions peut parfois se traduire par un doublement des performances d'une génération à l'autre, même si les performances en arithmétique pure n'ont presque pas bougé. 2) L'auteur de ce graphique a choisi une échelle linéaire pour le temps de calcul : c'est complètement con comme échelle ! Une échelle linéaire sur un temps de calcul, ça fait qu'une augmentation exponentielle des performances donne une courbe logarithmique : c'est totalement biaisé, ça donne l'impression que la progression est de plus en plus faible. À plus forte raison, quand le progression n'est plus exponentielle, une représentation logarithmique "écrase" encore plus la courbe, renforçant l'impression de stagnation. En l'occurrence, la "méchante stagnation" depuis 2007, c'est quand même une multiplication des performances par un facteur supérieur à 2 (certes, on était auparavant plus habitué à voir ça sur deux ans, voir moins), sur du code ne profitant pas des plus grosses améliorations... SuperPi évalue la puissance de calcul brute du core comme tu le reconnais. Il n'évalue pas les autres unites comme les unites de traitement vectoriel, les unite de gestion I/O, les equivalents des DSP, etc. Ce test est donc représentatif de la puissance de calcul en monocore. il est valable et représentatif de la progression reelle de la puissance. Et cette puissance de calcul est celle du CPU. Si on veut évaluer la puissance en vectoriel, par exemple pour le traitement video, les CPU sont totalement écrasés par le GPGPU. Pareil pour le traitement de signal. Je sais que ca fait mal de voir ca, mais le choix de la representation est legitime et significative. Le systeme est simple et il dit bien ce qu'il veut dire: combien de temps met un processeur pour realiser un calcul standard? Il dit donc que depuis 2007 il n'y a pas eu d'evolution significative sur la puissance de traitement: le temps necessaire pour realiser le calcul étant quasi le meme depuis 7 ans, ce que tu reconnais aussi! Quant a la complexité de l'architecture, tu détournes volontairement le sujet sur le nombre de composants (transistors). Ca n'a rien a voir évidemment avec la complexité de l'architecture. Dans un x86 on a au moins 1 niveau de pre-traitement et de post-traitement des données supplémentaires, donc ca augmente la complexité d'au moins 2 niveaux. D'ailleurs tu le sais pertinemment. Intel a un savoir faire en terme d'optimisation de rendement qui est superieur a la majorite des autres concepteurs de CPU, a part IBM. Ils disposent aussi d'un savoir faire en terme de gravure parmi les meilleurs. Pourquoi avec une telle avance ils n'arrivent pas avec les Atom a écraser les ARM? Si aujourd'hui TSMC est en train de faire son retard sur Intel en terme d'efficacite de gravure, c'est tout nouveau et ils sont pas encore aussi efficace qu'Intel. Donc on a un x86 totalement maitrisé optimisé comme une formule 1 par des ingenieurs qui sont les meilleurs au monde et en face on a de l'ARM qui est encore tres loin d'etre aussi optimisé et qui est moins maitrisée. Donc la marge de progression entre le x86 et l'ARM n'est pas la meme. La difference c'est l'efficacité de l'architecture:CQFD. Ce message a été modifié par r@net54 - 14 Nov 2014, 17:03. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

14 Nov 2014, 17:16 14 Nov 2014, 17:16

Message

#6

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 515 Inscrit : 21 Sep 2005 Membre no 46 410 |

SuperPi évalue la puissance de calcul brute du core comme tu le reconnais. Il n'évalue pas les autres unites comme les unites de traitement vectoriel, les unite de gestion I/O, les equivalents des DSP, etc. Ce test est donc représentatif de la puissance de calcul en monocore. il est valable et représentatif de la progression reelle de la puissance. Et cette puissance de calcul est celle du CPU. Si on veut évaluer la puissance en vectoriel, par exemple pour le traitement video, les CPU sont totalement écrasés par le GPGPU. Pareil pour le traitement de signal. Je sais que ca fait mal de voir ca, mais le choix de la representation est legitime et significative. Le systeme est simple et il dit bien ce qu'il veut dire: combien de temps met un processeur pour realiser un calcul standard? Il dit donc que depuis 2007 il n'y a pas eu d'evolution significative sur la puissance de traitement: le temps necessaire pour realiser le calcul étant quasi le meme depuis 7 ans, ce que tu reconnais aussi! Ça revient à mesurer la vitesse maximale d'une voiture en la bloquant au 1er rapport de sa boîte de vitesse. Ce n'est donc absolument pas significatif pour la vie de tous les jours. |

|

|

|

Les messages de ce sujet

Lionel Apple a tout particulièrement soigné la partie graphique de l'A8X 13 Nov 2014, 00:01

Lionel Apple a tout particulièrement soigné la partie graphique de l'A8X 13 Nov 2014, 00:01

r@net54 Ce qui est le plus impressionnant c'est qu... 13 Nov 2014, 00:36

r@net54 Ce qui est le plus impressionnant c'est qu... 13 Nov 2014, 00:36

iAPX Bah j'avais déja écrit que c'étais bien... 13 Nov 2014, 02:44

iAPX Bah j'avais déja écrit que c'étais bien... 13 Nov 2014, 02:44

AlbertRaccoon Citation (iAPX @ 13 Nov 2014, 02:44) mais... 13 Nov 2014, 07:54

AlbertRaccoon Citation (iAPX @ 13 Nov 2014, 02:44) mais... 13 Nov 2014, 07:54

yponomeute Citation (AlbertRaccoon @ 13 Nov 2014, 07... 13 Nov 2014, 12:58

yponomeute Citation (AlbertRaccoon @ 13 Nov 2014, 07... 13 Nov 2014, 12:58

xpech Citation (iAPX @ 13 Nov 2014, 02:44) Bah ... 13 Nov 2014, 09:14

xpech Citation (iAPX @ 13 Nov 2014, 02:44) Bah ... 13 Nov 2014, 09:14

morane_j Citation (iAPX @ 13 Nov 2014, 02:44) Bah ... 13 Nov 2014, 09:47

morane_j Citation (iAPX @ 13 Nov 2014, 02:44) Bah ... 13 Nov 2014, 09:47

jcollot Citation (morane_j @ 13 Nov 2014, 10:47) ... 13 Nov 2014, 13:58

jcollot Citation (morane_j @ 13 Nov 2014, 10:47) ... 13 Nov 2014, 13:58

morane_j Citation (jcollot @ 13 Nov 2014, 13:58) C... 13 Nov 2014, 14:25

morane_j Citation (jcollot @ 13 Nov 2014, 13:58) C... 13 Nov 2014, 14:25

superayate Citation (iAPX @ 13 Nov 2014, 03:44) Bah ... 13 Nov 2014, 10:13

superayate Citation (iAPX @ 13 Nov 2014, 03:44) Bah ... 13 Nov 2014, 10:13

Lionel Passer du X86 à l'ARM est avant tout une déc... 13 Nov 2014, 07:15

Lionel Passer du X86 à l'ARM est avant tout une déc... 13 Nov 2014, 07:15

jeannot Citation (Lionel @ 13 Nov 2014, 08:15) Pa... 13 Nov 2014, 08:13

jeannot Citation (Lionel @ 13 Nov 2014, 08:15) Pa... 13 Nov 2014, 08:13

Mac Moins Je me permets de reposer une vieille question rest... 13 Nov 2014, 08:42

Mac Moins Je me permets de reposer une vieille question rest... 13 Nov 2014, 08:42

JoKerforever Citation (Mac Moins @ 13 Nov 2014, 09:42)... 13 Nov 2014, 09:01

JoKerforever Citation (Mac Moins @ 13 Nov 2014, 09:42)... 13 Nov 2014, 09:01

AlbertRaccoon Citation (JoKerforever @ 13 Nov 2014, 09... 13 Nov 2014, 09:05

AlbertRaccoon Citation (JoKerforever @ 13 Nov 2014, 09... 13 Nov 2014, 09:05

JoKerforever Citation (AlbertRaccoon @ 13 Nov 2014, 10... 13 Nov 2014, 09:24

JoKerforever Citation (AlbertRaccoon @ 13 Nov 2014, 10... 13 Nov 2014, 09:24

SartMatt Citation (jeannot @ 13 Nov 2014, 08:13) Q... 13 Nov 2014, 09:50

SartMatt Citation (jeannot @ 13 Nov 2014, 08:13) Q... 13 Nov 2014, 09:50

JoKerforever Citation (SartMatt @ 13 Nov 2014, 10:50) ... 13 Nov 2014, 10:11

JoKerforever Citation (SartMatt @ 13 Nov 2014, 10:50) ... 13 Nov 2014, 10:11

nicogala Citation (SartMatt @ 13 Nov 2014, 09:50) ... 13 Nov 2014, 12:30

nicogala Citation (SartMatt @ 13 Nov 2014, 09:50) ... 13 Nov 2014, 12:30

iaka Citation (JoKerforever @ 13 Nov 2014, 10... 13 Nov 2014, 09:15

iaka Citation (JoKerforever @ 13 Nov 2014, 10... 13 Nov 2014, 09:15

AlbertRaccoon Citation (iaka @ 13 Nov 2014, 09:15) Pour... 13 Nov 2014, 09:25

AlbertRaccoon Citation (iaka @ 13 Nov 2014, 09:15) Pour... 13 Nov 2014, 09:25

JoKerforever Citation (AlbertRaccoon @ 13 Nov 2014, 10... 13 Nov 2014, 09:53

JoKerforever Citation (AlbertRaccoon @ 13 Nov 2014, 10... 13 Nov 2014, 09:53

xpech Citation (JoKerforever @ 13 Nov 2014, 09... 13 Nov 2014, 09:24

xpech Citation (JoKerforever @ 13 Nov 2014, 09... 13 Nov 2014, 09:24

Mac Moins Citation (JoKerforever @ 13 Nov 2014, 10... 14 Nov 2014, 11:37

Mac Moins Citation (JoKerforever @ 13 Nov 2014, 10... 14 Nov 2014, 11:37

Ambroise Citation (jeannot @ 13 Nov 2014, 08:13) C... 13 Nov 2014, 19:18

Ambroise Citation (jeannot @ 13 Nov 2014, 08:13) C... 13 Nov 2014, 19:18

x arena C'est a se demander si les iMac 5K ne tournera... 13 Nov 2014, 08:06

x arena C'est a se demander si les iMac 5K ne tournera... 13 Nov 2014, 08:06

GStepper Comme d'autres le rappellent ici, la comparais... 13 Nov 2014, 10:01

GStepper Comme d'autres le rappellent ici, la comparais... 13 Nov 2014, 10:01

El Bacho Citation (GStepper @ 13 Nov 2014, 10:01) ... 13 Nov 2014, 14:40

El Bacho Citation (GStepper @ 13 Nov 2014, 10:01) ... 13 Nov 2014, 14:40

JoKerforever Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 13:07

JoKerforever Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 13:07

SartMatt Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 13:58

SartMatt Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 13:58

JoKerforever Citation (SartMatt @ 13 Nov 2014, 14:58) ... 13 Nov 2014, 15:08

JoKerforever Citation (SartMatt @ 13 Nov 2014, 14:58) ... 13 Nov 2014, 15:08

SartMatt Citation (JoKerforever @ 13 Nov 2014, 15... 13 Nov 2014, 15:42

SartMatt Citation (JoKerforever @ 13 Nov 2014, 15... 13 Nov 2014, 15:42

Lionel Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 15:24

Lionel Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 15:24

scoch Citation (Lionel @ 13 Nov 2014, 15:24) Ci... 13 Nov 2014, 18:27

scoch Citation (Lionel @ 13 Nov 2014, 15:24) Ci... 13 Nov 2014, 18:27

macinoe Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 16:14

macinoe Citation (Le vendangeur Masqué @ 13 Nov 2014... 13 Nov 2014, 16:14

SartMatt Citation (r@net54 @ 14 Nov 2014, 16:50) C... 14 Nov 2014, 17:47

SartMatt Citation (r@net54 @ 14 Nov 2014, 16:50) C... 14 Nov 2014, 17:47

scoch Citation (r@net54 @ 13 Nov 2014, 19:02) Q... 14 Nov 2014, 19:33

scoch Citation (r@net54 @ 13 Nov 2014, 19:02) Q... 14 Nov 2014, 19:33

superayate C'est du standard, Apple n'a fait "qu... 13 Nov 2014, 15:15

superayate C'est du standard, Apple n'a fait "qu... 13 Nov 2014, 15:15

El Bacho Ça arrangeait Adobe et Microsoft que Mac OS X tou... 13 Nov 2014, 15:33

El Bacho Ça arrangeait Adobe et Microsoft que Mac OS X tou... 13 Nov 2014, 15:33

superayate Le floorplan de l'A8X est assez surprenant par... 13 Nov 2014, 15:57

superayate Le floorplan de l'A8X est assez surprenant par... 13 Nov 2014, 15:57  |

1 utilisateur(s) sur ce sujet (1 invité(s) et 0 utilisateur(s) anonyme(s))

0 membre(s) :

| Nous sommes le : 17th September 2025 - 06:51 |