Bienvenue invité ( Connexion | Inscription )

|

15 Jan 2015, 23:55 15 Jan 2015, 23:55

Message

#1

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 531 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

A plusieurs reprises nous vous avons rapporté de source très fiables qu'Apple avait dans ses cartons des prototypes totalement fonctionnels de Mac dotés de processeurs ARM.

Un célèbre analyste appelé Ming-Chi Kuo y croit. Mais pour lui, et nous sommes d'accord, Apple n'a pas l'intention de sortir ces machines dans un avenir proche. La société pourrait attendre au moins un an ou deux pour se lancer et prendre un des plus gros paris de son histoire récente. Toujours selon ses informations, Apple aurait besoin de ce temps pour que ses puces ARM soient capables de concurrencer un processeur Core i3 ou un Atom. Cela permettrait à la société de proposer toute une entrée de gamme ARM, le reste devant continuer à tourner sur des processeurs Intel. Cela introduit l'idée qu'Apple puisse avoir deux gammes de Mac avec deux architectures radicalement différentes. Ce serait difficile à gérer et même Microsoft qui avait deux modèles de tablettes Surface, une ARM et une x86 a fini par jeter l'éponge sur le premier modèle, se focalisant sur le second. En effet, on aurait alors des Mac pouvant faire tourner certains logiciels, chose dont les autres modèles ne seront pas capables, un vrai casse-tête même au niveau commercial. Certes, certains imagineront à nouveau un miracle Rosetta mais nous vous rappelons qu'Apple avait réussi ce pari de l'émulation en remplaçant dans tous ses modèles un processeur G4 ou G5 par deux coeurs x86 déjà plus puissants individuellement. Or, il serait aujourd'hui certes possible de proposer un processeur ARM doté de 8 ou 16 cœurs puissants, mais il aurait alors une consommation supérieure à son pendant chez Intel, ce qui réduirait de manière totale son intérêt. Lien vers le billet original -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

16 Jan 2015, 00:08 16 Jan 2015, 00:08

Message

#2

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 15 387 Inscrit : 4 Jan 2006 Lieu : dtq Membre no 52 877 |

Apple a déja eu deux gammes avec deux architectures, voire trois architectures différentes au niveau applicatif, et ça ne pose que peu de problèmes sur les logiciels grand-public (sans code natif)...

C'est peut-être l'occasion pour Apple de rebondir coté technologies et de se différencier des assembleurs de PC, en fait des cabinets de designs (si tant est qu'un parallélépipède rectangle puisse être qualifié de tel), qui font concevoir et fabriquer ailleurs. |

|

|

|

16 Jan 2015, 00:48 16 Jan 2015, 00:48

Message

#3

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

L'analyste en question évoque le passage dans les deux ans, donc entre aujourd'hui et 2017…

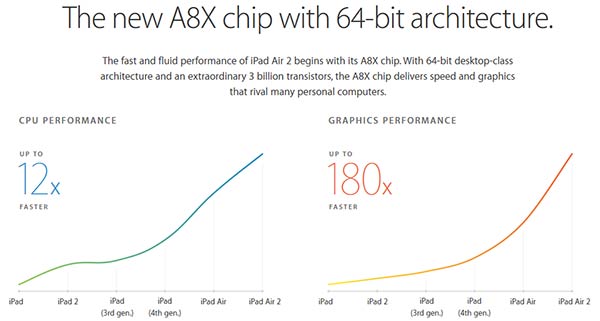

La question ne se pose pas en terme de puissance et l'émulation est une considération archaïque: ce qui tourne sur un iPad air 2 aujourd'hui tourne en ARM et donc la seule différence sera l'interface, celle du Mac étant adaptee a la souris+clavier! Nul besoin d'émulation car les applications seront natives, et la transition se résumera a une case a cocher dans xCode dans le meilleur des cas et a une adaptation de l'interface dans le pire des cas. Rappelons aussi que MacOS n'est pas le premier a passer a ARM, Microsoft l'a fait (même si des considération marketing n'ont pas poussées a la réussite commerciale) et cela fait depuis très longtemps que les Unix, Linux en tête et Android fonctionnent sur ARM et x86… sans que l'utilisateur s'en rendent compte. L'emulation lors des passage du 68k au PowerPC et du PowerPC a Intel était nécessaire du fait que le marche Mac était restreint, que les developpeurs codaient pour un microprocesseur et qu'il n'y avait que le Mac, ses 5% de PDM et c'est tout. Aujourd'hui Apple est un leader avec des milliers de développeurs qui programment depuis des années pour iOS, donc ARM. iOS c'est a 95% MacOS X, la différence majeure étant les API graphiques (UI) et les API de téléphonie (et encore avec Yosemite ça change). Donc aujourd'hui le développeur code pour une API, par pour un jeu d'instructions (enfin c'est moins vrai pour le GPGPU mais ça tend a se normaliser aussi) On a vu d'ailleurs ces dernières années des developpeurs iOS passer leur logiciels sur Mac OS X, et cela, de leurs commentaires, est rapide, même si la réflexion lie au multifenetrage et a la dimension de l'écran peut offrir des opportunités de développement qui nécessitent une petite mise a plat de l'interface. Deja les gros éditeurs ont portes des pans entiers de leurs softs sur iOS... Donc l'émulation est une fausse considération. Niveau de la puissance, c'est pareil. On le voit avec l'iPad Air, dont le processeur est surdimensionne, il fait aussi bien qu'un MBA de 2011 et au niveau graphique il fait mieux. La date de passage sera donc plus marketing et stratégique et économique. Intel aujourd'hui, on le voit avec l'atom, fait des efforts considérables pour résister a l'érosion du PC, tente de rattraper désespérément son absence du mobile, et pour cela encaisse des pertes massives avec ses processeurs mobiles qui sont Il est clair qu'Intel voudra garder Apple comme client le plus longtemps possible et va faire des efforts tarifaires considérables pour maintenir ses core ix dans les Mac. Et de l'autre cote Apple doit pouvoir compter sur ses fournisseurs de SoC de manière fiables pour lui fournir ses processeurs, et on le voit pour l'instant, c'est la guerre entre TSMC et Samsung, avec GF qui arrivera d'ici quelques mois, et Intel qui va fatalement produire de l'ARM. Bref au niveau des considérations techniques, les Mac ARM pourraient arriver a partir de cet été. Apres ce sont donc les considérations stratégiques et marketing qui vont fixer la date. Mais, encore une fois, si le passage du 68k au Power PC a été marquant, celui du PowerPC a Intel, hormis les problème idéologiques, a été bien moins important. Le passage du x86 a l'ARM sera totalement anecdotique et nombre d'utilisateurs ne s'en rendront meme pas compte. De toute façon le mouvement du passage du PC a ARM est en route. On voit ces deux derniers années la multiplication des mini-PC ARM Android/linux, le développement des serveurs ARM, la montée en puissance des appareils mobiles qui concurrence les PC… Bref pour une fois Apple ne sera pas a l'avant garde mais ne fera que suivre la tendance inéluctable en cours... -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

16 Jan 2015, 00:51 16 Jan 2015, 00:51

Message

#4

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 12 576 Inscrit : 25 Nov 2001 Membre no 1 397 |

Nul besoin d'émulation car les applications seront natives, et la transition se résumera a une case a cocher dans xCode dans le meilleur des cas et a une adaptation de l'interface dans le pire des cas. Ben voyons, Apple sort un Mac ARM et hop, c'est magique, toutes les applis deviennent natives. Faut arrêter la moquette ! Ce message a été modifié par zero - 16 Jan 2015, 00:52. |

|

|

|

16 Jan 2015, 00:54 16 Jan 2015, 00:54

Message

#5

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 99 Inscrit : 23 Dec 2005 Membre no 52 213 |

Xcode n'utilise plus le GCC mais le LLVM (Low Level Virtual Machine)

Est-ce qu'une transition a ARM passerait par cette VM ??? |

|

|

|

16 Jan 2015, 01:09 16 Jan 2015, 01:09

Message

#6

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 98 Inscrit : 19 Feb 2012 Membre no 174 700 |

J'ai l'impression que j'en ai pour des années avec Snow...

-------------------- MacOS 7.x ->OSX 10.6.8... Les autres opus ? Toujours pas convaincu.

|

|

|

|

16 Jan 2015, 01:15 16 Jan 2015, 01:15

Message

#7

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 4 894 Inscrit : 24 Apr 2003 Lieu : Depuis chez lui Membre no 7 276 |

Xcode n'utilise plus le GCC mais le LLVM (Low Level Virtual Machine) Est-ce qu'une transition a ARM passerait par cette VM ??? Non, ça reste en fait le nom d'un simple compilateur, qui est simplement mieux optimisé pour Objective C (et sans doute Swift) que ne l'est le GCC. En fait, LLVM n'est plus un sigle et les quatre lettres ne se réfèrent plus forcément à une machine virtuelle, vu que le projet a très vite élargi sa mission par rapport à la vocation du début (j'avais d'abord écrit "initiale" mais c'était ambigu). Je rappelle que les applications disponibles sur OS X (enfin sauf celles en Java) ou iOS sont compilées, à la différence d'Android, qui fonctionne avec une machine virtuelle et une compilation JIT. Là, la question de la transition d'architecture ne se pose plus du tout. Ce message a été modifié par El Bacho - 16 Jan 2015, 01:15. -------------------- « Ayez confiance, je sais ce que je fais. »

|

|

|

|

16 Jan 2015, 01:15 16 Jan 2015, 01:15

Message

#8

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 6 478 Inscrit : 11 Feb 2008 Lieu : Made in Quebec Membre no 107 488 |

J'ai l'impression que j'en ai pour des années avec Snow... T'es pas le seul, je t'assure. Là où je vis, il fait une Snow tempête. ^^ -------------------- « Ce n'est pas le doute, c'est la certitude qui rend fou. » Nietzsche

|

|

|

|

16 Jan 2015, 01:34 16 Jan 2015, 01:34

Message

#9

|

|

可愛い アリゼ      Groupe : Membres Messages : 10 010 Inscrit : 21 Aug 2004 Membre no 22 340 |

À l'ARM et son retard de calendrier, comme à l'alcool qui tue lentement, une seule réponse :

-"On s'en fout, car on n'est pas pressés !"

Ce message a été modifié par Alizés - 16 Jan 2015, 06:40. -------------------- Bisous

|

|

|

|

16 Jan 2015, 02:03 16 Jan 2015, 02:03

Message

#10

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 464 Inscrit : 28 Oct 2008 Membre no 124 517 |

Apple a déja eu deux gammes avec deux architectures, voire trois architectures différentes au niveau applicatif, et ça ne pose que peu de problèmes sur les logiciels grand-public (sans code natif)... C'est tout l'opposé ! Apple ne fournir des outils que pour faire du code natif ! c'est d'ailleurs pour cela qu'ils demandent l'architecture cible DES LE DEBUT D'UN PROJET Xcode. Et c'est bien la le problème, le code natif DEMANDE de l'emulation, non pas comme sur android, qui utilise Java et de la "compilation" a la volée qui simplement transforme le bytecode java en code natif du CPU de la machine (c'est pour cela que android exist sur atom simplement) A l'heure actuelle, tout est possible, la question est principalement : pourquoi le faire ! Si c'est juste pour le fun technique : c'est pas un bonne raison pour Apple Si c'est pour avoir plusieurs architectures : ils en on deja plusieurs, ARM et x86 Si c'est pour du pognon : c'est un bonne raison pour Apple ! Il faut quant meme comparer ce qui est comparable : les CPU ARM Apple sont comparable a des atom, voire des core i3 pas trop rapides, et Apple n'utilise ni l'atom, ni le core i3. La seule raison pour Apple de passer a de l'ARM c'est pour faire des marges plus grosses, mais sur quel type de produit ? les portable bas de gamme genre netbook : Apple ne fera jamais de netbook, c'est trop "bas peuple" Ensuite, vouloir passer sur ARM : pourquoi penser a Mac OS X, et pas simplement iOS avec un portable, tactile : en somme un "ipad pro" avec un clavier a du sens pour attaquer le marche de l'entreprise : gerer les portables comme les tablettes et les telephones portables, avoir la possibilité du tactile, avec l'avantage du multi device, et enfin, des applications (natives) des le debut, la seule difference pouvant etre la RAM (plus grosse) et les connecteurs (USB ?, ou plutôt lightning ;-)) enfin, plus de problème de development de l'architecture car elle propose la meme unique, et l'on un un gamme mobile/portal unique, et surtout des marges bien plus grande car on a la R&D, et on paye uniquement la fabrication du CPU. Non, ça reste en fait le nom d'un simple compilateur, qui est simplement mieux optimisé pour Objective C (et sans doute Swift) que ne l'est le GCC. En fait, LLVM n'est plus un sigle et les quatre lettres ne se réfèrent plus forcément à une machine virtuelle, vu que le projet a très vite élargi sa mission par rapport à la vocation du début (j'avais d'abord écrit "initiale" mais c'était ambigu). Je rappelle que les applications disponibles sur OS X (enfin sauf celles en Java) ou iOS sont compilées, à la différence d'Android, qui fonctionne avec une machine virtuelle et une compilation JIT. Là, la question de la transition d'architecture ne se pose plus du tout. clair, et c'est pour cela qu'en meme temps, cela permet a Apple de gerer certain fonction plus facilement, et de maniere moins problematique, notamment sur la gestion de memoire (Java peut etre tres complique pour la gestion de la memoire, et de ce que l'on appelle le "garbage collector" qui demande enormement de ressource et de temps, encore plus sur des ressources mobiles) au prix d'un programation simplifee en JAVA (pas de gestion de la memoire implicite) |

|

|

|

16 Jan 2015, 07:47 16 Jan 2015, 07:47

Message

#11

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 495 Inscrit : 18 Sep 2007 Membre no 95 094 |

Il faut quant meme comparer ce qui est comparable : les CPU ARM Apple sont comparable a des atom, voire des core i3 pas trop rapides, et Apple n'utilise ni l'atom, ni le core i3. La seule raison pour Apple de passer a de l'ARM c'est pour faire des marges plus grosses, mais sur quel type de produit ? les portable bas de gamme genre netbook : Apple ne fera jamais de netbook, c'est trop "bas peuple" Je pense que les marges qui motivent Apple avec un ARM sont essentiellement celles de l'AppStore. Passer à l'ARM sur un mac n'a clairement aucun intérêt technique : les machines seront très nettement moins rapides qu'avec des x86 et s'ils tentent d'approcher la puissance des processeurs d'entrée de gamme d'Intel alors ces machines, moins efficaces énergetiquement, auront une autonomie inférieure comme on l'a vu récemment avec les constructeurs de Chromebooks. Par contre il s'agira de machine définitivement fermées : seules les applis validées de l'Appstore seront installables. iCloud sera si bien intégré et les SSD seront si petits que personne n'aura envie de se passer de ce genre de services à haute valeur ajoutée. A mon avis un Mac ARM sera inutilisable sans Carte Bleue. |

|

|

|

16 Jan 2015, 07:50 16 Jan 2015, 07:50

Message

#12

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 2 978 Inscrit : 17 Oct 2004 Lieu : Gembloux - Belgique Membre no 25 347 |

Peut-être des Mac ARM tournant sur une nouvelle mouture d'iOS et les autres toujours sous OS X jusqu'à ce que les deux mondes fusionnent en un seul à l'occasion d'une puissance suffisante des ARM... ?

-------------------- People that are crazy enough to think they can change the world are the ones who do FanBoy assumé et défiscalisant Steve Jobs : 1955-2011 ... Remember ! |

|

|

|

16 Jan 2015, 07:56 16 Jan 2015, 07:56

Message

#13

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 495 Inscrit : 18 Sep 2007 Membre no 95 094 |

Et c'est bien la le problème, le code natif DEMANDE de l'emulation, non pas comme sur android, qui utilise Java et de la "compilation" a la volée qui simplement transforme le bytecode java en code natif du CPU de la machine (c'est pour cela que android exist sur atom simplement) Une précision concernant le code natif sur Android : L'essentiel des applications sont développées en Java, et les applications sont distribuées sous forme de bytecode. C'est lors de leur installation qu'elles sont éventuellement recompilées (à partir du bytecode) pour s'adapter à l'architecture de la cible. Par contre les parties d'applications qui réclament de la puissance, ou bien dont ont voudrait limiter la consommation de certains traitements sont développées en C++ et compilées en binaire natif. Dans l'immense majorité des cas elles ne sont compilées que pour les ARM. Intel a développé avec Google des outils qui font de la traduction de binaire ARM vers du x86 et qui permettent d'avoir les deux versions sur Google Play. Cela permet aux Android x86 d'exécuter les applications natives ARM mais c'est loin d'être la panacée. En moyenne la traduction fait perdre 40% d'efficacité par rapport à du cote qui aurait été compilé nativement pour x86. |

|

|

|

16 Jan 2015, 07:57 16 Jan 2015, 07:57

Message

#14

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 117 Inscrit : 4 Oct 2010 Membre no 159 713 |

Je ne vois pas comment cela peut être commercialement tenable de sortir deux gamme comme ça.

Le MacBook Air 12 pouces ou le MacBook Air 13 pouces. Et des logiciels spécifiques qui tourneront que sur l'un ou que sur l'autre. A ce moment là on parle d'iPad Pro (avec un clavier) qui fait tourné iOS avec des applications iOS et ce n'est surtout pas un Mac. Mais peu importe. Je n'ai jamais été intéressé par le MacBook Air, je ne suis donc pas client de ce genre de chose. Soit Apple change toute la gamme de Mac en ARM parce que c'est valable de faire le changement, soit elle n'y touche pas et le tout reste sur Intel. Ce message a été modifié par JoKerforever - 16 Jan 2015, 08:00. |

|

|

|

16 Jan 2015, 08:08 16 Jan 2015, 08:08

Message

#15

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 305 Inscrit : 22 Aug 2001 Lieu : Paris Membre no 668 |

Xcode n'utilise plus le GCC mais le LLVM (Low Level Virtual Machine) Est-ce qu'une transition a ARM passerait par cette VM ??? Non, ça reste en fait le nom d'un simple compilateur, qui est simplement mieux optimisé pour Objective C (et sans doute Swift) que ne l'est le GCC. En fait, LLVM n'est plus un sigle et les quatre lettres ne se réfèrent plus forcément à une machine virtuelle, vu que le projet a très vite élargi sa mission par rapport à la vocation du début (j'avais d'abord écrit "initiale" mais c'était ambigu). Je rappelle que les applications disponibles sur OS X (enfin sauf celles en Java) ou iOS sont compilées, à la différence d'Android, qui fonctionne avec une machine virtuelle et une compilation JIT. Là, la question de la transition d'architecture ne se pose plus du tout. Absolument. Et encore pour Android, on quitte petit à petit le JIT, mais c'est une autre histoire. Bien sur qu'il faudra émuler. Un driver machin-truc: est-ce que le constructeur va le recompiler ? Pour un périphérique qui est 2 ans ? Le "il suffit de recompiler en cochant la case" est une belle illusion qu'Apple donne. Surtout chez Apple qui déprécie 1 framework par an :-) Dans le même temps, Intel ne va pas se laisser faire en 2 ans. Il y a 2 ans, on disait qu'Intel allait se faire bouffer sur le mobile et tablette. Vous avez vu le nombre de machines sous ATOM qui sortent, et à quel prix? Intel a refait son retard en terme de conso CPU, je pense que c'était leur objectif, et c'est pourquoi on stagne en perfo brute. Maintenant que le delta n'est plus tellement significatif, est-ce qu'ils ne vont pas relancer la course à la performance? 2 ans ça peut être long, battre un Core i3 d'aujourd'hui ne servira à rien. De mémoire, il n'y a pas un fondeur qui a su tenir tête à Intel. Apple reste un newbee, avec beaucoup d'argent certes, et sans doutes d'excellentes réalisation sur Ax, mais est-ce que cela va suffire? Donc Mac ARM, peut-être dans 2 ans. Mais perso, je ne suis pas pressé, et surtout, je ne suis pas convaincu que les conditions soient (toujours) favorables, au regard des contraintes que cela va nous imposer. J'ai connu le 68k, le PowerPC, et franchement, je n'ai jamais été aussi satisfait des perfs que depuis que nous sommes sur Intel. Quant au "miracle" de l'émulation, on oublie bien vite. Je vais vous reparler moi du miracle du 7.5.2, des Mac PCI, ou de cette saloperie de PPC Enabler… ou pas… c'est mauvais pour ma tension ;-) -------------------- MBP13 Early 2015 - Core i7.

|

|

|

|

16 Jan 2015, 08:31 16 Jan 2015, 08:31

Message

#16

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 265 Inscrit : 4 Oct 2003 Lieu : Saint Chamond Membre no 10 101 |

Et pourquoi pas le retour de l'iBook tournant sur iOS avec un processeur ARM qui remplacerais le MacBookAir ?

Comme ça on reste dans la logique de deux systemes complémentaire et de deux architechture independante. iOS pourrais prendre en charge de nouvelles fonctions (gestion des fichier et port USB) comme quand l'ipad est arrivé. La rumeur de l'ipad Pro 12" est peu etre lié à la rumeur d'un macbookair 12" c'est peut etre la meme machine ? -------------------- "Photos live"

"Flickr zloran" Mac Os 10.13 / iPad Pro 10.5 512Go / iphone SE 16Go / Apple Watch série 3 (4G) IMac 27" i7 2,8Ghz-8Go + SSD Corsaire 240Go MacBookPro Core 2 Duo 2,16Ghz HD-320Go 4Go |

|

|

|

16 Jan 2015, 08:34 16 Jan 2015, 08:34

Message

#17

|

|

BIDOUILLE Guru      Groupe : Admin Messages : 55 531 Inscrit : 14 Jan 2001 Lieu : Paris Membre no 3 |

En fait, le plus dur n'est pas tant d'imaginer qu'Apple puisse passer à ARM que de gérer sa crainte que la société le fasse.

Comme je l'ai souvent dit, Apple se permet des choses que certains ne pourront jamais faire grâce à ses clients fidèles. Qu'ensuite ils soient obliger de payer et de galérer est presque un détail. Maintenant des Mac ARM ? Pourquoi pas, mais je me demande si je vais prendre ce train comme j'ai déjà renoncé à prendre celui de l'Apple Watch ou du Mac Pro façon corbeille. -------------------- C'est parce que la vitesse de la lumière est plus grande que celle du son que tant de gens paraissent brillants avant d'avoir l'air con

|

|

|

|

16 Jan 2015, 09:22 16 Jan 2015, 09:22

Message

#18

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 464 Inscrit : 28 Oct 2008 Membre no 124 517 |

Il faut quant meme comparer ce qui est comparable : les CPU ARM Apple sont comparable a des atom, voire des core i3 pas trop rapides, et Apple n'utilise ni l'atom, ni le core i3. La seule raison pour Apple de passer a de l'ARM c'est pour faire des marges plus grosses, mais sur quel type de produit ? les portable bas de gamme genre netbook : Apple ne fera jamais de netbook, c'est trop "bas peuple" Je pense que les marges qui motivent Apple avec un ARM sont essentiellement celles de l'AppStore. Passer à l'ARM sur un mac n'a clairement aucun intérêt technique : les machines seront très nettement moins rapides qu'avec des x86 et s'ils tentent d'approcher la puissance des processeurs d'entrée de gamme d'Intel alors ces machines, moins efficaces énergetiquement, auront une autonomie inférieure comme on l'a vu récemment avec les constructeurs de Chromebooks. Par contre il s'agira de machine définitivement fermées : seules les applis validées de l'Appstore seront installables. iCloud sera si bien intégré et les SSD seront si petits que personne n'aura envie de se passer de ce genre de services à haute valeur ajoutée. A mon avis un Mac ARM sera inutilisable sans Carte Bleue. L'apple store n'est qu'un revenue minime de Apple, c'est peanuts, cela "Attire" le client, mais ne lui fait pas debourser du pognon ! clairement : l'avantage c'est de proposer une machine (sous ARM), OS (sous IOS) qui demande pas grand chose, mais surtout, les marges seront enormes sur ce type de machine si il y intel en moins ! dans la cas de la carte mere : pas la peine, tu prends de l'ipad Air dans le cas de l'écran : pas la peine, tu prends de l'ipad air dans le cas du design : pas la peine tu prend du macbook air dans le cas de l'OS : pas la peine tu prend iOS mais la encore, les marges sur le hardware, comme Apple le fait sur les appareil iOS (iPhone/iPad) qui sont superieures car une grosse partie, notamment le CPU et le GPU ne viennent pas de fournisseur externe. il ne faut pas oublier que Apple fait des $$$ avec du hardware, pas du software, car cela ne paie pas, sauf sur du service (abonnement), mais apple est a la ramasse et surtout mauvais (avec mobileMe, mac.com, et maintenant icloud) exemple : Ipad Air 2 - 128GB - wifi + cellular = 825 euros = larges marges Macbook air - 11 pouce 128 GB - wifi = 899 euros = petites marges par contre, un "ipadbook air - 11 pouce 128 GB - wifi + cellular = 899 euros = larges marges ;-) |

|

|

|

16 Jan 2015, 09:35 16 Jan 2015, 09:35

Message

#19

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 392 Inscrit : 12 Dec 2013 Membre no 188 264 |

cet analyste est aussi célèbre pour ses prédictions foireuses

parce que mis à part prédire des sorties d'iphone et d'ipad qui arrivent chaque année aux mêmes dates, il s'est quand même bien loupé sur beaucoup de choses ces 2 dernières années ses annonces relèvent plus de la spéculation que de véritables analyses sourcées |

|

|

|

16 Jan 2015, 09:36 16 Jan 2015, 09:36

Message

#20

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 200 Inscrit : 13 Dec 2004 Lieu : Paris Membre no 28 750 |

Hello,

Que le mac passe a l'ARM me gêne pas plus que ça, au contraire, Apple a beaucoup d'expérience avec les ibildules. Ceci dit, il est clair que ça ne sera pas pour tout le monde, mais avec la généralisation du "clowd" et le fait que les applications vendues par des gros (coucou Adobe) ne soit plus que des abonnements a des machins hébergés, l'applicatif lui même importe peu. Voire même un coup d'Xcode pour faire un "binaire" FAT (le modèle des .app venant de Next permet d'avoir dedans plusieurs version et libs... c'est un peu ça qui fait la force du biniou comparé aux .exe de nos amis aux fenêtres colorées) avec les choses compilées comme il faut. Ceci dit, il faut que quand même Apple arrête de péter les API tout le temps s'ils veulent que les dev lâchent pas l'affaire. D'autre part, vu qu'on voit que Mac OS X (eg 10.10) s'approche de plus en plus a un iOS, on peux largement se demander si le OS X qui fera tourner ces "Mac" sera un iOS avec juste un Finder et impossibilité de faire tourner d'autre chose que ce qui est sur l'App Store. Si c'est le cas, je prendrais le même train que Lionel c'est à dire : rester sur x86, car j'ai besoin de mes applis Unix low level de mon coté et MacPorts m'aide beaucoup (même si le sandbox apple est souvent désactivé car il me gonfle, genre je peux pas faire tourner OpenOffice mais ouais...). Après on peux toujours râler sur les larges marges des produits Apple, mais on a justement des trucs qui ont pris du temps a être développé, et on n'as affaire a des photocopieuses qui copient (plus ou moins bien) les produits d'apple, car rappelons bien : Apple récupère un produit qui ne sert a rien chez Xerox, la souris et son interface graphique, il en fait le Mac, Microsoft se fout d'eux, mais quand même en sous marin il récupère un Mac et fait une copie de Mac OS avec Windows ... On peux parler du NeXt qui est toujours en avance sur l'informatique habituelle, qui a été "simplifié" pour faire OS X (oui simplifié car on gardé les extensions de fichiers et le formats à la con, alors que sur NeXt on pouvais faire des choses bien sans se faire <censored> par "j'ai pas word, j'ai pas pages..." pour ouvrir un document ...)... Reste que quand même OS X est une bonne réussite même si j'aurais aimé qu'on jettes HFS+ pour du ZFS... -------------------- Président Association KAZAR - http://kazar.net/

Mac addict depuis tout petit :p |

|

|

|

16 Jan 2015, 09:38 16 Jan 2015, 09:38

Message

#21

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 392 Inscrit : 12 Dec 2013 Membre no 188 264 |

En fait, le plus dur n'est pas tant d'imaginer qu'Apple puisse passer à ARM que de gérer sa crainte que la société le fasse. Comme je l'ai souvent dit, Apple se permet des choses que certains ne pourront jamais faire grâce à ses clients fidèles. Qu'ensuite ils soient obliger de payer et de galérer est presque un détail. Maintenant des Mac ARM ? Pourquoi pas, mais je me demande si je vais prendre ce train comme j'ai déjà renoncé à prendre celui de l'Apple Watch ou du Mac Pro façon corbeille. beaucoup ont déjà payé cher le passage du G5 à intel en pensant que ce passage serait perenne... |

|

|

|

16 Jan 2015, 09:41 16 Jan 2015, 09:41

Message

#22

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 052 Inscrit : 10 Oct 2005 Membre no 47 611 |

Donc l'émulation est une fausse considération. Sauf que tu oublies un détail, l'aspect économique : on parle d'entrée de gamme, là, donc, des machines destinées essentiellement aux particuliers, et vu la politique tarifaire d'Apple, nombre de ces particuliers risquent de ne pas avoir les moyens de racheter le Mac et tout leur parc logiciel en version ARM, ce qui risque de freiner grandement les ventes de ces Mac ARM ! je me demande si je vais prendre ce train Curieusement, comme je te connais, j'ai du mal à imaginer que, déjà, tu puisse actuellement fonctionner avec des Core i3 Ce message a été modifié par Pascal 77 - 16 Jan 2015, 09:44. -------------------- Un Windows pour les gouverner tous, un Windows pour les trouver, et dans les ténèbres, les lier … Euuh je vais pitêt rester sur Mac !

|

|

|

|

16 Jan 2015, 09:45 16 Jan 2015, 09:45

Message

#23

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 2 127 Inscrit : 7 Mar 2005 Lieu : Brabant wallon, Belgique Membre no 34 620 |

Quid de Carbon lors du passage de MacOS 9 à X (bon là on avait les mêmes processeurs) ou d'Universal Binary lors du passage du PowerPC à Intel? On avait des applications avec double code pour pouvoir être exécutées sur deux architectures différentes. Est-ce si difficile dans le cas d'un passage d'Intel vers ARM? (Ceci dit, je ne vois pas l'intérêt pour moi utilisateur de changer une fois de plus de processeur/plateforme…)

-------------------- MacBook Pro 16 M1Pro | Mac Mini M1 | utilisateur Apple (IIgs puis Macintosh) depuis 1988.

Been There, Done That / Think Different / Our margin: 30%... 20 ans déjà sur Macbidouille ! |

|

|

|

| Guest_dtb06_* |

16 Jan 2015, 10:03 16 Jan 2015, 10:03

Message

#24

|

|

Guests |

[...]Voire même un coup d'Xcode pour faire un "binaire" FAT (le modèle des .app venant de Next permet d'avoir dedans plusieurs version et libs... c'est un peu ça qui fait la force du biniou comparé aux .exe de nos amis aux fenêtres colorées) avec les choses compilées comme il faut.[...] Oui, super, le fait de pouvoir faire des "packages" avec plusieurs versions différentes ne permet en rien au développeur d'éviter d'avoir à les fabriquer pour plusieurs architectures ! De plus, sous Windows, les programmes s'installent souvent avec des installateurs (ce qui au passage est moins classe qu'un glisser-déposer dans le répertoire applis, mais laisse en général moins de merdouilles à la désinstallation). Rien n'empêche d'avoir un installateur qui contient plusieurs versions, par exemple une 32 bits et une 64 bits. Si les versions sont souvent séparées par architecture sur les sites de téléchargement, ce n'est souvent que pour limiter leur poids et la bande passante. Et les EXE, tu es bien gentil, mais je te donne un exemple. Je suis au boulot sous Windows 7, et j'utilise le logiciel Origin version 6 qui date de 1999. Il est en 32 bits, et s'exécute sur toutes les versions de Windows depuis Windows 95, et même sur Windows 10 Preview en 64 bits. Chez moi j'ai un MBP sous 10.6.8 qui date de 2009, et il lui est impossible de lancer certaines applications OSX qui demandent des versions plus récentes, et à l'inverse, si je l'avais mis à jour avec Yosemite par exemple il m'aurait été impossible de lancer des logiciels PPC pas trop vieux pourtant (Warcraft 3 par exemple). Alors la "force du biniou" ne réside sûrement pas dans sa souplesse au niveau des versions. Ce message a été modifié par dtb06 - 16 Jan 2015, 10:08. |

|

|

|

16 Jan 2015, 10:25 16 Jan 2015, 10:25

Message

#25

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 009 Inscrit : 4 Mar 2009 Lieu : Montpellier Odysseum Membre no 132 268 |

Il suffit que ca ne s'appelle plus Mac.

Si ce Mac d'entrée de gamme sous ARM s'appelle iPad Pro au lieu de MacBook Air, et homePad/homePadPro au lieu de MacMini/iMac le tour est joué. Apple aurait 3 gammes de produits: - les iPad avec des applis ARM - les iPad Pro/homePad/homePad Pro avec des applis ARM - des Macs (MacPro et iMac haut de gamme) avec pourquoi pas suffisamment de puissance pour avoir un "rosetta ARM" et pouvoir faire tourner les applis ARM des "homePad". Ainsi pas de problème marketing: Le client qui achète un "ipad version ordinateur" sais qu'il en pourra faire tourner que des applis achetée sur le store (et ne songera jamais à y faire tourner une application "mac"). Ce qu'il faut c'est une offre logicielle adaptée (office, photoshop elements, etc...) afin que la machine soit considerée comme un vrai ordinateur. -------------------- Hack Pro "Quad Core" 2.66 (2009/Nehalem) Core i7 920 + EX58-UD5 + GTX660

Macbook Air, iMac 5K iPad Air 2 Honor 5X (Android 6) |

|

|

|

16 Jan 2015, 10:28 16 Jan 2015, 10:28

Message

#26

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Voire même un coup d'Xcode pour faire un "binaire" FAT (le modèle des .app venant de Next permet d'avoir dedans plusieurs version et libs... c'est un peu ça qui fait la force du biniou comparé aux .exe de nos amis aux fenêtres colorées) avec les choses compilées comme il faut. Un .app n'est rien d'autre qu'un dossier dont le Finder t'empêche de visualiser le contenu directement par double clic... Exactement comme sous Windows ou le dossier d'une application peut contenir un exe 32 bits et un exe 64 bits. Ou même, pour que ça soit transparent, un exe 32 bits et un exe 64 bits cachés, et un troisième exe 32 bits non caché qui servira juste de lanceur pour détecter si la machine est 32 ou 64 bits et aller chercher le bon exe caché. Nul besoin d'émulation car les applications seront natives, et la transition se résumera a une case a cocher dans xCode dans le meilleur des cas et a une adaptation de l'interface dans le pire des cas. Tu sais, il y a des applications qui ne sont jamais passées au x86, donc il y en aura forcément aussi qui ne passeront pas à l'ARM... Par exemple parce que l'éditeur l'a abandonnée (ou carrément parce qu'il n'existe plus...) ou encore parce qu'il voudra en profiter pour vendre une nouvelle version de l'application... Et même quand le portage sera fait, ça va pas être instantané : au lancement, énormément d'applications manqueront !Rappelons aussi que MacOS n'est pas le premier a passer a ARM, Microsoft l'a fait (même si des considération marketing n'ont pas poussées a la réussite commerciale) Ben oui bien sûr, si ça a pas marché, c'est forcément à cause du marketing et cela fait depuis très longtemps que les Unix, Linux en tête et Android fonctionnent sur ARM et x86… sans que l'utilisateur s'en rendent compte. Ah ben oui, forcément, l'utilisateur s'en rend pas compte : dans 99% des cas il tourne en x86...L'emulation lors des passage du 68k au PowerPC et du PowerPC a Intel était nécessaire du fait que le marche Mac était restreint, que les developpeurs codaient pour un microprocesseur et qu'il n'y avait que le Mac, ses 5% de PDM et c'est tout. Sauf qu'une application iOS n'est pas une application OS X. C'est flagrant, regarde la quantité d'applications iOS qui n'ont pas été portées sous OS X et inversement. Ça montre bien que soit c'est pas aussi simple que tu veux bien le faire croire, soit tout simplement que la plateforme OS X n'intéresse pas les développeurs iOS (et c'est clairement pas pour une question d'architecture, il n'y a aucune raison que le passage à l'ARM rende soudain la plateforme plus attractive pour les développeurs iOS).Aujourd'hui Apple est un leader avec des milliers de développeurs qui programment depuis des années pour iOS, donc ARM. Niveau de la puissance, c'est pareil. On le voit avec l'iPad Air, dont le processeur est surdimensionne, il fait aussi bien qu'un MBA de 2011 Dans Geekbench, c'est ça ? Dans la réalité, les processeurs ARM les plus puissants d'aujourd'hui sont encore largement en dessous d'un Core i3. Ils parviennent à dépasser les Atom Bay Trail, mais sont plus proches de ces derniers que des i3... On voit ces deux derniers années la multiplication des mini-PC ARM Android/linux On voit les références se multiplier, parce que ça coûte pas cher à concevoir. Question vente, c'est une autre affaire par contre... En dehors des stick HDMI à brancher aux TV, on ne trouve quasiment aucun PC ARM chez les revendeurs "mainstream" (et encore, même les stick HDMI, on en trouve peu), uniquement chez des revendeurs spécialisés, à la clientèle un peu geek... Et il y a aussi parmi ces geeks beaucoup de déçus du Raspberry Pi qui finissent par se tourner vers des mini-PC x86 pour en avoir un peu plus sous la pédale...

-------------------- |

|

|

|

16 Jan 2015, 11:09 16 Jan 2015, 11:09

Message

#27

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 052 Inscrit : 10 Oct 2005 Membre no 47 611 |

Quid de Carbon lors du passage de MacOS 9 à X (bon là on avait les mêmes processeurs) ou d'Universal Binary lors du passage du PowerPC à Intel? On avait des applications avec double code pour pouvoir être exécutées sur deux architectures différentes. Est-ce si difficile dans le cas d'un passage d'Intel vers ARM? Difficile, non, mais on en revient toujours au problème de l'intégralité du parc applicatif à renouveler, parce que celui qui investit aujourd'hui quelques milliers d'€ (voire quelques dizaines de milliers) n'achète que du code "Intel", le jour où une partie de son parc passe en ARM, il doit tout racheter pour avoir de l'UB, et s'il passe tout son parc en ARM, il doit tout racheter pour avoir de l'ARM ! Tu sais, il y a des applications qui ne sont jamais passées au x86, donc il y en aura forcément aussi qui ne passeront pas à l'ARM... Par exemple parce que l'éditeur l'a abandonnée (ou carrément parce qu'il n'existe plus...) ou encore parce qu'il voudra en profiter pour vendre une nouvelle version de l'application... Et même quand le portage sera fait, ça va pas être instantané : au lancement, énormément d'applications manqueront ! +1 : On a déjà vu ça au passage du PPC à l'Intel, et il y a aussi le cas de nombre d'applications qui n'ont jamais eu de mises à jour "Intel", parce qu'un peu anciennes, leurs éditeurs savaient que les ventes ne pourraient pas amortir les frais du portage, résultat, aujourd'hui, j'ai le choix entre rester sous 10.6.8, ou les abandonner ! Quant à l'émulation, faut pas rêver, j'ai eu l'occasion de tester, à l'époque des premiers Mac Intel, au moyen d'une macro "Excel" spécialement dédiée à cet effet, les performances comparées d'un PowerBook G4 à 1,5 Ghz, avec celles d'un MBP CoreDuo 1,83 Ghz (le tout premier) en émulation PPC (Excel 2004) : c'était à peu près équivalent, grâce, ainsi que ça a été précisé plus haut, à l'écart de performances entre le CoreDuo et le G4, mais j'ai beaucoup de mal à imaginer un processeur ARM capable, en émulation, d'approcher seulement des performances d'un C2D, sans même parler de celles d'un Core i3 ! Ce message a été modifié par Pascal 77 - 16 Jan 2015, 11:30. -------------------- Un Windows pour les gouverner tous, un Windows pour les trouver, et dans les ténèbres, les lier … Euuh je vais pitêt rester sur Mac !

|

|

|

|

16 Jan 2015, 11:35 16 Jan 2015, 11:35

Message

#28

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 1 736 Inscrit : 28 Oct 2008 Membre no 124 528 |

Je suis d'accord avec les analyses qui émettent l'idée qu'à moyen terme, ARM restera cantonné à iOS, et OSX à x86.

Ce qu'on va peut-être observer à court terme, c'est une modification des OS qui pilotent les différents appareils à la pomme. Pour l'instant, iOS ne pilote que les iPhone, iPad et TV; et OSX tous les autres (Air, MB, iMac, MP) On pourrait imaginer qu'Apple veuille étendre le pilotage par iOS et restreindre le périmètre d'OSX. Ainsi on aurait : iOS: TV, iPhone, iPad + iPad Pro + MB Air + mini (je vois bien une fusion à terme de TV et Mini) OSX : MBP/iMac/MP Naturellement, Apple glisserait ainsi jusqu'à ce que iOS/ARM gère tous les appareils grand-public, et OSX mourant à petit feu sur les MBP/iMac/MP qui vont encore Autant Apple que MS tous deux ont intérêt à n'avoir qu'un seul cœur d'OS, et différentes interfaces pour les différents usages. Ainsi la question n'est pas de savoir SI la tendance des OS est au cœur unique, elle l'est, mais plutôt QUAND et surtout COMMENT. Pour Apple, pas de transition radicale je pense, mais plutôt en douceur via une augmentation des appareils pilotés par un coeur iOS/ARM Ce message a été modifié par Webtourist - 16 Jan 2015, 12:10. -------------------- AdBlock désactivé sur MB

|

|

|

|

16 Jan 2015, 11:52 16 Jan 2015, 11:52

Message

#29

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 243 Inscrit : 22 May 2006 Lieu : London-Paris-Brindisi Membre no 61 659 |

La Pomme est un produit perissable !

honetement je ne suis pas presse, meme si cela excite ma curiosite. une nouvelle version de system chassant l'autre, nous perdons le support (maj securite) de ce qui est notre outils de travail. les nouvelles versions n'apportant pas grand chose (si ce n'est des bugs). il est difficile de juste vouloir garder les chose en l'etat avec maj de securite. cette fuite en avant technologique a bien des reverts, Apple est responsable de ne pas avoir su garder une simplicite autour des fontionalites de base. perso je me fous de iOS, le raprochement iOS OsX n'a que des inconvenients (X.9, X.10).Je souhaite garder mes habitudes le plus longtemps possible, meme si je doit me deconnecter avec mon Mac ce qui est possible (mais pas commode). une machine puissante c'est pour produire, une machine ARM pourrait completer a cote pour etre connecter. la principale question etant de ne pas cesser de produire. et la Apple n'aide pas vraiment. Grrrr!!!! -------------------- Entrée dans le réseau Apple en 1984, sortit en 2012. créateur du centre de maintenance Pensée à Paris (1994-2000).

Z77N-wifi , i5 3570k, 16 Go Ram corsair, GT640 evga, alim corsair 430w, boitier cooler master, 256Go SSD Sandisk soit Total hackintosh = 695€ (janvier 2013) RaspberryPi , imprimante 3D, CNC OX, CNC Maslow (800€) Lasercutter K40 (365€) |

|

|

|

16 Jan 2015, 11:53 16 Jan 2015, 11:53

Message

#30

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 130 Inscrit : 28 Nov 2003 Lieu : Paris Membre no 12 035 |

Un .app n'est rien d'autre qu'un dossier dont le Finder t'empêche de visualiser le contenu directement par double clic... À l'intérieur, il y a bien des binaires distincts pour chaque archi. Pas du tout : un .app est effectivement un répertoire contenant l'exécutable et les resources, mais le binaire, lui est bel et bien un binaire "fat", contenant toutes les architectures. Exemple pour l'application Firefox : $ lipo -info /Applications/Firefox.app/Contents/MacOS/firefox Architectures in the fat file: /Applications/Firefox.app/Contents/MacOS/firefox are: x86_64 i386 Et c'est le loader qui choisit l'architecture la plus appropriée, même si tu peux forcer l'ouverture en 32bits. Ce message a été modifié par Tophe974 - 16 Jan 2015, 12:59. |

|

|

|

16 Jan 2015, 12:53 16 Jan 2015, 12:53

Message

#31

|

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 2 330 Inscrit : 8 Oct 2010 Membre no 159 876 |

En fait Apple, pourrait attendre encore un an ou deux ... ça me rappelle quelque chose, les écrans flexible :

En 2010 on commence à nous dire que Samsung a présenté des écran souple "indestructible " … avec une production de masse prévue en 2012. http://www.macbidouille.com/news/2010/07/2...-indestructible EN 2012 on nous annonce la fameuse production de masse … http://www.macbidouille.com/news/2012/03/0...-oled-flexibles EN 2013 on nous annonce que les écrans Samsung se faisant attendrent … ils allaient se faire griller par LG, qui aurait démarré la production en masse de se type d’écran. http://www.macbidouille.com/news/2013/06/2...-fin-de-l-annee Encore en 2013 on nous annonce carrément la guerre (LG vs Samsung), allant même jusqu’à parier que c'est une des choses qu'attend Apple pour son iWatch … http://www.macbidouille.com/news/2013/08/2...ientot-demarrer Q’en est il en 2015 ? soit presque 5 ans après ? Ce message a été modifié par elbacho - 16 Jan 2015, 12:54. |

|

|

|

16 Jan 2015, 12:58 16 Jan 2015, 12:58

Message

#32

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Un .app n'est rien d'autre qu'un dossier dont le Finder t'empêche de visualiser le contenu directement par double clic... À l'intérieur, il y a bien des binaires distincts pour chaque archi. Pas du tout : un .app est effectivement un répertoire contenant l'exécutable et les resources, mais le binaire, lui est bel et bien un binaire "fat", contenant toutes les architectures. Exemple pour l'application Firefox : $ lipo -info /Applications/Firefox.app/Contents/MacOS/firefox Architectures in the fat file: /Applications/Firefox.app/Contents/MacOS/firefox are: x86_64 i386 Et c'est le loader qui choisis l'architecture la plus appropriée, même si tu peux forcer l'ouverture en 32bits. EDIT : j'ai ma réponse sur Wikipedia : "Mac OS X does include the lipo and ditto command-line application to remove versions from the Multi-Architecture Binary image." Je me coucherais moins bête ce soir :-) -------------------- |

|

|

|

16 Jan 2015, 14:03 16 Jan 2015, 14:03

Message

#33

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 3 458 Inscrit : 23 Mar 2004 Lieu : Paris / Vancouver Membre no 16 640 |

Dans le même temps, Intel ne va pas se laisser faire en 2 ans. Il y a 2 ans, on disait qu'Intel allait se faire bouffer sur le mobile et tablette. Vous avez vu le nombre de machines sous ATOM qui sortent, et à quel prix? Intel a refait son retard en terme de conso CPU, je pense que c'était leur objectif, et c'est pourquoi on stagne en perfo brute. Maintenant que le delta n'est plus tellement significatif, est-ce qu'ils ne vont pas relancer la course à la performance? 2 ans ça peut être long, battre un Core i3 d'aujourd'hui ne servira à rien. De mémoire, il n'y a pas un fondeur qui a su tenir tête à Intel. Apple reste un newbee, avec beaucoup d'argent certes, et sans doutes d'excellentes réalisation sur Ax, mais est-ce que cela va suffire? Les quelques machines qui sortent équipées d'Atom existent parce qu'Intel paie une maximum les constructeurs pour qu'ils aient au moins une reference histoire de rassurer les financiers. Ce comportement vide les caisses d'Intel, c'est clairement du dumping et sans ça il n'y aurait pas de mobile avec Atom (on va voir avec les Core M, mais ça risque d'être la meme chose vu les déceptions unanimement constatées sur les premières machines équipées). En plus s'il fallait que les constructeurs financent la R&D pour intégrer une architecture qui se vendra de manière anecdotique ce serait contre productif. Le problème est le meme avec Microsoft et la plateforme WindowsPhone: tant que MS payait pour qu'un constructeur ait une reference il y en avait, mais a l'arrêt des "subventions" les constructeurs laissent tomber et aujourd'hui après des années de subventions en en pure perte 95% des Windows Phone sont des Lumia de Microsoft… Il en va de meme avec les surface, qui pourtant sont sous x86, la conception des versions ARM ayant été abandonnées par MS pratiquement des leur lancement pour des raisons purement marketing. Niveau prix de revient Intel ne peut se confronter aux SoC ARM, ni meme en terme de performance par watt effective. Si ARM a acquis le marche du mobile cela c'est fait sur des années et en convainquant avec des performances et une autonomie remarquable qu'Intel ne peut pas atteindre avec l'architecture x86. En plus Intel n'est pas une société capable de vivre sur un marche concurrentiel, son ADN c'est le monopole, et sur les marches ARM la concurrence est féroce. Apres, lorsque les observateurs constatent qu'un iPad est équivalent en performance a une Macbook Air en terme de puissance, faut se remettre en tete que l'on compare un processeur conçu pour du mobile face a un un Core i5. On ne compare pas un ARM et un Atom. Il en va de meme avec les mini PC ARM qui sortent a foison ces derniers temps: ils sont construit comme des smartphone, pas comme des machines de bureau, et pourtant niveau performance ils tiennent la route. Et finalement si aucun fondeurs faisant du x86 n'a pu tenir face a Intel, c'est grâce aux pratiques anti concurrentielles d'Intel, pratiques qui l'oui on valu des condamnations. Sinon, tous les processeurs AMR, Power, Mips,… ne sont pas produits par Intel: Intel ne produit que du x86, et tous les x86 ne sont pas produit par Intel… Et faut aussi recentrer le débat sur la réalité: on parle aujourd'hui des possibilités qu'Intel aurait pour prendre une petite PDM sur les marches du mobile, de la capacité de résister d'Intel face a l'arrivee d'ARM sur les marches du PC, du serveur, du HPC… Il y a 2 ans évoquer la simple idée qu'un jour ARM équiperait un PC portable faisait passer sont auteur pour un fou, et penser simplement qu'Intel serait menacer sur serveur par AMR était pour quantité de gens inconcevables… maintenant ce ne sont plus des hypothèses et on voit a quel point ces réalités oblige Intel a mener une bataille désespérée pour sauver son x86… En fait Apple, pourrait attendre encore un an ou deux ... ça me rappelle quelque chose, les écrans flexible : En 2010 on commence à nous dire que Samsung a présenté des écran souple "indestructible " … avec une production de masse prévue en 2012. http://www.macbidouille.com/news/2010/07/2...-indestructible EN 2012 on nous annonce la fameuse production de masse … http://www.macbidouille.com/news/2012/03/0...-oled-flexibles EN 2013 on nous annonce que les écrans Samsung se faisant attendrent … ils allaient se faire griller par LG, qui aurait démarré la production en masse de se type d’écran. http://www.macbidouille.com/news/2013/06/2...-fin-de-l-annee Encore en 2013 on nous annonce carrément la guerre (LG vs Samsung), allant même jusqu’à parier que c'est une des choses qu'attend Apple pour son iWatch … http://www.macbidouille.com/news/2013/08/2...ientot-demarrer Q’en est il en 2015 ? soit presque 5 ans après ? La différence c'est que les processeurs ARM sont une réalité économique qui a capte pratiquement 100% du marche, pour l'instant mobile, marche qui aujourd'hui comprend aussi quelques petits PC. Ce que l'on evoque c'est des machines qui aujourd'hui tournent avec des Core i5 et Core i7 qui vont être remplace par des ARM de niveau desktop, et pas des simple Chromebook. Et dans le monde du serveur, ça fait plus de 2 ans que l'architecture en en cours de certification. L'ecran flexible finira par être commercialise, comme l'OLED finira par devenir majoritaire, car les problèmes qui se posent sont au niveau de la production industrielle de masse, pas au niveau de la conception. Et puis on voit aussi une grosse différence, le LCD rigide a toujours une grosse marge d'évolution et les progrès qui sont fait depuis 2 ans sont énorme et constatables. Pour le x86, ce n'est pas le cas, Intel tente de grappiller les derniers recoins d'optimisation mais les core stagnent désespérément depuis Sandy bridge, alors certes les Core ix sont aujourd'hui des SoC dont la partie graphique a fait des énormes propre depuis le GMA, mais niveau core, on est sur la meme puissance qu'il y a 5 ans et en terme de consommation ça n'a pas beaucoup avance en réalité (par contre la gestion électrique elle c'est énormément complexifiee). Du cote d'ARM, avec Apple en tete on voit l'évolution et la marge de progression de cette évolution qui n'est même pas en terme d'optimisation mais bien de progression de puissance et d'innovation d'architecture... Pour ARM la grosse difficulté pour qu'il se répande sur PC était le passage a 64 bit, Apple a pris tout le monde cours en sortant une version 64 bit au moins 2 a 3 ans en avance sur le calendrier prévu, et on voit que les concurrents peine a rattraper leur retard, et alors qu'Apple travaille a l'optimisation de son architecture 64 bit, les autre essayent encore de faire en sorte que ça marche, et c'est pas gagne. Mais d'ici 6 mois chaque producteur aura un ARM 64, et la ça va sérieusement menacer le x86. Ce message a été modifié par r@net54 - 16 Jan 2015, 14:11. -------------------- Agnostique multipratiquant: Unixs, Linux, Mac OS X, iOS et un peu de Windows. Des Macs, des iDevices, des PC et des "ordinosaures"…

Citation « Celui qui t’entretient des défauts d’autrui entretient les autres des tiens. », Diderot« Quand on suit une mauvaise route, plus on marche vite, plus on s'égare. » |

|

|

|

16 Jan 2015, 14:08 16 Jan 2015, 14:08

Message

#34

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 99 Inscrit : 23 Dec 2005 Membre no 52 213 |

Est-ce qu'une transition a ARM passerait par cette VM ??? LLVM n'est plus un sigle et les quatre lettres ne se réfèrent plus forcément à une machine virtuelle, vu que le projet a très vite élargi sa mission par rapport à la vocation du début (j'avais d'abord écrit "initiale" mais c'était ambigu). Merci, je doutais un peu du VM du nom :-) D'un autre cote, dans les codes sources Apple on peut voir certaine app avec les code iOS et Mac dans le même projet. C'est peut être un autre indice ? |

|

|

|

16 Jan 2015, 14:18 16 Jan 2015, 14:18

Message

#35

|

|

Macbidouilleur d'Or !      Groupe : Membres Messages : 4 894 Inscrit : 24 Apr 2003 Lieu : Depuis chez lui Membre no 7 276 |

Q’en est il en 2015 ? soit presque 5 ans après ? Les dates devaient elles-mêmes être flexibles. Je vais aller plus loin que ce que j'avais dit sur le sujet depuis le départ, quitte à me prendre une volée de bois vert de la part de r@net54. Ces rumeurs de transition programmée sont du vent. C'est certain qu'Apple, avec son équipe de développement d'architecture ARM, étudie la faisabilité d'une transition, notamment en cas de percée dans la performance des puces ARM. Ils ont des centaines de personnes qui planchent sur les processeurs Ax, ils peuvent se permettre d'en prendre cinq ou vingt de plus pour mener une veille technologique ou réaliser des prototypes de processeurs ARM à plus forte dissipation thermique destinés à des portables ou des machines de bureau. Avec en parallèle des gens d'OS X qui font des builds sous ARM, déjà que le noyau et quelques API sont très très proches d'iOS sous ARM. Mais il n'y a aucune raison valable pour qu'Apple ait décidé d'entamer la transition des Macs vers une architecture ARM. Les dirigeants actuels sont bien moins capricieux que Steve Jobs, ça n'aiderait absolument pas les parts de marché, et l'utilisateur s'en ficherait au mieux, vu qu'il ne gagnerait rien dans l'affaire. MacBidouille publie des rumeurs en ce sens depuis mai dernier. Si on relit la première, rien dans les affirmations fournies par la source ne s'est vérifié à ce jour : http://www.macbidouille.com/news/2014/05/2...n-a-des-mac-arm Pas d'annonce d'iMac, Mac mini ou MacBook 13 pouces avec processeur ARM. Et aucun nouveau clavier avec un Magic Trackpad grand format, qui n'avait d'ailleurs pas besoin des Macs ARM pour être lancé (et ça serait débile : le Mac mini est fourni sans clavier, et je n'imagine pas une seconde que l'on fasse un clavier prolongé par un Magic Trackpad sur la droite, rien qu'à cause des gauchers, sans parler du fait que les utilisateurs Mac de bureau apprécient encore la souris) Il n'y a pas non plus de site qui a repéré de build étrange d'OS X dans ses logs, fonctionnant sous une architecture non précisée (alors qu'on a déjà des cas de machines sous OS X 10.11). Donc on a des prototypes de Macs qui n'ont jamais été reliés à Internet, tellement c'est un projet secret (mais avancé), et ce projet est parfaitement connu d'une taupe qui a été à Cupertino (ou qui connaît quelqu'un qui a été à Cupertino), qui n'avait contacté que MacBidouille pour diffuser cette info. Mouais, mouais, mouais.... Mouais.... Et pour une rumeur toute aussi fantaisiste de la même source en septembre : http://www.macbidouille.com/news/2014/09/0...ont-en-approche Pour la persistance de ces rumeurs, je vois là trois raisons distinctes : 1) La hype concernant les puces Ax dans laquelle sombrent quelques uns. "Wow ! Les puces A8 d'Apple en 64 bits, elles ont paraît-ils les performances d'un PC. Si ça se trouve, elles pourraient remplacer les puces des Macs ! Alors je vais dire qu'elles vont le faire" 2) La détestation d'Intel façon cour de récré "Intel, c'est caca beurk et has been. Il faut aller sur ces puces ARM, qui seront forcément hyper-méga-meilleures que les Intel, et Apple va certainement vouloir le faire, parce que je déteste Intel." 3) L'envie de jouer à se faire peur "J'aime de moins en moins les choix faits par Apple. Du coup, je vais apporter un peu de crédit à une rumeur abracadabrante, parce que je suis tellement déçu par eux que je me dis qu'ils pourraient carrément faire une grosse connerie comme basculer les Macs sous ARM." Bien entendu, si j'ai tort, et que les Macs ARM débarquent bien d'ici deux ans, je suis prêt, comme le premier réalisateur bavarois venu, à manger mes propres chaussures : http://www.vanityfair.fr/culture/cinema/ar...-paris-perdu/73 -------------------- « Ayez confiance, je sais ce que je fais. »

|

|

|

|

16 Jan 2015, 14:19 16 Jan 2015, 14:19

Message

#36

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 399 Inscrit : 9 Feb 2005 Membre no 32 741 |

... il serait aujourd'hui certes possible de proposer un processeur ARM doté de 8 ou 16 cœurs puissants... Un transatlantique met 5 jours pour aller du Havre à New York, combien faut-il de transatlantiques pour faire le trajet en une demi-journée ? -------------------- je suis écouté, tu es écouté, elle est écoutée, nous sommes tous écoutés

|

|

|

|

16 Jan 2015, 14:40 16 Jan 2015, 14:40

Message

#37

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 1 139 Inscrit : 17 Sep 2010 Membre no 159 100 |

Et s'il s'agissait d'un pas de plus vers l'externalisation des logiciels ? Dans ce cas, peu importe le processeur et l'OS. Vous vous connectez chez Apple et vous utilisez Page, etc… Apple pourrait proposer aux développeurs d'intégrer leur modèle économique. Sachant que les ordinateurs Apple ont de moins en moins de connecteurs, c'est possible voire même probable d'en arriver là à moyen terme.

|

|

|

|

16 Jan 2015, 14:55 16 Jan 2015, 14:55

Message

#38

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

tant que MS payait pour qu'un constructeur ait une reference il y en avait, mais a l'arrêt des "subventions" les constructeurs laissent tomber et aujourd'hui après des années de subventions en en pure perte 95% des Windows Phone sont des Lumia de Microsoft… Il en va de meme avec les surface Il en va de même avec les Surface ? Tu veux dire que 95% des tablettes Windows sont des Surface ? Lol... Les ventes de Surface par rapport aux autres tablettes Windows sont anecdotiques... Le gros du marché, c'est sans doute Asus, dont la T100 a fait un carton (plus d'un an et demi après sa sortie, elle est encore en 9ème position des ventes d'ordinateurs portables chez Amazon...), et Lenovo.Niveau prix de revient Intel ne peut se confronter aux SoC ARM Et pourquoi donc ? Un cœur Bay Trail est plus petit que certains coeurs ARM d'aujourd'hui (par exemple celui de l'A8), donc y a pas de raison qu'il revienne plus cher, et en prime Intel vend aussi des puces bien plus haut de gamme sur lesquelles il peut amortir le gros de ses usines.ni meme en terme de performance par watt effective Ça tu auras beau le répéter, ça ne changera rien au fait que tous les tests faits ces dernières années prouvent le contraire... Intel et ARM sont désormais dans un mouchoir niveau consommation, parfois avec un léger avantage pour Intel, parfois un léger avantage pour des implémentations ARM.En plus Intel n'est pas une société capable de vivre sur un marche concurrentiel, son ADN c'est le monopole, et sur les marches ARM la concurrence est féroce. C'est vrai que sur le marché du HPC, qui était très concurrentiel, Intel n'a pas du tout réussi à vivre. Et encore moins à passer en quelques années d'acteur minoritaire à acteur majoritaire Apres, lorsque les observateurs constatent qu'un iPad est équivalent en performance a une Macbook Air en terme de puissance, faut se remettre en tete que l'on compare un processeur conçu pour du mobile face a un un Core i5. Et faut se mettre en tête que tu compares une machine 10" qui tient 10h de surf avec une batterie de 27 Wh, soit une cosommation moyenne de 2.7W dans cet usage et une machine 13" qui tient 12h de surf avec une batterie de 54 Wh, soit une consommation moyenne de 4.5W... Si tu tiens compte de l'écran plus grand, des I/O bien plus évoluées (les contrôleurs USB, PCI-Express, TB, SATA, etc... ça consomme), on se rend bien compte que l'écart de consommation du CPU n'est pas si grand dans cet usage... Tout en ayant beaucoup plus de souplesse, le CPU étant capable d'offrir des performances nettement supérieures dans les tâches gourmandes.Et finalement si aucun fondeurs faisant du x86 n'a pu tenir face a Intel, c'est grâce aux pratiques anti concurrentielles d'Intel, pratiques qui l'oui on valu des condamnations. Pas seulement. AMD n'a quasiment jamais réussi à faire le poids sur le haut de gamme, là où se font les marches.de la capacité de résister d'Intel face a l'arrivee d'ARM sur les marches du PC, du serveur, du HPC… Cette année, Intel est en croissance de 3% sur le PC, de 25% sur les datacenter... Dure l'arrivée d'ARM Il y a 2 ans évoquer la simple idée qu'un jour ARM équiperait un PC portable faisait passer sont auteur pour un fou, et penser simplement qu'Intel serait menacer sur serveur par AMR était pour quantité de gens inconcevables… maintenant ce ne sont plus des hypothèses Euh si, ce sont toujours des hypothèses. Enfin non, pour toi ça s'apparente plus aux rêves qu'aux hypothèses. Mais pour les gens raisonnables, ça reste des hypothèses. Par exemple, là où ton rêve te fait prétendre qu'une puce ARM d'aujourd'hui pourrait sans problème remplacer un Core i5, la réalité montre que non, et les gens raisonnables font l'hypothèse que dans deux ans Apple aura peut-être enfin une puce ARM dont les performances soient comprises entre un Atom et un Core i3, ce qui lui permettrait de commencer à utiliser du ARM dans les Mac. Du cote d'ARM, avec Apple en tete on voit l'évolution et la marge de progression de cette évolution qui n'est même pas en terme d'optimisation mais bien de progression de puissance et d'innovation d'architecture... Tiens, ça fait longtemps que tu nous en avis pas parlé de cette formidable marge de progression dont tu nous rabâches les oreilles. Mais il suffit pas de le dire, faudrait le prouver qu'elle existe cette marge énorme, alors que les faits commencent à montrer ce que je te dis depuis des années : l'architecture ARM a pu connaitre une forte croissance des performances il y a quelques années, car elle partait de très loin, mais maintenant qu'elle se rapproche des autres, ça s'essouffle et ça progresse beaucoup moins vite... Regarde la courbe de progression des performances des iPhone ou des Nexus, c'est absolument flagrant que les gains s'amenuisent fortement d'année en année... Les modèles 2014 n'ont gagné que 10-20% par rapport à ceux de 2013, et encore, seulement dans les cas les plus favorables...Je vais refaire une analogie que je fait souvent : le gamin qui décide de se mettre à l'athlétisme, c'est des poignées de secondes qu'il va gagner sur le 400m pendant ses premiers mois d'entrainement... Mais plus il va s'approcher des records, plus il va avoir du mal à progresser, la progression ne va plus se compter en secondes, mais en dixièmes puis en centièmes... Et même si au début il s'approchait rapidement du record, il est loin d'être certain qu'il le battra un jour... -------------------- |

|

|

|

16 Jan 2015, 16:15 16 Jan 2015, 16:15

Message

#39

|

|

|

Adepte de Macbidouille  Groupe : Membres Messages : 111 Inscrit : 8 Sep 2008 Membre no 121 187 |

La différence c'est que les processeurs ARM sont une réalité économique qui a capte pratiquement 100% du marche, pour l'instant mobile, marche qui aujourd'hui comprend aussi quelques petits PC. Ce que l'on evoque c'est des machines qui aujourd'hui tournent avec des Core i5 et Core i7 qui vont être remplace par des ARM de niveau desktop, et pas des simple Chromebook Des ARM qui ont la puissance d'un i5 ou i7 desktop? Si tu sais fabriquer de tels processeurs je te conseille de te lancer ; tu vas faire un carton car tu dois bien être le seul. |

|

|

|

16 Jan 2015, 17:25 16 Jan 2015, 17:25

Message

#40

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 495 Inscrit : 18 Sep 2007 Membre no 95 094 |

Les quelques machines qui sortent équipées d'Atom existent parce qu'Intel paie une maximum les constructeurs pour qu'ils aient au moins une reference histoire de rassurer les financiers. Ce comportement vide les caisses d'Intel, c'est clairement du dumping et sans ça il n'y aurait pas de mobile avec Atom (on va voir avec les Core M, mais ça risque d'être la meme chose vu les déceptions unanimement constatées sur les premières machines équipées). Intel fait clairement du dumping mais pas sur les marchés visés par le Core M. Sur le marché mobile (chez Intel ça veut dire "les SoCs munis de modem"), Intel a des SoCs qui sont certes efficaces sur le rapport perf/watts mais qui sont dépourvus de modem intégré : cela impose un surcoût élevé pour l'achat du modem et son intégration au côté du SoC. La politique d'Intel a été de compenser ce surcoût auprès de leurs clients jusqu'à ce qu'ils puissent proposer des SoCs intégrants ces modems (type SoFIA 3G et SoFIA LTE 2). Ils ont fait des pertes massives à cause de cette politique. Les Atoms et les Core M que l'ont trouve sur les tablettes sont eux particulièrement lucratifs pour Intel et leur dernières incarnations ont un rapport performances/watts hors de portée des ARM de Qualcomm ou de Samsung. Il n'y a qu'à voir la déferlante de nouveaux Chromebooks à base de processeurs Broadwell ou Bay-Trail. Même Samsung a annoncé une version musclée de son chromebook 2 11 pouces dont l'ARM (pourtant un Samsung Exynos Octa maison) est remplacé par un Celeron Bay-Trail qui augmente à la fois les performances (beaucoup) et l'autonomie (un peu). |

|

|

|

| Guest_dtb06_* |

16 Jan 2015, 18:33 16 Jan 2015, 18:33

Message

#41

|

|

Guests |

Et on l'a bien vu depuis la chute d'AMD (post -AthlonX2, depuis 2007), Intel se contente d'une progression CPU de 20% de perfs par an. Pas parce qu'ils ne savent pas faire, mais parce qu'ils n'ont plus de concurrence. Du coup ils gardent leurs marges.

Si un ARM arrive un jour à concurrencer frontalement Intel, c'est très simple, ils vont baisser au max le prix des modèles basse conso (Atom, Core Uxxx), peut être en perdant de l'argent dessus, mais en se rattrapant sur le haut de gamme (i7/i5 et surtout Xeon) sur lesquels personne ne les concurrencera. Un .app n'est rien d'autre qu'un dossier dont le Finder t'empêche de visualiser le contenu directement par double clic... À l'intérieur, il y a bien des binaires distincts pour chaque archi. Pas du tout : un .app est effectivement un répertoire contenant l'exécutable et les resources, mais le binaire, lui est bel et bien un binaire "fat", contenant toutes les architectures. Exemple pour l'application Firefox : $ lipo -info /Applications/Firefox.app/Contents/MacOS/firefox Architectures in the fat file: /Applications/Firefox.app/Contents/MacOS/firefox are: x86_64 i386 Et c'est le loader qui choisit l'architecture la plus appropriée, même si tu peux forcer l'ouverture en 32bits. Encore une fois : oui, peut-être qu'il y a les deux dans le paquet, mais ça n'empêche pas qu'il y a quand même un mec à la base qui a été obligé de coder pour deux architectures différentes. Ce n'est pas parce que tu codes un truc pour un processeur ARM que magiquement ton compilateur te sort une version x86 à côté. C'est comme si j'offre un CD et un livre à ma petite cousine, je peux très bien faire un seul paquet global donc un seul cadeau, ça ne m'empêcheras pas d'avoir à acheter les deux séparément ! Ce message a été modifié par dtb06 - 16 Jan 2015, 18:35. |

|

|

|

16 Jan 2015, 18:41 16 Jan 2015, 18:41

Message

#42

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

Et on l'a bien vu depuis la chute d'AMD (post -AthlonX2, depuis 2007), Intel se contente d'une progression CPU de 20% de perfs par an. Pas parce qu'ils ne savent pas faire, mais parce qu'ils n'ont plus de concurrence. Du coup ils gardent leurs marges. L'absence de concurrence est quand même loin d'être la seule raison. Il y en a aussi deux autres, qui jouent sans doute bien plus (car même en l'absence de concurrence, Intel aurait intérêt à augmenter le plus possible les performances, pour pousser au renouvellement et pour limiter le risque qu'un concurrent revienne) :- depuis la débacle du Pentium 4 Prescott, Intel met l'accent sur la consommation, et préfère donc parfois laisser un peu de performances au profit d'une consommation réduite, - les limites de la physique sont ce qu'elles sont, et plus on s'en approche, plus il devient difficile et coûteux de s'en approcher... En particulier, les chaînes de production gravant toujours plus fin sont de plus en plus chères. Encore une fois : oui, peut-être qu'il y a les deux dans le paquet, mais ça n'empêche pas qu'il y a quand même un mec à la base qui a été obligé de coder pour deux architectures différentes. Ce n'est pas parce que tu codes un truc pour un processeur ARM que magiquement ton compilateur te sort une version x86 à côté. Non, pas nécessairement. Il y a quand même énormément de choses qu'on peut faire de façon totalement indépendante de l'architecture sur laquelle ça va tourner. Un programme écrit en C, C++, Objective-C, etc... pourra se compiler quasi indifféremment sur x86 et ARM.C'est surtout quand on a besoin de ne faire aucune concession sur les performances qu'on doit adapter le code spécifiquement à l'architecture cible (même quand on ne code pas directement en assembleur !). Et c'est là qu'il va y avoir un gros problème en cas de passage à l'ARM : non seulement ces optimisations seront à refaire, mais en plus, elles seront beaucoup plus nécessaires, du fait des performances moindres. -------------------- |

|

|

|

16 Jan 2015, 21:45 16 Jan 2015, 21:45

Message

#43

|

|

|

Macbidouilleur de vermeil !     Groupe : Membres Messages : 863 Inscrit : 7 Feb 2012 Membre no 174 401 |

Cela introduit l'idée qu'Apple puisse avoir deux gammes de Mac avec deux architectures radicalement différentes. Ce serait difficile à gérer et même Microsoft qui avait deux modèles de tablettes Surface, une ARM et une x86 a fini par jeter l'éponge sur le premier modèle, se focalisant sur le second. Microsoft a sorti une tablette ARM tout comme Apple a sorti une tablette ARM Dans le cas d'Apple, le monde entier a applaudi des deux mains en félicitant IOS et ses nouvelles applications, et personne, oui, personne, ne s'est émeu que les tablettes iOS ne puissent faire tourner la logithèque OS X Dans le cas de Microsoft, la majorité des gens, et même les plus intelligents et les plus informés, se sont tiraillés de douleur et d'incompréhension comme quoi la surface RT était incapable de faire tourner la logithèque Windows x86 C'est surtout pour ça que Microsoft a jeté l'éponge ... enfin aussi parcequ'en même temps ils ont sorti une surface Pro qui elle était sous x86 avec un vrai Windows, du coup c'était incompréhensible pour les consommateurs. Si Apple avait sorti un iPad PRO sous x86 avec OSX en même temps que l'ipad, ce dernier n'aurait surement pas connu le succès qu'il a eu, et, surtout, les tablettes ne seraient que des ordinateurs sans clavier et avec un stylet, ce qui est, rappelons le, une hérésie Conclusion : la surface Pro est une hérésie -------------------- Machine principale : [NEW] MacBook Pro 14", M1Max / 32Go RAM / 2To SSD 😍😍😍😍 + Ecran Pro Display 32'' 😍😍😍😍😍😍😍😍

Machine complémentaire : Ipad Pro 2020, 11", 256Go + Magic Keyboard 😍😍😍 |

|

|

|

16 Jan 2015, 22:16 16 Jan 2015, 22:16

Message

#44

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 495 Inscrit : 18 Sep 2007 Membre no 95 094 |

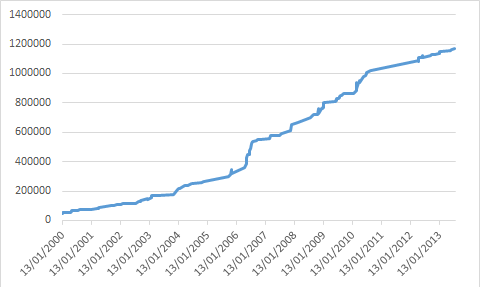

Et on l'a bien vu depuis la chute d'AMD (post -AthlonX2, depuis 2007), Intel se contente d'une progression CPU de 20% de perfs par an. Pas parce qu'ils ne savent pas faire, mais parce qu'ils n'ont plus de concurrence. Du coup ils gardent leurs marges. Dans les faits ils ne gardent pas de marge. L'impression d'une croissance modérée de la puissance provient de la segmentation des offres d'ordinateurs et de processeurs. Apple décide par exemple que les nouveaux Mac mini seront un peu moins puissants que les précédents, alors que les nouveaux processeurs dispos auraient permis de faire très nettement augmenter cette puissance. L'augmentation de la puissance de calcul des processeurs d'Intel, dans le même segment, est forte et continue. Si on se contente de ne regarder que la puissance brute de calcul, sans tenir compte du fait que l'essentiel des gains de puissance ces dernières années s'est fait en dehors du processeur et particulièrement sur les GPU, on obtient tout de même une croissance très supérieure à 20% par an. En prenant les meilleurs scores de chaque année du bench SpecFP Rate pour les machines mono-processeur (en multi on obtiendrait une augmentation encore plus rapide de la puissance de calcul) on obtient : Code SpecFP 2006 Rate Dec-2014 Intel Xeon E5-2699v3 2300Mhz 474 Nov-2013 Intel Xeon E5-2697v2 2700Mhz 345 Jun-2012 Intel Xeon E5-2690 2900Mhz 257 Dec-2011 Intel Core i7-3960X 3300Mhz 200 Nov-2010 Intel Xeon X7560 2267Mhz 141 Oct-2009 Intel Xeon W5590 3333Mhz 108 Nov-2008 Intel Core i7-965 3200Mhz 86.1 Nov-2007 Intel Core 2 QX9650 3000Mhz 52.0 Soit 450% en 5 ans (xeons) bien que la fréquence ait baissé de 30% (dans les faits elle a augmenté mais Intel a tendance à communiquer davantage sur la fréquence minimale). Et si on remonte à 2007, le meilleure score de l'année était tenu par le Pentium D 940 à 3,2Ghz. Il obtenait 18. 7 ans plus tard le Xeon E5-2699 v3 calcule 26 fois plus vite mais il consomme autant d'énergie. |

|

|

|

17 Jan 2015, 00:22 17 Jan 2015, 00:22

Message

#45

|

|

|

Macbidouilleur d'Or !      Groupe : Rédacteurs Messages : 32 233 Inscrit : 15 Nov 2005 Membre no 49 996 |

(dans les faits elle a augmenté mais Intel a tendance à communiquer davantage sur la fréquence minimale) Petite précision : la fréquence minimale garantie en charge, pas minimale tout court ;-)Sur les Haswell, la fréquence minimale est de 800 MHz. Et sur les gammes grand public, Intel communique désormais plutôt sur la fréquence maximale du mode turbo plutôt que sur la fréquence de base. Par exemple, dans la base ARK, le titre des fiches reprend derrière la référence la quantité de cache et la fréquence turbo sur les Core ("8M Cache, up to 4.40 GHz" par exemple pour le i7 4790K, dont la fréquence de base est 4 GHz), alors que pour un Xeon c'est la quantité de cache et la fréquence de base ("15M Cache, 3.50 GHz" par exemple pour le E5-1650v3, qui monte à 3.8 GHz en turbo). -------------------- |

|

|

|

17 Jan 2015, 07:42 17 Jan 2015, 07:42

Message

#46

|

|

|

Macbidouilleur de bronze !   Groupe : Membres Messages : 495 Inscrit : 18 Sep 2007 Membre no 95 094 |

(dans les faits elle a augmenté mais Intel a tendance à communiquer davantage sur la fréquence minimale) Petite précision : la fréquence minimale garantie en charge, pas minimale tout court ;-)Et sur les gammes grand public, Intel communique désormais plutôt sur la fréquence maximale du mode turbo plutôt que sur la fréquence de base. Effectivement. Mais ça paraît plutôt sensé comme communication. Pour le Xeon E5-2699 v3 il est clair que lorsque les 36 threads sont utilisées en pleine charge en continu, la fréquence ne doit pas monter au-dessus des 2,3Ghz de fréquence de base indiqués - et on imagine que ce genre de processeur est destiné à absorber des charges de calcul lourdes et permanentes. J'imagine que pour le Core i7 4790K la mention "up to 4,4Ghz" correspond bien à sa cible ceux qui ont besoin d'une fréquence très élevée même si ça se fait à un moment donné avec des contraintes sur le nombre de coeurs qui atteignent cette fréquence. |

|

|

|

17 Jan 2015, 09:34 17 Jan 2015, 09:34

Message

#47

|

|

|